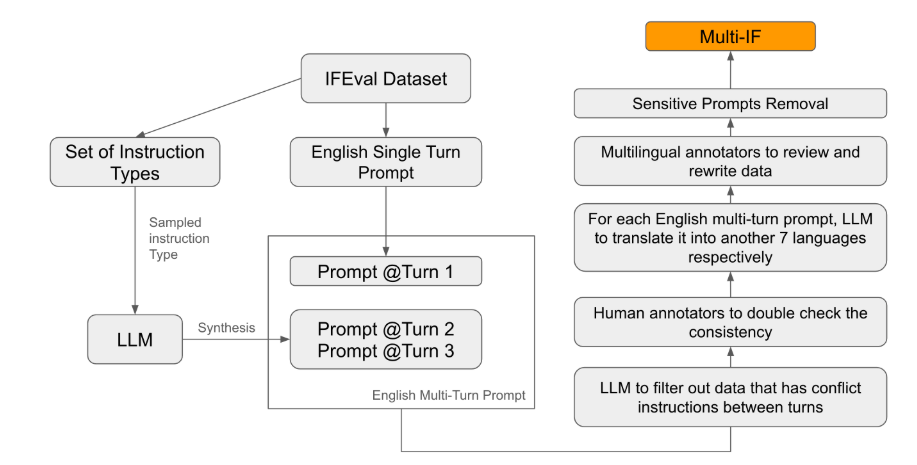

Meta a récemment publié un nouveau benchmark, Multi-IF, conçu pour évaluer la capacité des grands modèles linguistiques (LLM) à suivre les instructions dans des conversations à plusieurs tours et des environnements multilingues. Ce benchmark couvre huit langues et comprend 4501 tâches de conversation à trois tours, mettant l'accent sur les performances des modèles actuels dans des scénarios complexes et multilingues.

La plupart des critères d'évaluation existants se concentrent sur les conversations à un seul tour et les tâches monolingues, ce qui ne reflète pas pleinement les performances des modèles en application réelle. Multi-IF vise à combler cette lacune. L'équipe de recherche a généré des scénarios de conversation complexes en étendant les instructions à un seul tour à plusieurs tours, en veillant à ce que chaque tour d'instruction soit logiquement cohérent et progressif. De plus, l'ensemble de données prend en charge plusieurs langues grâce à la traduction automatique et à la relecture humaine.

Les résultats expérimentaux montrent que la plupart des LLM présentent une baisse significative de leurs performances dans les conversations à plusieurs tours. Prenons l'exemple du modèle o1-preview : son taux de précision moyen est de 87,7 % au premier tour, mais il chute à 70,7 % au troisième tour. Les performances des modèles sont généralement inférieures en anglais pour les langues non latines, telles que l'hindi, le russe et le chinois, ce qui met en évidence leurs limites dans les tâches multilingues.

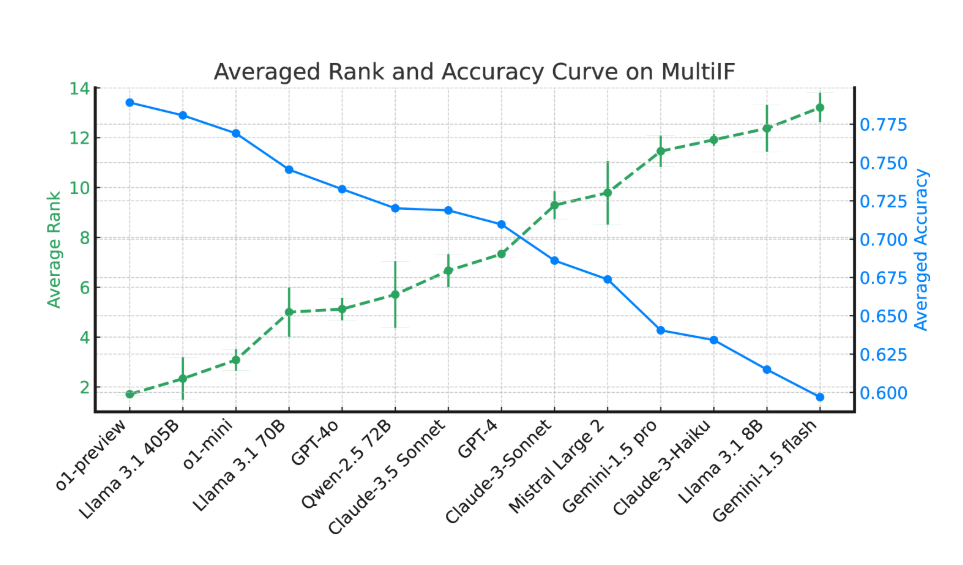

L'évaluation de 14 modèles linguistiques de pointe a révélé que o1-preview et Llama3.1405B affichaient les meilleures performances, avec un taux de précision moyen de 78,9 % et 78,1 % respectivement pour les instructions à trois tours. Cependant, dans les conversations à plusieurs tours, la capacité de suivi des instructions de tous les modèles a diminué globalement, reflétant les défis posés par les tâches complexes. L'équipe de recherche a également introduit le « taux d'oubli des instructions » (IFR) pour quantifier le phénomène d'oubli des instructions dans les conversations à plusieurs tours. Les résultats montrent que les modèles hautes performances sont relativement meilleurs à cet égard.

La publication de Multi-IF offre aux chercheurs un benchmark stimulant qui favorise le développement des LLM dans les applications mondiales et multilingues. Ce benchmark met non seulement en lumière les lacunes des modèles actuels dans les tâches à plusieurs tours et multilingues, mais il fournit également des orientations claires pour les améliorations futures.

Article : https://arxiv.org/html/2410.15553v2

Points clés :

🌍 Multi-IF couvre huit langues et comprend 4501 tâches de conversation à trois tours pour évaluer les performances des LLM dans des scénarios complexes.

📉 Les expériences montrent que la précision de la plupart des LLM diminue considérablement dans les conversations à plusieurs tours, et les performances sont particulièrement faibles pour les langues non latines.

🔍 Les modèles o1-preview et Llama3.1405B affichent les meilleures performances, avec un taux de précision moyen de 78,9 % et 78,1 % respectivement pour les instructions à trois tours.