Dans le domaine de l'intelligence artificielle, en particulier dans les réseaux antagonistes génératifs (AIGC), les progrès constants ont rendu l'interaction vocale une direction de recherche importante. Les grands modèles linguistiques (LLM) traditionnels se concentrent principalement sur le traitement du texte et ne peuvent pas générer directement un discours naturel, ce qui affecte en partie la fluidité des interactions audio entre humains et machines.

Pour surmonter cette limitation, l'équipe Step-Audio a ouvert au public un nouveau grand modèle vocal à la fois complet — Step-Audio-AQAA. Ce modèle peut générer directement un discours naturel et fluide à partir d'entrées audio brutes, rendant les échanges humain-machine plus naturels.

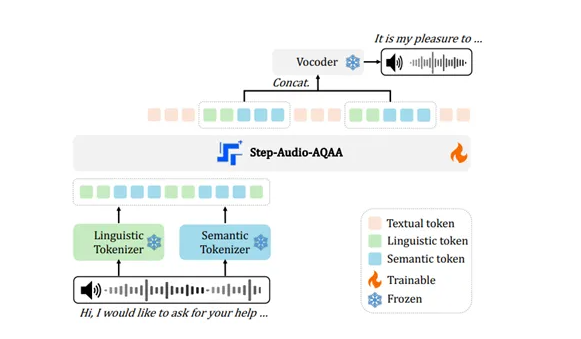

L'architecture de Step-Audio-AQAA est composée de trois modules principaux : un marqueur audio à deux codes, un LLM principal et un synthétiseur neuronal. Le marqueur audio à deux codes convertit le signal audio d'entrée en séquences de marques structurées. Ce module se compose d'un marqueur linguistique et d'un marqueur sémantique ; le premier extrait les caractéristiques structurées du langage, tandis que le second capture les informations paralinguistiques telles que les émotions et l'intonation de la voix. Grâce à ce design à deux codes, Step-Audio-AQAA peut mieux comprendre les informations complexes dans la voix.

Ensuite, ces séquences de marques sont envoyées au LLM principal, Step-Omni. Il s'agit d'un modèle multimodal pré-entraîné avec 130 milliards de paramètres, capable de traiter du texte, de la voix et des images. Ce modèle utilise une architecture décodeuse, permettant de traiter efficacement les séquences de marques provenant du marqueur audio à deux codes. Grâce à une compréhension sémantique approfondie et une extraction de caractéristiques, il prépare la génération d'un discours naturel.

Enfin, les séquences de marques audio générées sont envoyées au synthétiseur neuronal. Ce module consiste à transformer les marques audio discrètes en ondes sonores de haute qualité, utilisant une architecture U-Net pour assurer l'efficacité et la précision dans le traitement audio. Grâce à ce design innovant, Step-Audio-AQAA peut rapidement synthétiser des réponses vocales naturelles et fluides après avoir compris les questions audio, offrant ainsi une meilleure expérience d'interaction aux utilisateurs.

Cette avancée technologique représente une importante progression dans les interactions audio entre humains et machines. L'ouverture au public de Step-Audio-AQAA offre non seulement un outil puissant aux chercheurs, mais pose également les bases solides pour les applications futures de la voix intelligente.

Adresse de l'ouverture : https://huggingface.co/stepfun-ai/Step-Audio-AQAA

Points clés :

🔊 Step-Audio a ouvert au public Step-Audio-AQAA, qui peut générer directement un discours naturel à partir d'entrées audio, améliorant ainsi l'expérience d'interaction humain-machine.

📊 L'architecture du modèle est composée de trois modules : un marqueur audio à deux codes, un LLM principal et un synthétiseur neuronal, permettant de capturer efficacement les informations complexes dans la voix.

🎤 La sortie de Step-Audio-AQAA marque une avancée importante dans la technologie d'interaction vocale, offrant de nouvelles pistes pour les applications futures de la voix intelligente.