Embora os modelos Transformer sejam poderosos, sua eficiência durante a decodificação sempre foi um problema. No entanto, pesquisadores do Instituto de Ciência e Tecnologia da Coreia, LG e DeepMind trouxeram uma ótima notícia: eles propuseram uma nova arquitetura Transformer, chamada Block Transformer, que aumenta a velocidade de decodificação em 10 a 20 vezes!

Como isso foi possível? Eles "dividiram em blocos" o mecanismo de atenção do Transformer. Isso elimina a ineficiência do Transformer original, que acessava o cache global KV a cada token gerado.

Os pesquisadores analisaram as deficiências do Transformer original: a utilização efetiva da GPU era inferior a 1%, com os 99% restantes gastos em acesso à memória. Isso é ineficiente, então eles propuseram o Block Transformer. Esta nova arquitetura, através da decomposição da atenção em nível de bloco e intra-bloco, aumenta drasticamente a taxa de transferência de inferência.

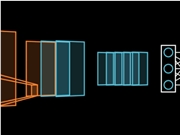

Especificamente, o fluxo de trabalho do Block Transformer é o seguinte: primeiro, a sequência é dividida em blocos; então, um Embedder converte cada bloco em um vetor de embedding. O Block Decoder processa os vetores de embedding dos blocos, capturando dependências globais entre os blocos; o Token Decoder processa as dependências locais entre os tokens, gerando a sequência de tokens.

Este método não apenas aumenta a velocidade de inferência, mas também reduz significativamente o consumo de memória. Alguns usuários relataram ter tido ideias semelhantes, mas com desempenho insuficiente do modelo. Este método parece reduzir efetivamente o cache KV.

Além disso, a precisão do Block Transformer em várias tarefas de zero-shot é comparável ou até ligeiramente superior à do Transformer original de mesmo tamanho, demonstrando que a eficiência foi aumentada sem sacrificar a qualidade.

O significado desta pesquisa vai além disso. Ela também reduz o custo de treinamento do modelo, diminuindo em 16 vezes o custo de acesso à memória da atenção global e aumentando a utilização da GPU de 1% para 44%.

Link do artigo: https://arxiv.org/abs/2406.02657