Künstliche Intelligenz (KI) revolutioniert mit erstaunlicher Geschwindigkeit verschiedene Branchen, und die Videoproduktion bildet da keine Ausnahme. Die jüngste Entwicklung von KI-Videogenerierungsmodellen hat breite Aufmerksamkeit erregt, einige behaupten sogar, dass sie die Zukunft Hollywoods grundlegend verändern werden.

Doch wie leistungsfähig ist diese Technologie tatsächlich? Forscher der Chinese University of Hong Kong und Tencent haben im Rahmen des Projekts „VideoGen-Eval“ eine umfassende Bewertung der derzeit gängigen KI-Videogenerierungsmodelle durchgeführt und das tatsächliche Leistungsniveau dieser neuen Technologie aufgezeigt.

Das Forschungsteam testete die KI-Videogenerierungsmodelle anhand verschiedener Kriterien, darunter die Übereinstimmung von Text und Video, die Bildkomposition, Szenenübergänge, Kreativität, Stilisierung, Stabilität und die Vielfalt der Bewegungen. Die Ergebnisse zeigen, dass die KI zwar in einigen Bereichen bemerkenswerte Fortschritte gemacht hat, aber noch ein langer Weg bis zur Perfektion zu gehen ist.

Vergleich der wichtigsten Videomodelle:

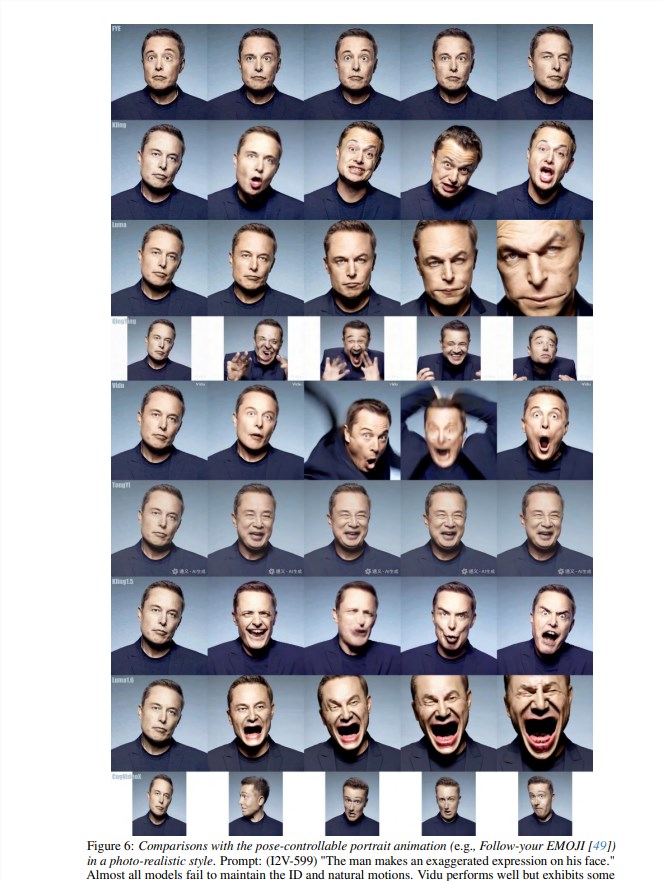

Im Bereich der Text-zu-Video-Generierung (T2V) zeigten Gen-3, Kling v1.5 und Minimax eine hervorragende Leistung. Minimax zeichnet sich besonders durch die Textkontrolle aus, insbesondere bei der Generierung von Gesichtsausdrücken, Kameraführung, Mehrfachkameraperspektiven und der Dynamik des Hauptmotivs.

Gen-3 überzeugt durch die Steuerung von Beleuchtung, Texturen und filmtechnischen Aspekten, während Kling v1.5 ein gutes Gleichgewicht zwischen visueller Qualität, Steuerbarkeit und Bewegungsfähigkeit findet.

Pika 1.5 zeigt besondere Stärken bei der Generierung bestimmter Videoeffekte wie z. B. Ausdehnung, Schmelzen und Explosionen.

Vergleichsvideos:

Eingabeaufforderung: Statische Kamera, eine Glaskugel rollt auf einer glatten Tischplatte

Eingabeaufforderung: FPV-Flugaufnahme, Sonnenschein auf schneebedeckten Bergen, ruhige Atmosphäre

Eingabeaufforderung: Hyper-schnelles Zoomen auf eine rote Rose und Darstellung der Details der Blütenblätter

Derzeit gibt es hauptsächlich zwei Arten von KI-Videogenerierungsmodellen auf dem Markt: Closed-Source und Open-Source. Closed-Source-Modelle sind vergleichbar mit den Geheimrezepten von High-Tech-Unternehmen, wie z. B. Gen-3 von Runway und Dream Machine von LumaLabs. Diese Modelle erzeugen in der Regel Videos von höherer Qualität und verfügen über leistungsfähigere Funktionen, aber man muss dafür bezahlen.

Open-Source-Modelle hingegen sind wie öffentlich zugängliche Kampfkunst-Handbücher, die jeder lernen kann, z. B. Open-Sora und EasyAnimate. Obwohl die Ergebnisse möglicherweise nicht so gut sind wie bei Closed-Source-Modellen, sind sie kostenlos und Open Source, sodass jeder mitmachen kann.

Das Projekt „VideoGen-Eval“ testete verschiedene KI-Videogenerierungsmodelle in drei Bereichen: Text-zu-Video (T2V), Bild-zu-Video (I2V) und Video-zu-Video (V2V). Die Ergebnisse zeigten, dass diese Modelle zwar in einigen Bereichen große Fortschritte gemacht haben, z. B. bei der Bildqualität, der Natürlichkeit der Bewegungen und der Übereinstimmung mit der Textbeschreibung, aber noch weit von der perfekten Umsetzung entfernt sind!

Beginnen wir mit den Vorteilen: Die heutige KI kann bereits einfache Videos erstellen. Wenn man beispielsweise „Ein Teddybär läuft in einem Supermarkt herum, die Kamera dreht sich gegen den Uhrzeigersinn“ eingibt, kann die KI ein Video mit einem rotierenden Teddybär generieren. Klingt ziemlich erstaunlich, nicht wahr? Wenn man jedoch die KI komplexe Szenen generieren lassen möchte, z. B. „Eine Person schwimmt in einem Schwimmbad, Wasser spritzt“, oder „Drei Affen springen im Wald herum, zwei Papageien fliegen durch das Geäst“, dann versagt die KI.

Der Hauptgrund dafür liegt darin, dass die KI physikalische Gesetze, räumliche Beziehungen und Objekteigenschaften noch nicht ausreichend versteht. Wenn man die KI beispielsweise ein Video von „einer Glaskugel, die auf einem Tisch rollt“ generieren lässt, weiß die KI möglicherweise nicht, wie die Glaskugel physikalisch korrekt rollen sollte, und das resultierende Video wirkt dann seltsam.

Darüber hinaus hat die KI auch große Probleme mit der Verarbeitung von schnellen Bewegungen, Gesichtsausdrücken und der Interaktion mehrerer Personen. Wenn man beispielsweise die KI ein Baseballspiel generieren lassen möchte, könnte das Ergebnis sehr unnatürlich wirken, die Bewegungen der Personen wären völlig unkoordiniert, und der Baseball könnte sogar in den Himmel fliegen.

Ganz zu schweigen von Szenen, die die Vorstellungskraft und Kreativität der KI erfordern. Wenn man beispielsweise die KI ein Video von „einer Person, die von bunten Rauchschwaden umgeben ist“ generieren lassen möchte, erzeugt die KI möglicherweise nur ein Durcheinander von Farben, ohne erkennbare Form. Zusammenfassend lässt sich sagen, dass keines der aktuellen Modelle perfekt ist und bei der Verarbeitung komplexer Bewegungen, der Interaktion mehrerer Objekte, der physikalischen Simulation, dem semantischen Verständnis und der präzisen Steuerung noch große Herausforderungen bestehen.

Kompletter Testbericht (Video): https://ailab-cvc.github.io/VideoGen-Eval/#text-to-video