Am 4. Juli 2025 setzt KUNLUN WANWEI seine Open-Source-Strategie fort und veröffentlicht die zweite Generation des Belohnungsmodells Skywork-Reward-V2. Diese Serie umfasst acht Belohnungsmodelle, die auf unterschiedlichen Basismodellen basieren und mit Parametern von 600 Millionen bis 8 Milliarden variieren. Kaum auf den Markt gekommen, erreichte es in sieben führenden Bewertungssystemen für Belohnungsmodelle einen Sieg und wurde zum Fokus im Bereich der Open-Source-Belohnungsmodelle.

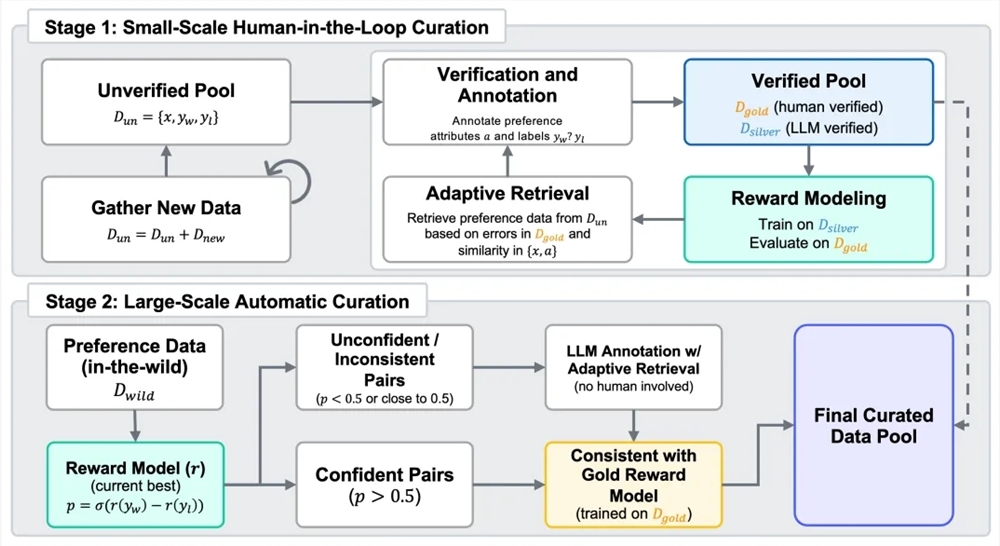

Belohnungsmodelle spielen eine entscheidende Rolle im Prozess des Verstärkenden Lernens aus menschlicher Rückmeldung (RLHF). Um ein neues Belohnungsmodell zu entwickeln, hat KUNLUN WANWEI ein gemischtes Datensatz-Skywork-SynPref-40M erstellt, der 40 Millionen Paare von Präferenzvergleichen enthält. Bei der Datenverarbeitung nutzte das Team einen zweistufigen Prozess mit menschlichem und maschinellem Zusammenarbeiten, um die hohe Qualität der menschlichen Annotation mit der Skalierbarkeit der Modellverarbeitung zu kombinieren. In der ersten Phase wurde zunächst ein nicht verifiziertes Anfangspräferenzpool gebildet. Mit Hilfe großer Sprachmodelle wurden ergänzende Attribute generiert. Danach überprüften menschliche Nutzer unter strengen Protokollen und mit externen Tools sowie großen Sprachmodellen bestimmte Daten sorgfältig und bildeten ein kleines, hochwertiges „Goldstandard“-Datenset. Anschließend leitete das Goldstandard-Datenset die Erzeugung von hochwertigen „Silberstandard“-Daten durch große Sprachmodelle ein und optimierte es in mehreren Iterationen. In der zweiten Phase erfolgte der Übergang zu einer automatisierten, großflächigen Datenvergrößerung. Das fertige Belohnungsmodell führte eine Konsistenzfilterung durch und reduzierte gleichzeitig den Aufwand für menschliche Annotation, wodurch ein Gleichgewicht zwischen der Größe und Qualität der Präferenzdaten erreicht wurde.

Die Skywork-Reward-V2-Serie, die auf qualitativ hochwertigen gemischten Präferenzdaten entwickelt wurde, zeigt breite Anwendbarkeit und hervorragende Leistungsfähigkeit. Sie umfasst verschiedene Dimensionen wie allgemeine Ausrichtung auf menschliche Präferenzen, objektive Richtigkeit, Sicherheit, Widerstandsfähigkeit gegen Stilabweichungen sowie die Fähigkeit, Best-of-N-Aufgaben zu bewältigen. In sieben führenden Bewertungsbereichen für Belohnungsmodelle wie Reward Bench v1/v2, PPE Preference & Correctness, RMB, RM-Bench und JudgeBench erreichte sie insgesamt den aktuellen State-of-the-Art (SOTA)-Stand. Selbst das kleinste Modell der Serie, Skywork-Reward-V2-Qwen3-0.6B, erreicht nahezu das Durchschnittsniveau des stärksten Modells der vorherigen Generation. Skywork-Reward-V2-Qwen3-1.7B übertreffen sogar den SOTA-Standard aktueller Open-Source-Belohnungsmodelle. Das größte Modell der Serie, Skywork-Reward-V2-Llama-3.1-8B, übertrifft in allen führenden Bewertungstests klar und wird zum besten Open-Source-Belohnungsmodell mit der besten Gesamtleistung.

Die Serie besitzt auch eine breite Abdeckung vielfältiger menschlicher Präferenzen. Auf allgemeinen Präferenzbewertungsbenchmarks schneidet sie besser ab als Modelle mit höherer Parameterzahl und neuere Generations-Belohnungsmodelle. Im Hinblick auf objektive Richtigkeit zeigte sich besonders starke Leistung bei wissensintensiven Aufgaben. In verschiedenen hochentwickelten Fähigkeitsbewertungen, einschließlich Best-of-N-Aufgaben, Tests zur Widerstandsfähigkeit gegen Vorurteile, komplexer Befehlsverständnis und Echtheitsbeurteilung, erzielte sie führende Ergebnisse und zeigte ausgezeichnete Verallgemeinerungsfähigkeit und Praxistauglichkeit.

Außerdem steigert die hohe Skalierbarkeit des Datenauswahlprozesses deutlich die Leistungsfähigkeit der Belohnungsmodelle. Die nach sorgfältiger Auswahl und Filterung erhaltenen Präferenzdaten können in mehreren Trainingsiterationen kontinuierlich die Gesamtleistung der Modelle verbessern, insbesondere in der automatisierten Datenvergrößerung der zweiten Phase. Frühere Experimente zeigten, dass selbst mit nur 1,8 % hochwertiger Daten ein 8B-modell die Leistung eines 70B-Modells mit aktueller SOTA übertraf, was die Vorteile des Skywork-SynPref-Datensatzes in Bezug auf Umfang und Qualität bestätigt.

HuggingFace-Adresse:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHub-Adresse:

https://github.com/SkyworkAI/Skywork-Reward-V2