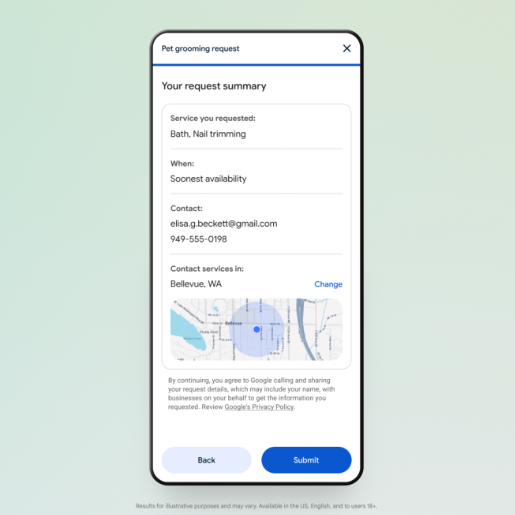

Apple lanzó una bomba en Hugging Face: la demostración de su modelo 4M, presentado el año pasado. Este modelo puede procesar y generar contenido multi-modal, incluyendo texto, imágenes y escenas 3D. Un solo modelo puede descomponer toda la información de una imagen, incluyendo mapas de profundidad y bocetos lineales. AIbase lo probó con una imagen de estilo antiguo que generaron previamente, y los resultados fueron impresionantes. Tras subir la imagen, rápidamente obtuvieron la siguiente información descompuesta:

Con solo subir una foto, puedes obtener fácilmente toda la información de la misma, como el contorno principal, la gama de colores predominante y las dimensiones de la imagen.

Para Apple, esto representa un giro audaz en su tradicional secretismo en materia de I+D. No solo exhiben su potencia en IA en la plataforma de código abierto Hugging Face, sino que también extienden una rama de olivo a los desarrolladores, esperando construir un ecosistema alrededor de 4M. La arquitectura multi-modal de 4M presagia la aparición de aplicaciones de IA más coherentes y multifuncionales en el ecosistema de Apple, como un Siri capaz de procesar consultas complejas de forma más inteligente, o un Final Cut Pro que edite videos automáticamente según instrucciones de voz.

Sin embargo, el lanzamiento de 4M también presenta desafíos en cuanto a la práctica de datos y la ética de la IA. Apple siempre se ha presentado como un guardián de la privacidad del usuario, pero ¿se pondrá a prueba su postura frente a un modelo de IA tan intensivo en datos? Apple debe equilibrar cuidadosamente el avance tecnológico con la preservación de la confianza del usuario.

Analicemos brevemente los principios técnicos de 4M. El mayor atractivo de 4M radica en su método de entrenamiento de "modelado de enmascaramiento multi-modal a gran escala". Este método permite procesar simultáneamente múltiples modalidades visuales, ya sean imágenes, semántica o información geométrica, convirtiéndolas en tokens unificados para lograr una integración perfecta entre las modalidades.

Durante el entrenamiento, 4M utiliza un método ingenioso: selecciona aleatoriamente una parte de las etiquetas como entrada y otra parte como objetivo, logrando así la escalabilidad del objetivo de entrenamiento. Esto significa que, tanto las imágenes como el texto, para 4M son solo una cadena de etiquetas numéricas. Este diseño mejora considerablemente la versatilidad del modelo.

Los datos y métodos de entrenamiento de 4M también merecen mención. Utilizó CC12M, uno de los conjuntos de datos de código abierto más grandes del mundo. Aunque este conjunto de datos es abundante, la información de etiquetado no es perfecta. Para solucionar esto, los investigadores utilizaron un método de pseudo-etiquetado con supervisión débil, utilizando técnicas como CLIP y MaskRCNN para realizar predicciones exhaustivas en el conjunto de datos, y luego convirtiendo los resultados de la predicción en tokens, sentando así las bases para la compatibilidad multi-modal de 4M.

Tras extensas pruebas y experimentos, 4M ha demostrado su capacidad para ejecutar tareas multi-modales directamente, sin necesidad de un extenso pre-entrenamiento o ajuste fino para tareas específicas. Es como darle a la IA una navaja suiza multi-modal, permitiéndole abordar diversos desafíos con flexibilidad.

Dirección de la demostración: https://huggingface.co/spaces/EPFL-VILAB/4M