Meta AI acaba de anunciar el lanzamiento de su nueva generación de Segment Anything Model (SAM2), un avance tecnológico que facilita enormemente la identificación y el seguimiento en tiempo real de objetos específicos en vídeos e imágenes.

La principal ventaja de SAM2 reside en su capacidad de segmentación de objetos rápida y precisa, tanto en imágenes estáticas como en vídeos dinámicos. Este modelo no solo identifica y segmenta objetos individuales en imágenes, sino que también realiza un seguimiento en tiempo real de los objetos en flujos de vídeo, incluso si esos objetos no aparecieron durante la fase de entrenamiento. La interactividad en tiempo real de SAM2 le otorga un amplio potencial en áreas como la edición de vídeo y la creación de contenido multimedia interactivo.

Emplea un diseño de arquitectura unificada, sin necesidad de entrenamiento separado para imágenes y vídeos, pudiendo procesar simultáneamente ambos tipos de tareas de segmentación. Este diseño mejora considerablemente la versatilidad y eficiencia del modelo, ofreciendo un potente soporte para diversas aplicaciones visuales.

Lo más sorprendente es la capacidad de procesamiento en tiempo real de SAM2. Tanto en fotogramas de vídeo que cambian rápidamente como en imágenes estáticas complejas, SAM2 puede identificar y segmentar objetos a una velocidad de 44 fotogramas por segundo. Este rendimiento en tiempo real revoluciona las posibilidades en la edición de vídeo y la interacción en directo.

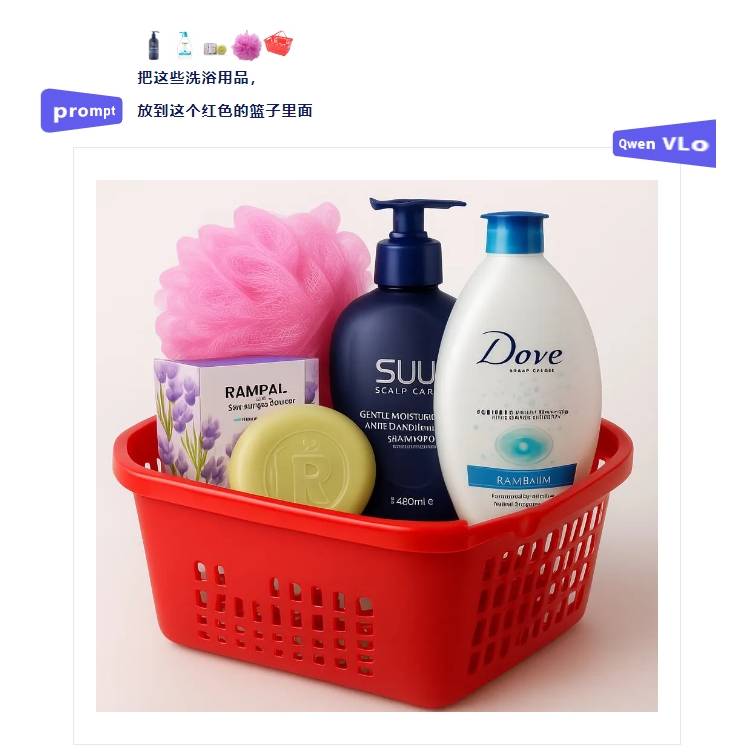

SAM2 también cuenta con una potente función de segmentación con indicaciones. Los usuarios pueden dar instrucciones al modelo mediante simples clics o selecciones de cuadro, controlando con precisión el proceso de segmentación. Esta facilidad de interacción humano-máquina aumenta considerablemente la eficiencia del etiquetado de datos, ofreciendo una herramienta eficaz para el procesamiento a gran escala de datos visuales.

SAM2 posee una notable capacidad de generalización de cero ejemplos. Incluso ante objetos o escenas no encontradas durante el entrenamiento, SAM2 puede identificarlos y segmentarlos con precisión. Esta adaptabilidad permite que SAM2 desempeñe un papel destacado en diversas aplicaciones prácticas, desde la vida cotidiana hasta ámbitos profesionales.

En el procesamiento de vídeo, SAM2 incorpora un innovador módulo de memoria de sesión. Incluso si el objeto objetivo desaparece temporalmente del campo de visión, el modelo mantiene el seguimiento. Esta capacidad de seguimiento continuo aporta una comodidad sin precedentes al análisis y edición de vídeo.

Meta AI ha empleado mecanismos de memoria avanzados en el desarrollo de SAM2, incluyendo un codificador de memoria, una biblioteca de memoria y un módulo de atención de memoria. Estos diseños mejoran significativamente la coherencia y precisión del modelo en la segmentación de vídeo, haciendo que el procesamiento de vídeos largos y complejos sea más fiable.

Para impulsar el desarrollo de toda la comunidad de IA, Meta AI no solo ha publicado el código y los pesos del modelo de SAM2, sino que también ha hecho público el conjunto de datos SA-V, que contiene aproximadamente 51.000 vídeos y más de 600.000 máscaras espacio-temporales. Esta actitud abierta acelerará sin duda el progreso de la tecnología de IA visual.

Las perspectivas de aplicación de SAM2 son inmensas. En la edición de vídeo, puede aumentar considerablemente la eficiencia de la postproducción; en la tecnología de conducción autónoma, permite una identificación más precisa del entorno vial; en la investigación médica, puede ayudar a los médicos a realizar análisis de imágenes más precisos; y en investigación científica, vigilancia de seguridad, creación de contenido y formación educativa, SAM2 muestra un enorme potencial.

Sin embargo, con la aparición de una herramienta de análisis visual tan potente, también debemos reflexionar sobre cuestiones importantes. ¿Cómo proteger la privacidad mientras se aumenta la eficiencia? ¿Cómo garantizar que esta tecnología se utilice correctamente y no se abuse de ella? Estas son preguntas que debemos considerar seriamente mientras abrazamos las nuevas tecnologías.

Dirección del sitio web: https://ai.meta.com/blog/segment-anything-2/

Página de demostración del proyecto: https://sam2.metademolab.com/

Descarga del modelo: https://github.com/facebookresearch/segment-anything-2