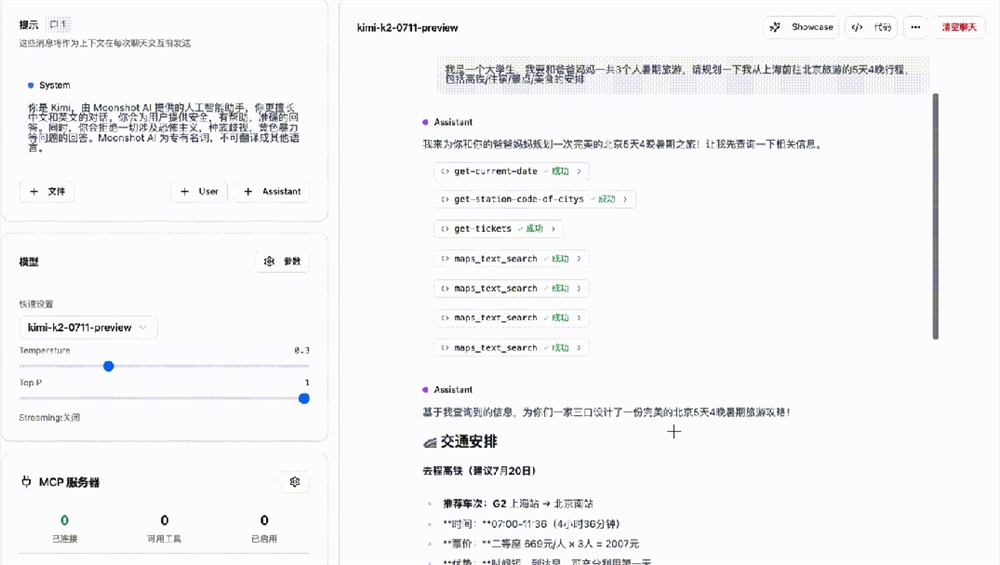

Con la creciente integración de la inteligencia artificial en los flujos de trabajo y productos empresariales, la demanda de plataformas de operaciones de aprendizaje automático (MLOps) está en constante aumento. Estas plataformas ayudan a las empresas a crear, probar e implementar modelos de aprendizaje automático con mayor facilidad. Sin embargo, a pesar de la presencia de numerosos competidores en el mercado, como las startups InfuseAIComet y gigantes como Google Cloud, Azure y AWS, la empresa surcoreana VESSL AI busca encontrar su propio nicho al centrarse en la optimización de los costes de las GPU.

Nota de la imagen: Imagen generada por IA, proveída por Midjourney

Recientemente, VESSL AI cerró una ronda de financiación Serie A de 12 millones de dólares para acelerar el desarrollo de su infraestructura, dirigida principalmente a empresas que desean desarrollar modelos de lenguaje extenso (LLM) personalizados y agentes de IA verticales. La compañía ya cuenta con 50 clientes empresariales, entre los que se incluyen empresas de renombre como Hyundai Motor, LIG Nex1 (un fabricante aeroespacial y de armas de Corea del Sur) y TMAP Mobility (una empresa conjunta entre Uber y SK Telecom). Además, VESSL AI ha establecido colaboraciones estratégicas con empresas estadounidenses como Oracle y Google Cloud.

El equipo fundador de VESSL AI está compuesto por Jaeman Kuss An (CEO), Jihwan Jay Chun (CTO), Intae Ryoo (CPO) y Yongseon Sean Lee (responsable de tecnología). Antes de fundar la empresa, trabajaron en empresas de renombre como Google, PUBG y varias startups de IA. An, durante el desarrollo de modelos de aprendizaje automático en su anterior empresa de tecnología médica, descubrió lo engorroso y costoso que era el proceso, lo que les llevó a decidir utilizar una infraestructura híbrida para mejorar la eficiencia y reducir los costes.

La plataforma MLOps de VESSL AI emplea una estrategia multicanal, utilizando GPU de diferentes proveedores de servicios en la nube para ayudar a las empresas a reducir sus gastos en GPU hasta en un 80%. Este enfoque no solo resuelve el problema de la escasez de GPU, sino que también optimiza el entrenamiento, la implementación y la operación de los modelos de IA, especialmente la gestión de los modelos de lenguaje extenso. An menciona que el sistema puede seleccionar automáticamente los recursos más rentables y eficientes, ahorrando costes a los clientes.

El producto de VESSL cuenta con cuatro funciones principales: VESSL Run (automatización del entrenamiento de modelos de IA), VESSL Serve (soporte para la implementación en tiempo real), VESSL Pipelines (integración del entrenamiento de modelos y el preprocesamiento de datos para simplificar los flujos de trabajo) y VESSL Cluster (optimización del uso de recursos de GPU en entornos de clúster). Tras esta ronda de financiación, el total recaudado por VESSL AI asciende a 16,8 millones de dólares, y la empresa cuenta con 35 empleados en Corea del Sur y San Mateo, Estados Unidos.

Puntos clave:

🌟 VESSL AI cierra una ronda de financiación Serie A de 12 millones de dólares, centrada en la optimización de los costes de las GPU para las empresas.

💼 Cuenta actualmente con 50 clientes empresariales, incluyendo empresas de renombre como Hyundai Motor y LIG Nex1.

🚀 La plataforma, mediante una estrategia multicanal, reduce los costes de las GPU hasta en un 80% y ofrece múltiples funciones principales.