Intel ha anunciado recientemente el lanzamiento de código abierto de AI Playground, un software diseñado para la generación de IA local, que proporciona a los usuarios de GPU Intel Arc una potente plataforma para ejecutar modelos de IA. Según AIbase, AI Playground admite varios modelos de generación de imágenes y vídeo, así como modelos de lenguaje grandes (LLM), y al optimizar los recursos de computación locales, reduce significativamente el umbral de hardware para las aplicaciones de IA. El proyecto, publicado en GitHub, ha atraído la atención de desarrolladores y entusiastas de la IA en todo el mundo, lo que marca una apuesta importante de Intel en el ecosistema de IA de código abierto.

Funciones principales: Soporte integral para modelos de IA multimodales

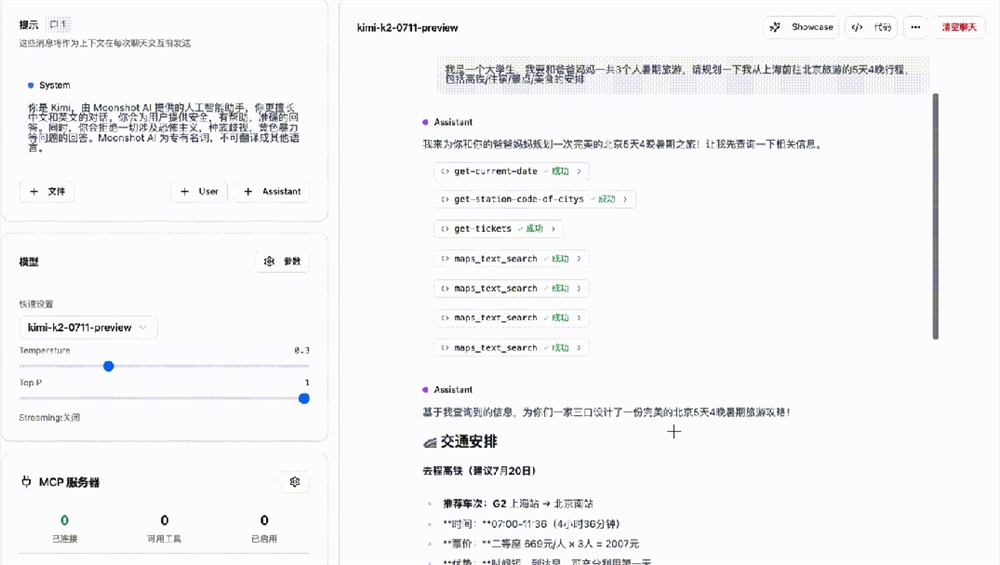

AI Playground, como un "centro de IA" fácil de usar, integra una amplia gama de funciones de IA generativa, que abarcan la generación de imágenes, el estilo de imágenes, la generación de texto y los chatbots. AIbase ha recopilado los modelos y funciones compatibles:

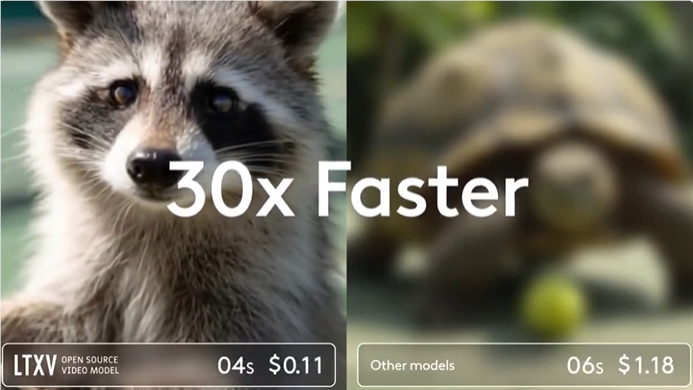

Generación de imágenes y vídeo: Admite los modelos Stable Diffusion 1.5, SDXL, Flux.1-Schnell y LTX-Video, lo que permite la generación de texto a imagen, el estilo de imagen y la generación de texto a vídeo, con resultados excelentes en resolución y detalle.

Modelos de lenguaje grandes: Es compatible con DeepSeek R1, Phi3, Qwen2, Mistral en formato Safetensor PyTorch, y Llama 3.1, Llama 3.2 en formato GGUF, junto con TinyLlama, Mistral 7B, Phi3mini y Phi3.5mini optimizados con OpenVINO, proporcionando una capacidad de chat e inferencia local eficiente.

Flujo de trabajo ComfyUI: Mediante la integración de ComfyUI, AI Playground admite flujos de trabajo avanzados de generación de imágenes, como Line to Photo HD y Face Swap, lo que aumenta la flexibilidad creativa.

AIbase observa que AI Playground no incluye modelos directamente; los usuarios deben descargar los modelos de Hugging Face o CivitAI y colocarlos en la carpeta especificada. La plataforma proporciona una interfaz de carga de modelos intuitiva para garantizar una operación sencilla.

Arquitectura técnica: Optimización del rendimiento local con OpenVINO

AI Playground se basa en el framework OpenVINO de Intel y está optimizado para GPU Arc y procesadores Core Ultra. AIbase analiza que sus tecnologías clave incluyen:

Aceleración OpenVINO: Proporciona un soporte de inferencia eficiente para el chat y la generación de imágenes, mejorando significativamente el rendimiento de los dispositivos con poca VRAM (como las GPU Arc de 8 GB).

Compatibilidad con Llama.cpp y GGUF: La extensión del backend experimental amplía la compatibilidad con los modelos GGUF, y la lista de modelos precargados simplifica la configuración del usuario.

Diseño modular: Mediante la función "Agregar modelo", los usuarios pueden introducir directamente el ID del modelo Hugging Face o la ruta local para cargar modelos personalizados de forma flexible.

En cuanto a los requisitos de hardware, AI Playground admite procesadores Intel Core Ultra-H/V o GPU de la serie Arc A/B (mínimo 8 GB de VRAM). Aunque se trata de una versión beta de código abierto, Intel proporciona una guía detallada de resolución de problemas para garantizar una rápida puesta en marcha. AIbase advierte que los dispositivos con poca VRAM pueden ser lentos al ejecutar modelos de alta resolución como SDXL; se recomienda utilizar modelos ligeros como Flux.1-Schnell.

Amplias aplicaciones: Potenciación de múltiples escenarios, desde la creación hasta la investigación

El lanzamiento de código abierto de AI Playground ofrece amplias perspectivas de aplicación en varios campos. AIbase resume sus principales escenarios:

Creación de contenido: Los creadores pueden utilizar Stable Diffusion y LTX-Video para generar imágenes y vídeos cortos de alta calidad, adecuados para redes sociales, publicidad y previsualización de películas.

Desarrollo de IA local: Los desarrolladores pueden basarse en el código abierto y optimizar la inferencia del modelo con OpenVINO para explorar soluciones de IA de bajo coste.

Educación e investigación: Admite modelos ligeros como Phi3mini, lo que reduce las necesidades de hardware y facilita la investigación académica y la enseñanza de IA.

Asistentes virtuales: Mediante modelos como DeepSeek R1 y Mistral 7B, se pueden construir chatbots locales para proteger la privacidad de los datos.

Los comentarios de la comunidad indican que la interfaz frontal Electron de AI Playground es intuitiva y fácil de usar, más adecuada para principiantes que AUTOMATIC1111 o ComfyUI, pero la profundidad de las funciones sigue siendo profesional. AIbase observa que su Arc A770 de 16 GB de VRAM ofrece un rendimiento excelente al ejecutar modelos grandes, con una mejor relación calidad-precio que las GPU NVIDIA similares.

Guía de inicio rápido: Instalación sencilla y despliegue rápido

AIbase informa de que AI Playground ofrece dos métodos de obtención: un paquete de instalación para escritorio Windows y el código fuente de GitHub. Los pasos de implementación son los siguientes:

Descargar el paquete de instalación adecuado para GPU Intel Arc o procesadores Core Ultra;

Obtener modelos de Hugging Face o CivitAI y colocarlos en la carpeta especificada;

Iniciar AI Playground y seleccionar el modelo y la tarea (como la generación de imágenes o el chat) a través de la interfaz.

Para garantizar el mejor rendimiento, se recomienda utilizar un dispositivo con 16 GB de VRAM Arc A770 o superior. La comunidad también proporciona una guía de verificación de licencias de modelos para evitar posibles riesgos legales. AIbase recomienda a los usuarios que realicen copias de seguridad periódicas del contenido generado para evitar la pérdida de datos debido a las actualizaciones de la versión beta.

Respuesta de la comunidad y perspectivas futuras

Tras el lanzamiento de código abierto de AI Playground, la comunidad ha elogiado su facilidad de uso y la optimización de la GPU Arc. Los desarrolladores aprecian especialmente la compatibilidad con el formato GGUF, considerando que su uso eficiente de la memoria y su compatibilidad multiplataforma establecen un estándar para la inferencia local de LLM. AIbase observa que la comunidad ya ha solicitado el desarrollo de una versión para Linux y espera que Intel publique más código abierto de la tecnología XeSS para mejorar la integridad del ecosistema. En el futuro, Intel planea añadir soporte para el procesador Core Ultra 200H y optimizar los flujos de trabajo de alta VRAM, ampliando la interfaz de usuario multilingüe (como el coreano) y las funciones RAG. AIbase cree que, gracias a la continua contribución de la comunidad de código abierto, AI Playground podría convertirse en la plataforma preferida para el desarrollo de IA local.

Dirección del proyecto: https://github.com/intel/AI-Playground