全新视觉提示方法 SoM 让 GPT-4V 看得更准、分的更细

站长之家

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

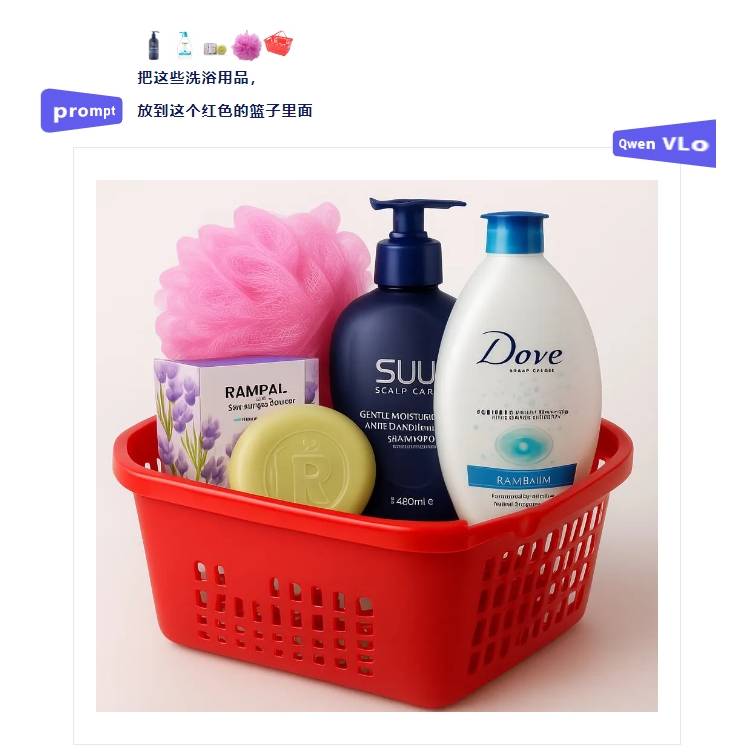

近日,Qwen VLo多模态大模型正式发布,该模型在图像内容理解与生成方面取得了显著进展,为用户带来了全新的视觉创作体验。 据介绍,Qwen VLo在继承原有Qwen-VL系列模型优势的基础上,进行了全面升级。该模型不仅能够精准“看懂”世界,更能基于理解进行高质量的再创造,真正实现了从感知到生成的跨越。用户现在可以在Qwen Chat(chat.qwen.ai)平台上直接体验这一新模型。

中国首个海洋领域的开源大模型 OceanGPT(沧渊)在浙江杭州正式发布。这一创新成果由浙江大学海洋精准感知技术全国重点实验室牵头研发,标志着中国在海洋科技领域迈出了重要一步。OceanGPT 具备基础的海洋专业知识问答能力,能够对声呐图像、海洋观测图等多模态数据进行自然语言解读。这一能力使得 OceanGPT 在处理复杂的海洋数据时,表现出色。该模型还采用了一种领域知识增强的 “慢思考” 推理机制,这意味着它能够有效降低生成错误信息的风险,解决了现有通用大模型常见的 “

欢迎来到AIbase【AI日报】栏目!每天三分钟了解当日AI大事件,助你洞悉AI行业趋势、创新AI产品应用。更多AI资讯访问:https://www.aibase.com/zh1、腾讯开源轻量级混元-A13B模型1张中低端GPU卡即可部署腾讯发布混元大模型家族的新成员混元-A13B模型,采用专家混合(MoE)架构,总参数规模达800亿,激活参数为130亿,大幅降低推理延迟与计算开销,为个人开发者和中小企业提供更具性价比的AI解决方案。该模型在数学、科学和逻辑推理任务中表现出色,支持调用工具生成复杂指令响应。体验入口:https:/

腾讯正式发布并开源混元大模型家族的新成员——混元-A13B模型。该模型采用基于专家混合(MoE)架构,总参数规模达800亿,激活参数为130亿,在保持顶尖开源模型效果的同时,大幅降低了推理延迟与计算开销,为个人开发者和中小企业提供了更具性价比的AI解决方案。

巨人网络旗下的社交推理游戏**《太空杀》近日上线了全新的AI原生玩法——“残局对决”。此次更新联合了阿里通义千问、腾讯混元、字节豆包这三大国产大模型,共同打造了游戏行业首个“多用户与AI智能体混合对抗”**的创新竞技机制。这不仅是《太空杀》AI原生玩法的重要升级,也标志着国产大模型在游戏场景落地应用的前沿探索。相较于传统的人机对抗和AI陪玩模式,“残局对决”在AI玩法创新上实现了显著突破。该玩法基于PvPvE(Player vs Player vs Environment)架构,构建了一个独特的

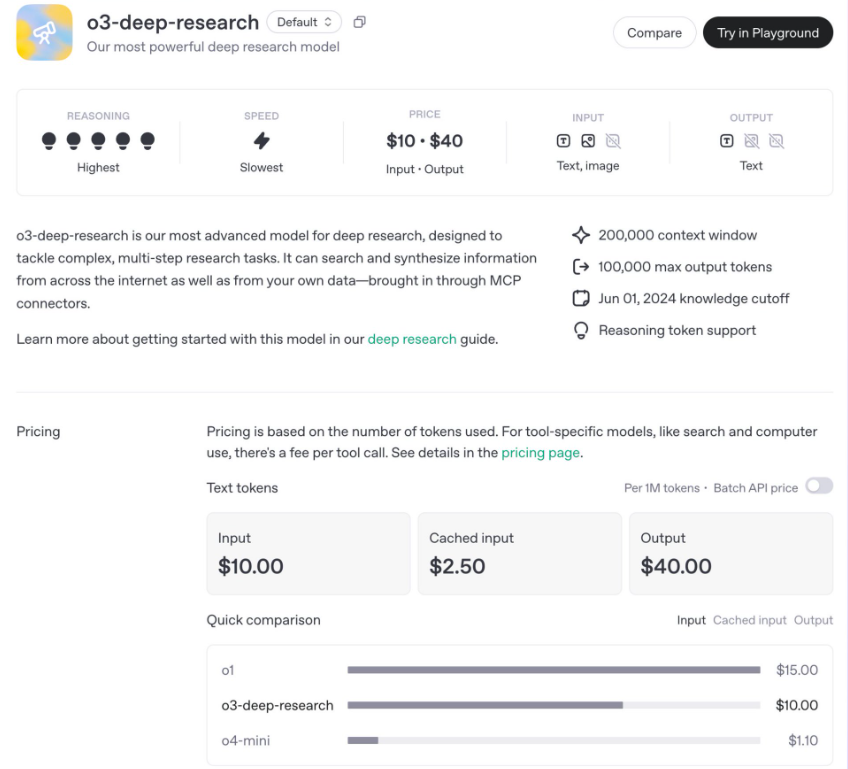

OpenAI于2025年6月26日宣布推出两款全新的 Deep Research API模型:o3-deep-research-2025-06-26和 o4-mini-deep-research-2025-06-26,标志着其在自动化研究与复杂任务处理领域的重大突破。这两款模型专为高阶分析和深度信息合成设计,支持开发者通过API实现自动化的网页搜索、数据分析、代码执行等功能,为企业、研究人员和开发者提供了强大的工具。o3与o4-mini:性能与效率的平衡o3-deep-research 是OpenAI目前最强大的深度研究模型,推论能力达到最高等级(5/5),专为需要复杂推理和精准分析的任务打造,例如金

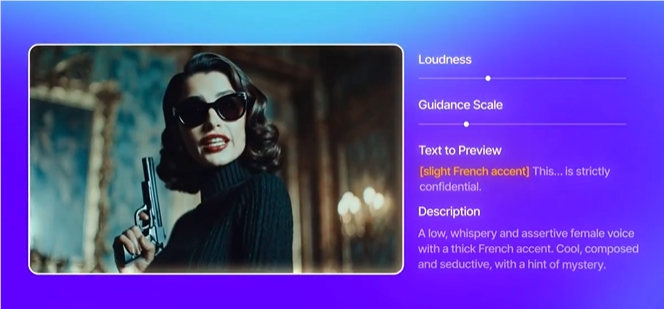

近日,AI语音技术领域的领军企业ElevenLabs正式发布其最新语音设计工具Voice Design v3,为内容创作者和开发者带来了前所未有的语音生成体验。据AIbase了解,这款工具通过简单的文本提示即可生成高度拟人化的语音,支持70多种语言和数百种本地化口音,极大地提升了语音的表达力和真实感。Voice Design v3的发布标志着AI语音技术在个性化和情感表达方面的重大突破。一键生成个性化语音,创意无限Voice Design v3的核心亮点在于其文本提示生成能力。用户只需输入一段描述性文字,例如“一个来自

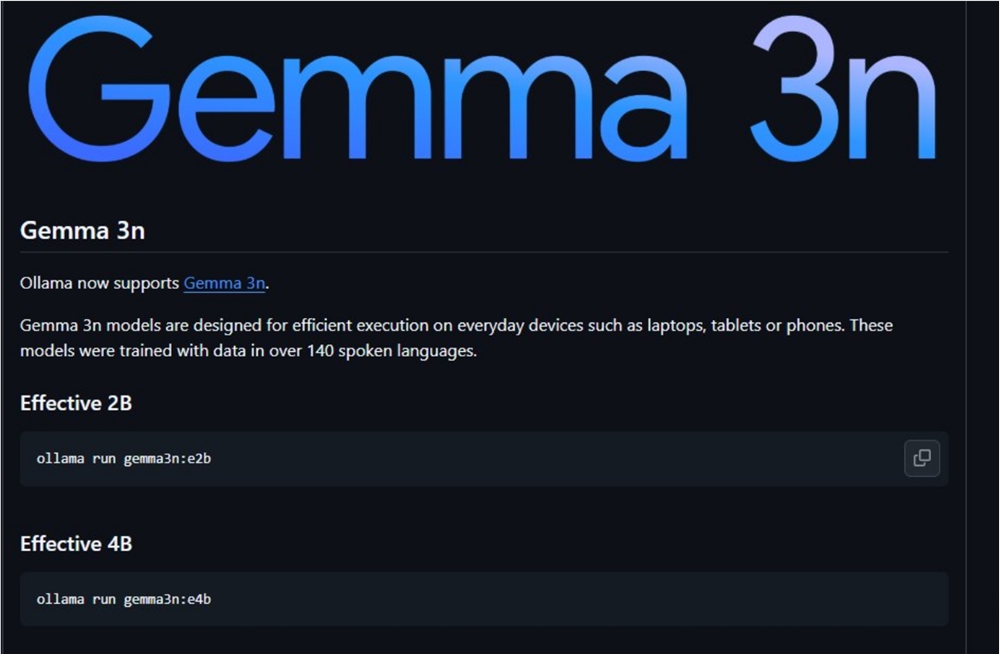

谷歌于本周五凌晨正式发布并开源全新端侧多模态大模型Gemma3n,这一突破性产品为手机、平板、笔记本等端侧设备带来了此前只能在云端体验的强大多模态功能。核心特性:小体积大能力Gemma3n提供E2B和E4B两个版本,虽然原始参数量分别为5B和8B,但通过架构创新,其内存占用仅相当于传统2B和4B模型,分别只需2GB和3GB内存即可运行。该模型原生支持图像、音频、视频和文本的多模态输入处理,支持140种文本语言和35种语言的多模态理解。值得一提的是,E4B版本在LMArena评测中得分超过1300,成为

Meta成功从OpenAI挖走三位顶级人工智能研究员:卢卡斯·贝耶尔(Lucas Beyer)、亚历山大·科列斯尼科夫(Alexander Kolesnikov)和翟晓华,引发业界广泛关注。这三位研究员在机器学习和计算机视觉领域享有盛誉,以开发可扩展图像模型和视觉转换器(ViT)架构的突破性工作而闻名。值得注意的是,他们此前曾在Google DeepMind工作,并于2024年底刚刚参与在苏黎世开设OpenAI办事处。针对外界关于天价签约费的传闻,贝耶尔在X平台上亲自澄清,否认了获得1亿美元签约奖金的说法。这一数字此前由OpenAI首席

![Black Forest震撼开源FLUX.1 Kontext [dev]:媲美GPT-4o的图像编辑](https://upload.chinaz.com/2025/0627/6388661124441853705469566.png)

Black Forest Labs正式宣布,其全新图像编辑模型 FLUX.1Kontext [dev] 现已开源,引发了AI社区的广泛关注。这一模型作为FLUX.1系列的最新成员,以其强大的图像编辑能力和高效性能被誉为可媲美GPT-4o的开源替代方案。FLUX.1Kontext [dev] 基于12亿参数的流匹配变换器架构,专为图像编辑任务设计,支持消费级硬件运行,为创作者、开发者和研究人员提供了前所未有的灵活性。核心功能:上下文感知与精准编辑FLUX.1Kontext [dev] 的最大亮点在于其 上下文感知图像生成与编辑能力。与传统仅基于文本提示的图像