Aujourd'hui, l'équipe de Doubao Large Model a officiellement publié un rapport technique sur la génération d'images à partir de texte, dévoilant pour la première fois les détails techniques du modèle de génération d'images Seedream 2.0. Ce rapport couvre la construction des données, le cadre de pré-entraînement, et le processus complet de RLHF post-entraînement, constituant une véritable avancée majeure dans le domaine de la génération d'images à partir de texte.

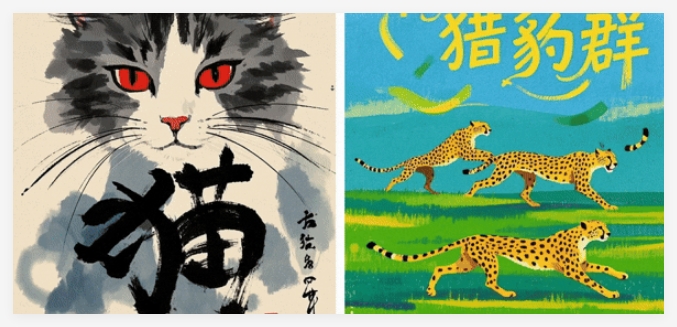

Depuis son lancement début décembre 2024 sur les applications Doubao et Jimeng, Seedream 2.0 a déjà servi des dizaines de millions d'utilisateurs finaux et est très apprécié des designers professionnels. Comparé à des modèles dominants tels qu'Ideogram 2.0 et Midjourney V6.1, il résout les problèmes de rendu textuel médiocre et de compréhension insuffisante de la culture chinoise, affichant une amélioration significative en termes de compréhension bilingue (chinois et anglais), d'esthétique et d'obéissance aux instructions.

Selon les tests de référence Bench-240, la cohérence structurelle et la précision de la compréhension du texte généré à partir d'invites en anglais sont supérieures. Pour le chinois, le taux d'utilisation des caractères générés et rendus atteint 78 %, et le taux de réponse parfait est de 63 %, dépassant largement les autres modèles du marché.

Sur le plan technique, l'équipe a apporté de nombreuses innovations. Au niveau du prétraitement des données, un cadre basé sur la « fusion des connaissances » a été mis en place. Une architecture de données quadridimensionnelle équilibre la qualité des données et la diversité des connaissances. Un moteur d'annotation intelligente permet une évolution cognitive à trois niveaux, améliorant la capacité de compréhension et d'identification du modèle, tandis que la refonte de l'ingénierie améliore considérablement l'efficacité du traitement des données.

Au stade du pré-entraînement, l'équipe s'est concentrée sur la compréhension bilingue et le rendu textuel. Une approche d'alignement bilingue natif, par l'ajustement fin du LLM et la création d'ensembles de données dédiés, permet de franchir la barrière entre le langage et la vision. Un système de fusion d'encodage multimodal permet au modèle de prendre en compte à la fois la sémantique du texte et la typographie. L'architecture DiT a été améliorée à trois niveaux, avec l'introduction des techniques QK-Norm et Scaling ROPE, améliorant ainsi la stabilité de l'entraînement et permettant la génération d'images multi-résolutions.

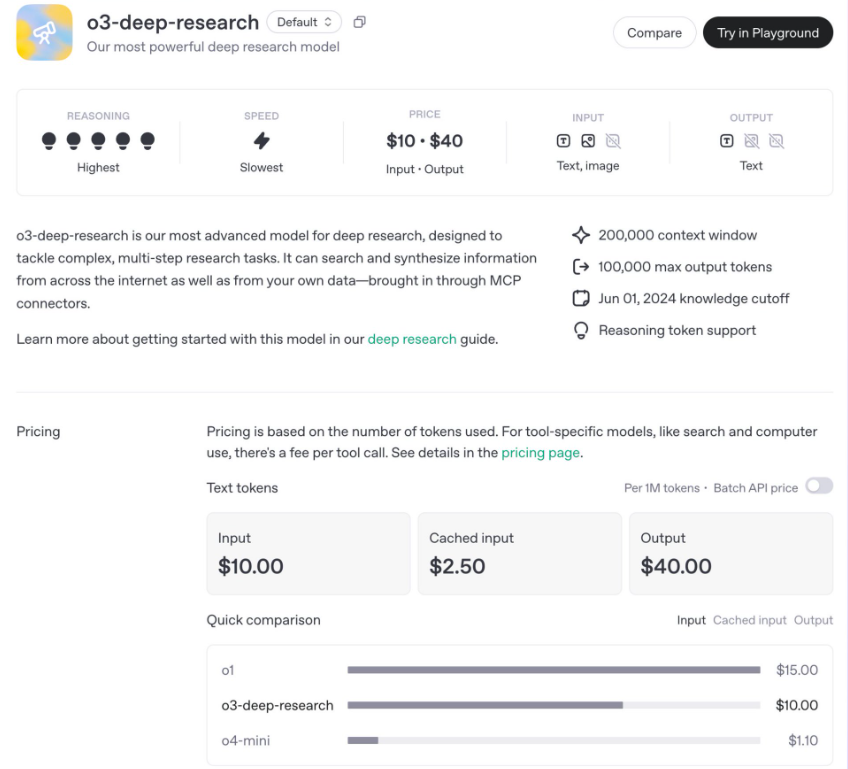

Note : Performances de Seedream 2.0 sur différentes dimensions pour les invites en anglais. Les données de chaque dimension sont normalisées par rapport au meilleur indicateur.

Lors du processus RLHF post-entraînement, l'équipe a développé et optimisé un système axé sur trois aspects : un système de données de préférences multidimensionnelles, trois modèles de récompense différents, et un apprentissage itératif pour faire évoluer le modèle. Ceci permet d'améliorer efficacement les performances du modèle, les scores des différents modèles de récompense augmentant progressivement au cours des itérations.

Note : Performances de Seedream 2.0 sur différentes dimensions pour les invites en chinois. Les données de chaque dimension sont normalisées par rapport au meilleur indicateur.

La publication de ce rapport technique témoigne de la détermination de l'équipe Doubao Large Model à faire progresser la technologie de génération d'images. À l'avenir, l'équipe continuera d'explorer des technologies innovantes, d'améliorer les performances du modèle, d'approfondir la recherche sur les mécanismes d'optimisation de l'apprentissage par renforcement, et de partager continuellement son expérience technique pour contribuer à l'essor du secteur.

Page de démonstration technique : https://team.doubao.com/tech/seedream

Rapport technique : https://arxiv.org/pdf/2503.07703

![Flux.1 Kontext [dev] de Black Forest : un modèle d'édition d'images open source qui rivalise avec GPT-4o](https://upload.chinaz.com/2025/0627/6388661124441853705469566.png)