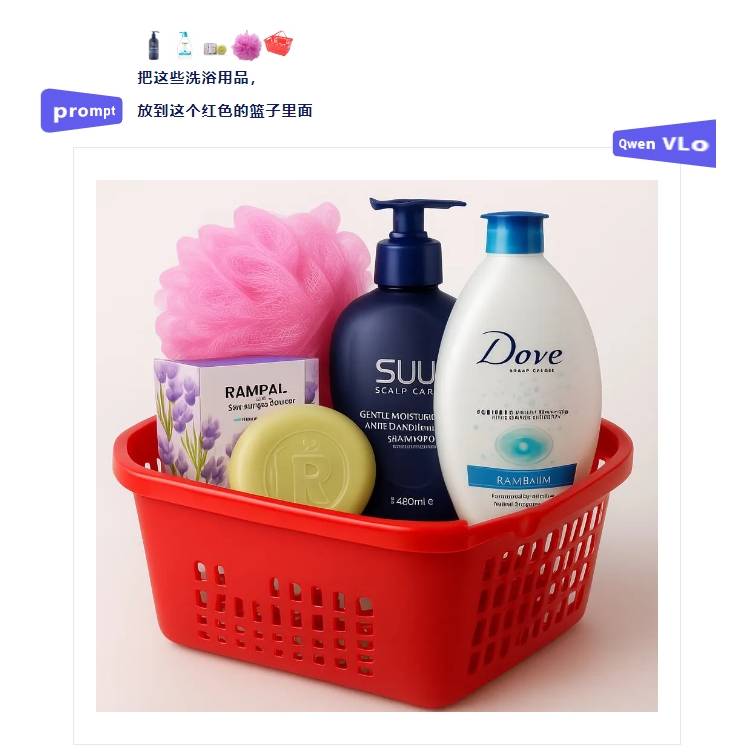

Récemment, VectorSpaceLab a officiellement rendu open source le modèle multimodal universel OmniGen2 sur la plateforme Hugging Face. Grâce à une architecture innovante en deux composants et à une puissante capacité de traitement visuel, ce modèle offre aux chercheurs et développeurs un outil fondamental efficace pour l'intelligence artificielle générative contrôlable. Ce modèle est constitué d'un modèle linguistique visuel (VLM) Qwen-VL-2.5 avec 3 milliards de paramètres et d'un modèle de diffusion avec 4 milliards de paramètres. En freezeant le VLM pour analyser les signaux visuels et les instructions des utilisateurs, il combine le modèle de diffusion pour générer des images de haute qualité. Il présente des performances avancées dans quatre scénarios centraux : l'analyse visuelle, la génération d'images à partir de textes, l'édition d'images guidée par des instructions et la génération de contexte.

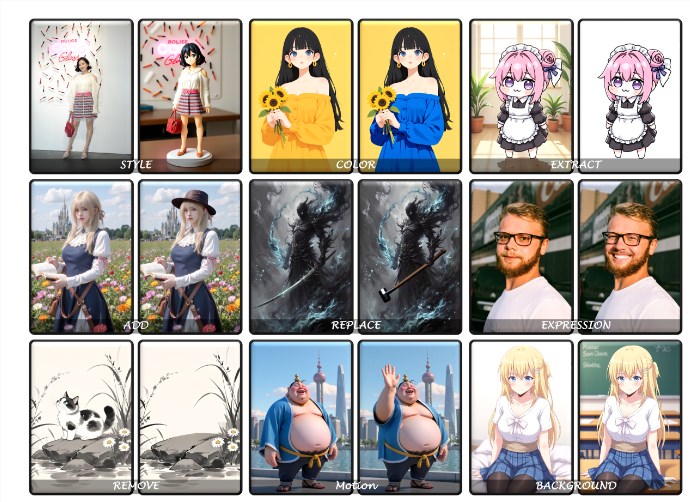

En tant que projet open source, les capacités d'analyse visuelle d'OmniGen2 s'appuient sur la base solide de Qwen-VL-2.5, permettant une interprétation précise du contenu des images ; sa fonction de génération d'images à partir de textes soutient la création d'images de haute fidélité respectant les normes esthétiques ; dans le domaine de l'édition d'images guidée par des instructions, le modèle réalise des tâches complexes avec une grande précision, atteignant un niveau avancé parmi les modèles open source ; quant à ses capacités de génération de contexte, elles peuvent gérer de manière flexible des entrées diverses telles que des personnages, des objets ou des scènes, produisant ainsi des sorties visuelles cohérentes et nouvelles.

Par exemple, les utilisateurs peuvent non seulement faire changer le style d'une scène animée de pandas tenant un verre de thé grâce à des instructions en langage naturel, mais aussi ajouter un arrière-plan dynamique à un personnage de fée fantastique, voire corriger des détails tels que le nombre d'objets ou les conflits de couleur dans une image.

Aujourd'hui, les poids du modèle OmniGen2 sont disponibles pour téléchargement, et des démonstrations en ligne via Gradio et Jupyter sont fournies, permettant aux utilisateurs d'améliorer les résultats de génération en ajustant des hyperparamètres tels que le nombre d'étapes d'échantillonnage, l'intensité de la guidance textuelle ou le poids des images de référence. L'équipe du projet prévoit de rendre open source ultérieurement le code d'entraînement, les jeux de données et le processus de construction, ainsi que de lancer un benchmark de génération de contexte appelé OmniContext, afin d'améliorer davantage l'optimisation de la charge CPU et l'intégration de plusieurs cadres. Avec l'expansion continue des applications de l'intelligence artificielle multimodale, OmniGen2, grâce à son efficacité et à sa complétude fonctionnelle, ouvre de nouvelles voies technologiques pour la création visuelle personnalisée et l'assistance au design intelligent.