Apenas seis meses después del lanzamiento de las GB200 y B200, Nvidia presenta su nueva GPU: las GB300 y B300. Aunque parezca una simple actualización, en realidad implica un cambio significativo, especialmente en el rendimiento de los modelos de inferencia, lo que tendrá un profundo impacto en toda la industria.

B300/GB300: Un salto cuántico en el rendimiento de inferencia

La GPU B300 utiliza el nodo de proceso de 4 nm de TSMC, optimizado para chips de computación. Esto permite a la B300 alcanzar un rendimiento FLOPS un 50% superior al de la B200. Parte de esta mejora se debe al aumento del TDP, alcanzando 1,4 kW en la GB300 y 1,2 kW en la B300 HGX (frente a 1,2 kW y 1 kW de las GB200 y B200 respectivamente). El resto de la mejora proviene de las mejoras de arquitectura y la optimización a nivel de sistema, como la distribución dinámica de energía entre la CPU y la GPU.

Además de la mejora de FLOPS, la memoria se ha actualizado a 12-Hi HBM3E, aumentando la capacidad de HBM de cada GPU a 288 GB. Sin embargo, la velocidad de los pines permanece sin cambios, por lo que el ancho de banda de memoria de cada GPU sigue siendo de 8 TB/s. Cabe destacar que Samsung no ha formado parte de la cadena de suministro de las GB200 ni de las GB300.

Asimismo, Nvidia ha ajustado los precios. Esto afectará en cierta medida al margen de beneficio de los productos Blackwell, pero lo más importante es que la mejora de rendimiento de las B300/GB300 se notará principalmente en los modelos de inferencia.

Diseñadas a medida para modelos de inferencia

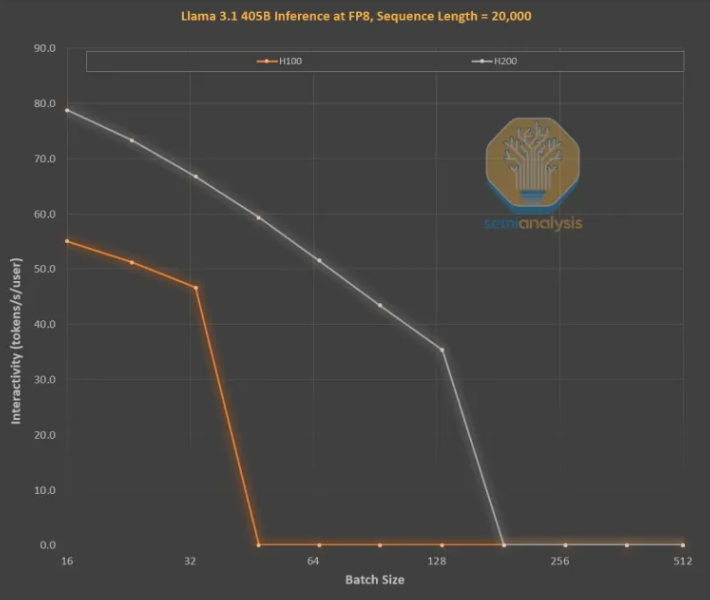

La mejora de la memoria es crucial para el entrenamiento de inferencia LLM al estilo OpenAI O3, ya que las secuencias largas aumentan la KVCache, lo que limita el tamaño de lote crítico y el retardo. La actualización de H100 a H200 (principalmente el aumento de memoria) ha supuesto dos mejoras:

El mayor ancho de banda de memoria (4,8 TB/s en H200 frente a 3,35 TB/s en H100) ha mejorado la interactividad en todos los tamaños de lote comparables en un 43%.

Al utilizar un tamaño de lote mayor en H200 que en H100, el número de tokens generados por segundo ha aumentado tres veces, reduciendo el coste aproximadamente en la misma proporción. Esta diferencia se debe principalmente a que la KVCache limita el tamaño total del lote.

El aumento de la capacidad de memoria ha supuesto una mejora de rendimiento enorme. La diferencia de rendimiento y económica entre ambas GPU es mucho mayor de lo que indican sus especificaciones:

La experiencia del usuario con los modelos de inferencia puede ser deficiente debido al tiempo de espera entre la solicitud y la respuesta. Acelerar significativamente el tiempo de inferencia mejoraría la disposición del usuario a utilizarlos y a pagar por ellos.

La mejora de rendimiento tres veces mayor gracias a la actualización de la memoria intermedia es asombrosa, superando con creces la Ley de Moore, la Ley de Huang o cualquier otra mejora de hardware que hayamos visto.

Los modelos más potentes pueden cobrar un precio mucho mayor que los modelos con un rendimiento ligeramente inferior. Los modelos de vanguardia tienen un margen de beneficio superior al 70%, mientras que los modelos obsoletos de la competencia de código abierto tienen un margen de beneficio inferior al 20%. Los modelos de inferencia no tienen por qué realizar un solo razonamiento en cadena. La función de búsqueda puede ampliarse para mejorar el rendimiento, como se ha hecho en O1Pro y O3. Esto permite que los modelos más inteligentes resuelvan más problemas y generen más ingresos por cada GPU.

Por supuesto, Nvidia no es la única empresa que puede aumentar la capacidad de memoria. Los ASIC también pueden hacerlo y, de hecho, AMD podría estar en una posición más ventajosa, ya que la capacidad de memoria de sus MI300X, MI325X y MI350X suele ser mayor que la de Nvidia (192 GB, 256 GB y 288 GB respectivamente), pero Nvidia cuenta con un arma secreta llamada NVLink.

La importancia de NVL72 radica en que permite que 72 GPU trabajen juntas en el mismo problema, compartiendo memoria con una latencia mínima. Ningún otro acelerador del mundo tiene capacidad de intercambio totalmente interconectado.

Las GB200NVL72 y GB300NVL72 de Nvidia son cruciales para lograr varias funciones clave:

Mayor interactividad, lo que reduce la latencia de cada cadena de razonamiento.

72 GPU pueden distribuir la KVCache, permitiendo cadenas de razonamiento más largas (mayor inteligencia).

Escalabilidad del tamaño de lote mucho mejor que en los servidores típicos de 8 GPU, lo que reduce los costes.

Mayor cantidad de muestras que trabajan en el mismo problema para mejorar la precisión y el rendimiento del modelo.

Por lo tanto, la tokenómica de NVL72 se ha multiplicado por más de 10, especialmente en cadenas de inferencia largas. La ocupación de memoria de KVCache es letal para la rentabilidad, pero NVL72 es la única forma de ampliar la longitud de la inferencia a más de 100.000 tokens.

GB300: Reestructuración de la cadena de suministro

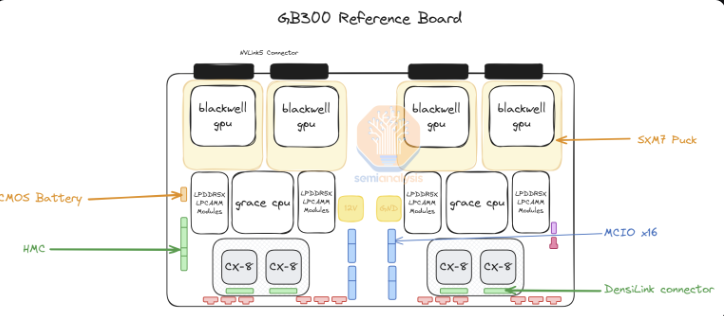

Para la GB300, Nvidia ha realizado cambios importantes en la cadena de suministro y el contenido. Para la GB200, Nvidia proporcionaba toda la placa Bianca (incluida la GPU Blackwell, la CPU Grace, 512 GB de LPDDR5X, contenido VRM), así como la bandeja de intercambio y la placa posterior de cobre.

Para la GB300, Nvidia solo proporciona el módulo B300 en "SXM Puck", la CPU Grace en encapsulado BGA y el HMC, que procederá de la empresa emergente estadounidense Axiado, en lugar de Aspeed en la GB200. Los clientes finales ahora adquirirán directamente los componentes restantes de la placa de computación, y la memoria de segundo nivel utilizará módulos LPCAMM en lugar de LPDDR5X soldada. Micron será el principal proveedor de estos módulos. La bandeja de intercambio y la placa posterior de cobre permanecen sin cambios, siendo suministrados completamente por Nvidia.

El cambio a SXM Puck ofrece oportunidades para que más OEM y ODM participen en la placa de computación. Antes, solo Wistron y Foxconn podían fabricar placas de computación Bianca, mientras que ahora pueden participar más OEM y ODM. Wistron es el mayor perdedor en forma de ODM, ya que ha perdido cuota de mercado en las placas Bianca. Para Foxconn, la pérdida de cuota de mercado en las placas Bianca se ve compensada por el hecho de ser el fabricante exclusivo de los SXM Puck y sus zócalos. Nvidia está intentando introducir otros proveedores para los Puck y los zócalos, pero aún no se han realizado más pedidos.

Otro cambio importante es el contenido VRM. Aunque hay algo de contenido VRM en el SXM Puck, la mayor parte del contenido VRM integrado será adquirido directamente por las empresas/OEM de hiperescala a los proveedores de VRM. Debido al cambio de modelo de negocio, Monolithic Power Systems perderá cuota de mercado.

Nvidia también ofrece la tarjeta de interfaz de red ConnectX-8 de 800 G en la plataforma GB300, que ofrece el doble de ancho de banda de expansión en InfiniBand y Ethernet. Nvidia había cancelado previamente la ConnectX-8 para la GB200 debido a la complejidad del tiempo de comercialización y a la omisión de la habilitación de PCIe Gen6 en la placa Bianca.

La ConnectX-8 supone una gran mejora con respecto a la ConnectX-7. No solo tiene el doble de ancho de banda, sino que también cuenta con 48 canales PCIe en lugar de 32, lo que permite arquitecturas únicas, como la MGX B300A refrigerada por aire. Además, la ConnectX-8 tiene capacidad SpectrumX, mientras que en los productos anteriores de 400 G, SpectrumX requería una UCP Bluefield3D menos eficiente.

Impacto de la GB300 en las empresas de hiperescala

La influencia de la latencia de las GB200 y GB300 en las empresas de hiperescala significa que muchos pedidos a partir del tercer trimestre se trasladarán a las nuevas GPU de Nvidia, más caras. Hasta la semana pasada, todas las empresas de hiperescala habían decidido optar por la GB300. Esto se debe en parte al mayor rendimiento de la GB300, pero también a que pueden controlar su propio destino.

Debido a los desafíos en el tiempo de comercialización y a los importantes cambios en el bastidor, la refrigeración y la fuente de alimentación/densidad, las empresas de hiperescala no permitieron demasiados cambios en la GB200 a nivel de servidor. Esto llevó a Meta a abandonar la esperanza de obtener NIC de múltiples fuentes de Broadcom y Nvidia, pasando a depender totalmente de Nvidia. En otros casos, como Google, abandonaron las NIC internas, pasando a utilizar únicamente las de Nvidia.

Para las organizaciones de miles de personas en empresas de hiperescala acostumbradas a optimizar todos los costes, desde la CPU hasta la red, pasando por los tornillos y las placas metálicas, esto es simplemente increíble.

El ejemplo más sorprendente es Amazon, que eligió una configuración muy poco ideal, con un coste total de propiedad (TCO) peor que el diseño de referencia. Amazon, debido al uso de conmutadores PCIe y NIC de adaptadores de fibra óptica elástica de 200 G menos eficientes, necesita refrigeración por aire, por lo que no puede implementar bastidores NVL72 como Meta, Google, Microsoft, Oracle, X.AI y Coreweave. Debido a sus NIC internas, Amazon tuvo que utilizar NVL36, lo que también aumentó el coste por GPU debido al mayor contenido de la placa posterior y el conmutador. En resumen, la configuración de Amazon no es ideal debido a sus limitaciones en torno a la personalización.

Con la GB300, las empresas de hiperescala pueden personalizar más componentes, como la placa base y la refrigeración. Esto permite a Amazon construir su propia placa base personalizada, refrigerada por agua e integrando componentes que antes se refrigeraban por aire, como el conmutador PCIe de Astera Labs. Con más componentes refrigerados por agua y la HVM finalmente alcanzada en la NIC K2V6400G en el tercer trimestre de 2025, esto significa que Amazon puede volver a la arquitectura NVL72 y mejorar considerablemente su TCO.

Aunque las empresas de hiperescala deben diseñar, verificar y confirmar más contenido, este es el mayor inconveniente. Esto podría convertirse fácilmente en la plataforma más compleja que las empresas de hiperescala hayan tenido que diseñar jamás (excluyendo el sistema TPU de Google). Algunas empresas de hiperescala podrán diseñar rápidamente, pero otras con equipos más lentos se quedarán atrás. A pesar de los informes de mercado sobre cancelaciones, creemos que Microsoft es una de las empresas más lentas en implementar la GB300 debido a su lentitud en el diseño, y todavía están comprando algunas GB200 en el cuarto trimestre.

La diferencia en el precio total que pagan los clientes es significativa, ya que los componentes se extraen de la pila de beneficios de Nvidia y se transfieren a los ODM. Los ingresos de los ODM se ven afectados y, lo que es más importante, el margen de beneficio de Nvidia también cambiará a lo largo del año.