ロボットの分野では、人工知能が本格的に「三次元世界を理解する」ことは長年困難な課題でした。従来の視覚言語モデル(VLA)は主に二次元画像とテキストデータで訓練されており、現実環境の三次元空間を理解することが難しかったです。しかし、上海交通大学とケンブリッジ大学の研究チームは、Evo-0という新しい強化視覚言語行動モデルを提案しました。このモデルは軽量な方法で三次元幾何学の事前知識を組み込み、ロボットの複雑なタスクにおける空間理解能力を大幅に向上させました。

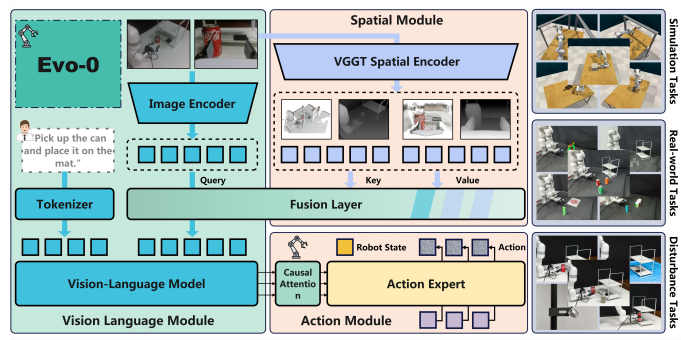

Evo-0モデルの革新点は、視覚幾何学ベースモデル(VGGT)を活用し、多角的なRGB画像から三次元構造情報を抽出し、それらを既存の視覚言語モデルと統合することです。この方法により、追加のセンサーまたは明示的な深度入力を必要とせず、空間認識能力が顕著に向上しました。RLBenchシミュレーション実験において、Evo-0は5つの精密操作が必要なタスクで、ベースラインモデルpi0より15%高い成功率を達成し、オープンVLA(openvla-oft)では31%の改善を記録しました。

具体的には、Evo-0はVGGTを空間エンコーダーとして利用し、VGGTから抽出されたt3^Dトークンを導入しています。これらのトークンには、深さの文脈や空間関係などの幾何情報が含まれています。クロスアテンション融合モジュールを通じて、モデルは抽出された二次元視覚トークンと三次元トークンを効果的に統合し、空間配置や物体間の関係の理解能力を高めます。この方法はトレーニング効率を保ちつつ、柔軟性と展開の利便性も向上させました。

現実世界での実験では、Evo-0は目標物の中央への配置、差し込み、密接な掴みなど複雑な空間タスクにおいて優れた性能を発揮し、ベースラインモデルを上回りました。平均的な成功確率は28.88%向上しました。特に、複雑な空間関係の理解と操作能力において、Evo-0は顕著な優位性を示しました。

以上のように、Evo-0は巧みな空間情報の統合によって、将来的な汎用ロボット戦略に対して新たな実行可能な道を示しました。この研究成果は学術界で広範な注目を集め、ロボット分野における実際的な応用にも新たな可能性をもたらしました。