A equipe de processamento de linguagem natural da Alibaba anunciou o WebWatcher, um agente inteligente de pesquisa profunda multimodal de código aberto, projetado para superar as limitações dos sistemas fechados atuais e dos agentes de código aberto na área de pesquisa multimodal profunda. O WebWatcher, ao integrar várias ferramentas, como navegação na web, busca de imagens, interpretador de código e OCR interno, é capaz de lidar com tarefas complexas multimodais como um pesquisador humano, demonstrando capacidades fortes de compreensão visual, raciocínio lógico, recuperação de conhecimento, agendamento de ferramentas e validação autônoma.

O time de desenvolvimento do WebWatcher observa que, embora os sistemas fechados existentes, como o DeepResearch da OpenAI, tenham se destacado na pesquisa textual profunda, eles geralmente são limitados a ambientes de texto puro e têm dificuldade em lidar com imagens, gráficos e conteúdo misto no mundo real. Além disso, os agentes de código aberto enfrentam dois principais gargalos: alguns focam apenas em agentes de recuperação de texto, que podem integrar informações, mas não conseguem lidar com imagens; outros são agentes visuais, que conseguem identificar imagens, mas carecem de raciocínio multimostral e capacidade de colaboração entre ferramentas. O WebWatcher foi justamente projetado para resolver esses gargalos.

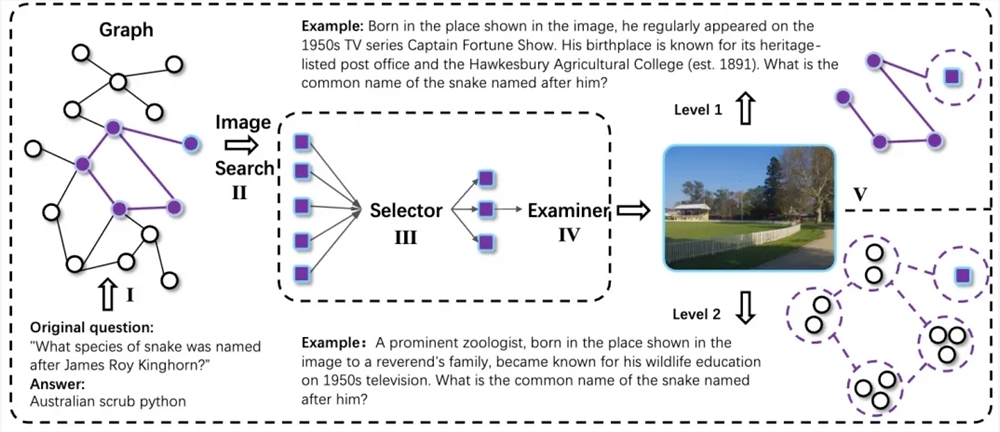

A solução técnica do WebWatcher abrange toda a cadeia, desde a construção de dados até a otimização do treinamento, com o objetivo principal de permitir que agentes multimodais tenham capacidade de raciocínio flexível e colaboração entre ferramentas em tarefas de pesquisa multimodal de alto nível. Para isso, a equipe de pesquisa desenvolveu um processo automático de geração de dados multimodais, coletando cadeias de conhecimento multimostral por meio de caminhadas aleatórias e introduzindo tecnologia de difusão de informações para aumentar a incerteza e complexidade das tarefas. Todos os exemplos de problemas complexos são expandidos para versões multimodais pelo módulo QA-to-VQA, reforçando ainda mais a capacidade do modelo de compreensão multimostral.

No que diz respeito à construção de trajetórias de raciocínio de alta qualidade e pós-treinamento, o WebWatcher utiliza um método de geração de trajetórias baseado em Action-Observation, coletando trajetórias reais de interação com múltiplas ferramentas e realizando ajuste fino supervisionado (SFT), permitindo que o modelo aprenda rapidamente os padrões básicos de raciocínio ReAct multimodal e uso de ferramentas no início do treinamento. Em seguida, o modelo entra na fase de aprendizado por reforço, melhorando ainda mais a capacidade de decisão do agente multimodal em ambientes complexos por meio do GRPO.

Para validar plenamente as capacidades do WebWatcher, a equipe de pesquisa propôs o BrowseComp-VL, uma versão estendida do BrowseComp para tarefas visual-linguísticas, visando aproximar-se da dificuldade das tarefas de pesquisa multimostral de especialistas humanos. Em avaliações rigorosas em múltiplas rodadas, o WebWatcher liderou amplamente os modelos multimodais de código aberto e fechado atuais em tarefas como raciocínio complexo, recuperação de informações, integração de conhecimento e otimização de informações agregadas.

Especificamente, no benchmark HLE-VL (Humanity’s Last Exam), um benchmark de raciocínio complexo em etapas, o WebWatcher obteve 13,6% de pontuação Pass@1, liderando significativamente os modelos representativos como GPT-4o (9,8%), Gemini2.5-flash (9,2%) e Qwen2.5-VL-72B (8,6%). Na avaliação MMSearch, que é mais próxima da pesquisa multimodal real, o WebWatcher obteve uma pontuação Pass@1 de 55,3%, superando significativamente o Gemini2.5-flash (43,9%) e o GPT-4o (24,1%). Na avaliação LiveVQA, o WebWatcher obteve uma pontuação Pass@1 de 58,7%, superando outros modelos principais. No benchmark mais desafiador, BrowseComp-VL, o WebWatcher liderou com uma média de 27,0% (Pass@1), obtendo resultados mais do que o dobro dos anteriores.

Endereço do repositório: https://github.com/Alibaba-NLP/WebAgent