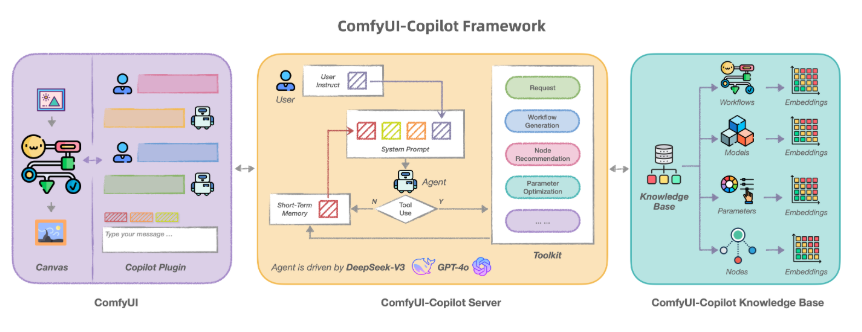

Das Alibaba Mama Kreativteam hat kürzlich ein KI-Bildreparaturmodell namens FLUX-Controlnet-Inpainting als Open Source veröffentlicht. Das Modell basiert auf der FLUX.1-dev-Modellarchitektur und wurde mit 12 Millionen Bildern aus dem laion2B-Datensatz und internen Alibaba-Datensätzen trainiert. Es erreicht eine hohe Auflösung von 768x768 und ermöglicht eine qualitativ hochwertige Bildreparatur.

Dieses Tool erbt nicht nur die Fähigkeit zur hochwertigen Bilderzeugung des FLUX.1-dev-Modells, sondern integriert auch geschickt die Vorteile von ControlNet. Es kann Bilder anhand von Informationen wie Kanten, Skizzen und Tiefenkarten präzise reparieren und in bestimmten Bereichen Inhalte generieren, die harmonisch mit der Umgebung übereinstimmen. So werden beschädigte oder fehlende Bildteile wiederhergestellt.

Ein besonderes Highlight des Modells ist seine Fähigkeit, sprachliche Beschreibungen des Benutzers zu verstehen und die Bildreparatur entsprechend anzupassen. Beispielsweise können Objekte hinzugefügt oder entfernt oder der Stil des Bildes verändert werden, basierend auf der Beschreibung des Benutzers.

Das FLUX-Controlnet-Inpainting-Modell ist jetzt auf der Hugging Face-Plattform als Open Source verfügbar. Es gibt detaillierte Anleitungen und Beispielcodes. Benutzer können die diffusers-Bibliothek über pip installieren und den Projektcode von GitHub klonen, um die leistungsstarken Funktionen des Modells schnell zu testen.

Das Alibaba Mama Kreativteam gibt an, dass sich das aktuell veröffentlichte FLUX-Controlnet-Inpainting-Modell noch in der Alpha-Testphase befindet. Die Modellleistung wird weiterhin optimiert und zukünftige Updates sind geplant.

Projekt-Adresse: https://github.com/alimama-creative/FLUX-Controlnet-Inpainting

Workflow-Download-Adresse: https://huggingface.co/alimama-creative/FLUX.1-dev-Controlnet-Inpainting-Alpha/resolve/main/images/alimama-flux-controlnet-inpaint.json

![Black Forest begeistert mit Open-Source-FLUX.1 Kontext [dev]: Bildbearbeitung im Gleichschritt mit GPT-4o](https://upload.chinaz.com/2025/0627/6388661124441853705469566.png)

![Der Open-Source-Genie ist da! FLUX.1 Kontext [dev] herausfordert GPT-4o und bringt das Bildbearbeitung ins neue Zeitalter](https://upload.chinaz.com/2025/0627/6388661110722937329608910.png)