Kürzlich hat Quwan Technology ein neues Sprachsynthesemodell (TTS) namens MaskGCT veröffentlicht. Dieses Modell erzielt bemerkenswerte Fortschritte in Bezug auf Sprachqualität, Ähnlichkeit und Steuerbarkeit und revolutioniert die traditionelle Sprachsynthese (TTS). Es befreit KI endgültig von der Abhängigkeit von manuellen Annotationen und ermöglicht ein echtes „Selbstlernen“.

Traditionelle TTS-Systeme sind wie verwöhnte Kinder: Man muss ihnen jedes Wort einzeln beibringen. Zuerst werden Text und Sprache ausgerichtet, dann die Dauer jedes Silben vorhergesagt, bevor die Sprache stockend synthetisiert werden kann. Dieses Verfahren ist nicht nur ineffizient, sondern die erzeugte Sprache fehlt auch an natürlichem und flüssigem Rhythmus.

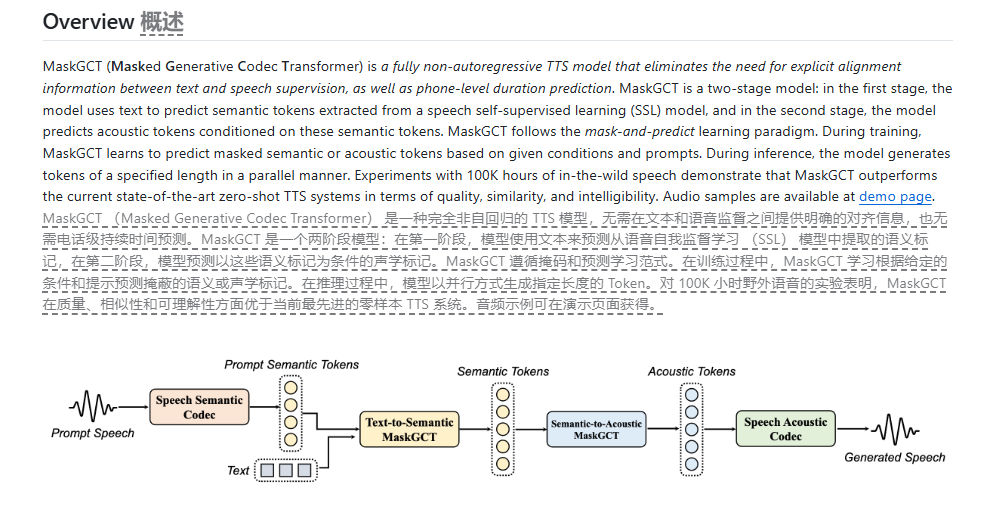

MaskGCT von Quwan Technology hingegen verlässt dieses veraltete Modell vollständig. Es verwendet eine Architektur aus maskierten generativen Encoder-Decoder-Transformatoren. Vereinfacht gesagt, wird die Sprache zuerst mit einem BERT-ähnlichen Modell in semantische Merkmale umgewandelt. Ein weiteres Modell prognostiziert dann anhand dieser semantischen Merkmale akustische Merkmale, um schließlich die Sprache zu synthetisieren.

Der größte Vorteil dieses Verfahrens ist, dass es keine manuellen Annotationen benötigt. Es trainiert direkt mit 100.000 Stunden unannotierter Sprachdaten, sodass das Modell die Beziehung zwischen Text und Sprache selbst aus riesigen Datenmengen lernt.

Man könnte es mit einem Kind vergleichen, das in eine sprachliche Umgebung geworfen wird und die Sprache durch eigenes Erkunden lernt.

Ein weiterer bemerkenswerter Aspekt von MaskGCT ist seine Fähigkeit, die Sprachdauer wie ein Mensch flexibel zu steuern – schnell oder langsam, je nach Bedarf. Dies ist ein wahrer Segen für Szenarien, die Sprachausgabe oder -bearbeitung erfordern.

Die Ergebnisse belegen die Leistungsfähigkeit von MaskGCT. In Bezug auf Sprachqualität, Ähnlichkeit, Rhythmus und Klarheit übertrifft es alle bestehenden TTS-Systeme und erreicht sogar ein Niveau, das mit dem von Menschen vergleichbar ist.

Noch beeindruckender ist, dass MaskGCT nicht nur hochwertige Sprache generieren, sondern auch den Stil verschiedener Sprecher imitieren und sogar sprachübergreifende Übersetzungen durchführen kann – ein wahrer Alleskönner.

Natürlich hat MaskGCT noch einige Einschränkungen. Bei der Verarbeitung von stark variierenden Gesichtsausdrücken bei der Sprachsynthese kann es beispielsweise zu Mängeln kommen. Doch die Vorteile überwiegen deutlich. MaskGCT eröffnet dem TTS-Bereich neue Möglichkeiten und bietet ungeahnte Perspektiven für zukünftige Mensch-Maschine-Interaktionen.

Online-Demo: https://huggingface.co/spaces/amphion/maskgct

Projekt-Adresse: https://github.com/open-mmlab/Amphion/tree/main/models/tts/maskgct

Offizielle Webseite: https://voice.funnycp.com/