Recentemente, a empresa de inteligência artificial Anthropic lançou seu novo produto: a API de processamento em lote de mensagens (Message Batches API). Essa nova tecnologia reduz em 50% os custos para empresas que processam grandes volumes de dados, o que sem dúvida é uma ótima notícia para o processamento de big data.

Com essa API, as empresas podem processar de forma assíncrona até 10.000 consultas em 24 horas, tornando os modelos de IA de ponta mais acessíveis.

Com o desenvolvimento contínuo da tecnologia de IA, os desafios enfrentados pelas empresas também aumentam, especialmente no processamento de dados. A API de processamento em lote lançada pela Anthropic é 50% mais barata que o processamento em tempo real, tanto nos custos de tokens de entrada quanto de saída.

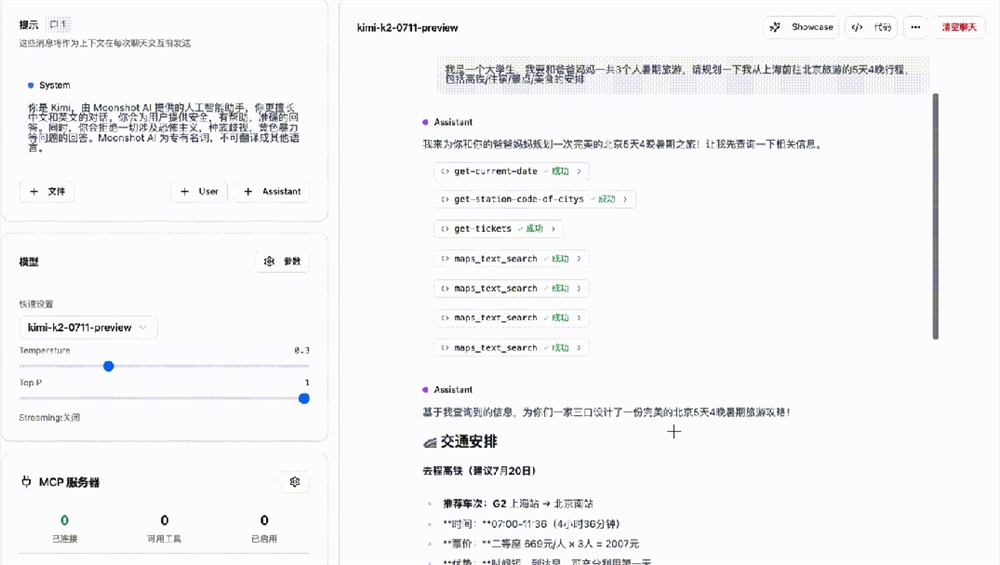

Precificação detalhada

Alta taxa de transferência com metade do custo

Desenvolvedores frequentemente usam o Claude para processar grandes quantidades de dados — desde analisar feedback de clientes até traduzir idiomas — dados que não requerem resposta em tempo real.

De acordo com a empresa, os desenvolvedores não precisam gerenciar sistemas de fila complexos ou se preocupar com limites de taxa. Eles podem usar a API de Lotes para enviar grupos de até 10.000 consultas e deixar a Anthropic processá-las com 50% de desconto. Os lotes serão processados em 24 horas, mas geralmente muito mais rápido. Outras vantagens incluem:

Maior taxa de transferência: aproveite limites de taxa mais altos para lidar com volumes maiores de solicitações, sem afetar seus limites de taxa de API padrão.

Escalabilidade de big data: processe tarefas em larga escala, como análise de conjuntos de dados, classificação de grandes conjuntos de dados ou avaliação ampla de modelos, sem se preocupar com problemas de infraestrutura.

A API de Lotes abre novas possibilidades para o processamento de dados em larga escala, possibilidades que antes eram pouco práticas ou muito caras. Por exemplo, usando o desconto da API de Lotes, analisar todo o repositório de documentos de uma empresa (que pode envolver milhões de arquivos) se torna economicamente mais viável.

Isso não apenas facilita o uso da tecnologia de IA por empresas médias, mas também dá à Anthropic uma vantagem na competição com outras empresas de IA, especialmente a OpenAI. A OpenAI lançou um recurso de processamento em lote semelhante anteriormente, tornando a ação da Anthropic ainda mais significativa.

Curiosamente, essa mudança não é apenas uma simples estratégia de redução de preços, mas uma transformação na filosofia de precificação do setor. Ao oferecer descontos para processamento em larga escala, a Anthropic cria economia de escala para a computação de IA e pode impulsionar a adoção da IA por empresas médias. Imagine a análise de dados em larga escala, antes considerada cara e complexa, agora se tornando tão simples e acessível.

Vale mencionar que a API de processamento em lote da Anthropic já está disponível para seus modelos Claude3.5Sonnet, Claude3Opus e Claude3Haiku. No futuro, esse recurso também será expandido para o Vertex AI do Google Cloud e o Amazon Bedrock.

Embora o processamento em lote seja mais lento que os aplicativos que exigem resposta em tempo real, em muitos cenários de negócios, o processamento "oportuno" costuma ser mais importante que o processamento "em tempo real". As empresas estão começando a priorizar o equilíbrio entre custo e velocidade, o que terá um novo impacto na implementação da IA.

No entanto, apesar das vantagens óbvias do processamento em lote, ele também levanta algumas questões. À medida que as empresas se acostumam com o processamento em lote de baixo custo, isso afetará o desenvolvimento futuro da tecnologia de IA em tempo real? Para manter um ecossistema de IA saudável, é necessário encontrar um equilíbrio adequado entre o avanço do processamento em lote e a capacidade de processamento em tempo real.

Pontos importantes:

✅ A nova API de processamento em lote de mensagens da Anthropic reduz em 50% os custos para empresas que processam grandes volumes de dados.

✅ A nova API suporta até 10.000 consultas assíncronas, melhorando a acessibilidade do processamento de big data.

✅ As empresas estão começando a priorizar o processamento "oportuno" em aplicativos de IA, o que pode representar um desafio para o desenvolvimento de IA em tempo real.