最近、アップルAI研究チームは、次世代のマルチモーダル大規模言語モデル(MLLM)ファミリーであるMM1.5を発表しました。このモデルシリーズは、テキストや画像など複数のデータタイプを組み合わせることができ、複雑なタスクを理解するAIの新たな能力を示しています。視覚的な質問応答、画像生成、マルチモーダルデータの解釈などのタスクは、これらのモデルによってより効果的に解決できるようになりました。

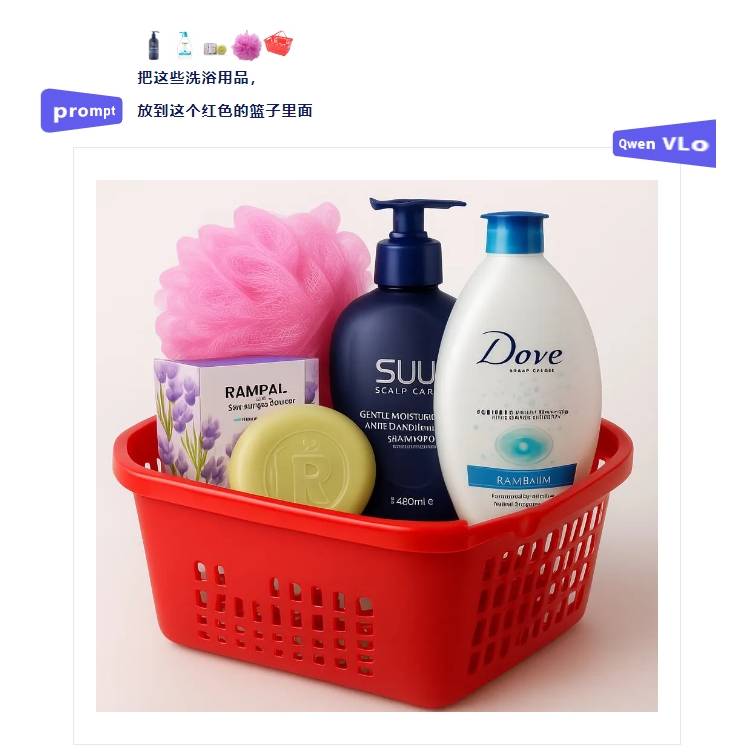

マルチモーダルモデルにおける大きな課題の1つは、異なるデータタイプ間で効果的な相互作用を実現することです。従来のモデルは、テキストが豊富な画像や、きめ細かい視覚タスクの処理において困難に直面することが多々ありました。そこで、アップルの研究チームはMM1.5モデルに革新的なデータ中心化手法を導入し、高解像度のOCRデータと合成画像説明を利用して、モデルの理解能力を強化しました。

この手法により、MM1.5は視覚的理解と位置特定タスクにおいて従来のモデルを凌駕するだけでなく、ビデオ理解に特化したMM1.5-Videoと、モバイルインターフェース分析に特化したMM1.5-UIという2つの専門版モデルも発表されました。

MM1.5モデルのトレーニングは、主に3つの段階に分かれています。

第1段階は、20億組の画像とテキストデータ、6億個のインターリーブされた画像テキストドキュメント、そして2兆個のテキストのみのトークンを用いた大規模な事前トレーニングです。

第2段階は、4500万個の高品質OCRデータと700万個の合成説明による継続的な事前トレーニングを行い、テキストが豊富な画像タスクのパフォーマンスをさらに向上させます。

最終段階である教師あり微調整段階では、厳選された単一画像、複数画像、テキストのみのデータを使用してモデルを最適化し、詳細な視覚的参照と複数画像の推論に優れるようにします。

一連の評価を経て、MM1.5モデルは複数のベンチマークテストで優れたパフォーマンスを示し、特にテキストが豊富な画像の理解において、従来のモデルと比べて1.4ポイントの向上を達成しました。さらに、ビデオ理解に特化したMM1.5-Videoも、強力なマルチモーダル能力により、関連タスクでトップレベルの性能を実現しています。

MM1.5モデルファミリーは、マルチモーダル大規模言語モデルの新たな基準を確立するだけでなく、一般的な画像テキスト理解からビデオやユーザーインターフェース分析まで、幅広いアプリケーションにおける可能性を示しています。

要点:

🌟 ** モデルバリエーション **:パラメータ数が10億から300億までの密集型モデルとMoEモデルを含み、拡張性と柔軟な展開を確保します。

📊 ** トレーニングデータ **:20億組の画像テキストペア、6億個のインターリーブされた画像テキストドキュメント、そして2兆個のテキストのみのトークンを使用しました。

🚀 ** パフォーマンス向上 **:テキストが豊富な画像理解に焦点を当てたベンチマークテストにおいて、以前のモデルと比べて1.4ポイントの向上を達成しました。