Google DeepMindの研究によると、簡単なクエリ攻撃によって、ChatGPTが訓練データの漏洩リスクを抱えていることが明らかになりました。

整合性設定が施されていたとしても、攻撃チームは本番環境のモデルを突破することに成功し、プライバシーとセキュリティへの懸念を改めて浮き彫りにしました。

開発者には、モデルのプライバシーと保護を強化し、より包括的なテストを実施して、大規模言語モデルの安全性を確保することが推奨されます。

Google DeepMindの研究によると、簡単なクエリ攻撃によって、ChatGPTが訓練データの漏洩リスクを抱えていることが明らかになりました。

整合性設定が施されていたとしても、攻撃チームは本番環境のモデルを突破することに成功し、プライバシーとセキュリティへの懸念を改めて浮き彫りにしました。

開発者には、モデルのプライバシーと保護を強化し、より包括的なテストを実施して、大規模言語モデルの安全性を確保することが推奨されます。

【AIデイリー】へようこそ!ここは、毎日人工知能の世界を探求するためのガイドです。毎日、開発者に焦点を当て、技術トレンドを洞察し、革新的なAI製品アプリケーションを理解するのに役立つ、AI分野のホットなコンテンツをお届けします。

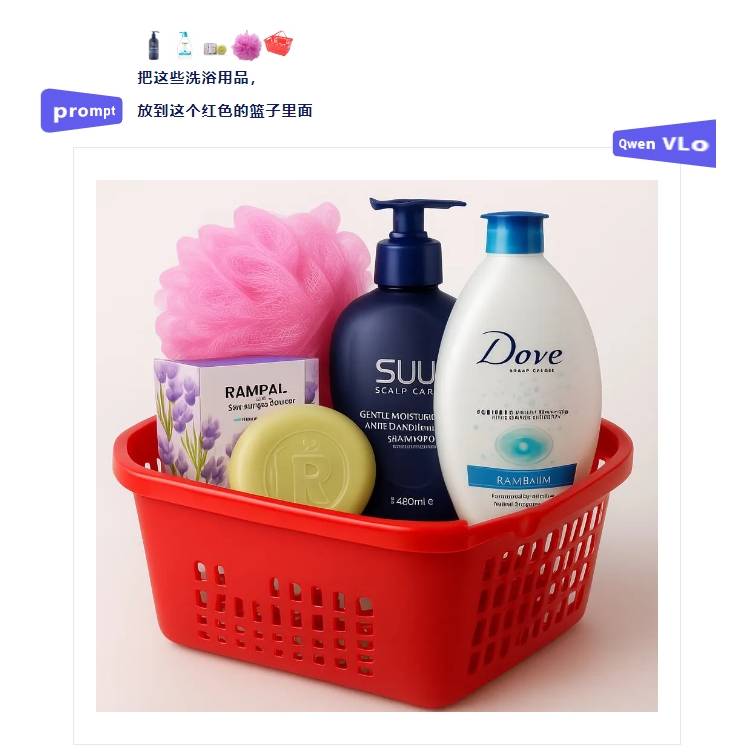

最近、Qwen VLoマルチモーダル大規模モデルが正式にリリースされました。このモデルは画像の内容理解と生成において顕著な進展を遂げており、ユーザーに新たなビジュアルクリエーション体験を提供しています。紹介によると、Qwen VLoは従来のQwen-VLシリーズモデルの利点を引き継ぎつつ、全面的なアップグレードが行われています。このモデルは、世界を正確に理解するだけでなく、理解に基づいて高品質な再創作を行うことができ、実際に「認識から生成」への飛躍を実現しています。ユーザーは現在、Qwen Chat(chat.qwen.ai)で利用できます。

中国初の海洋分野におけるオープンソース大規模モデルであるOceanGPT(聶淵)が浙江省杭州市で正式に発表されました。この革新的な成果は浙江大学海洋精密感知技術全国重点実験室が主導して開発し、中国が海洋科技分野で重要な一歩を踏み出したことを示しています。OceanGPTは基本的な海洋専門知識の質問応答機能を持ち、ソナー画像や海洋観測図などのマルチモーダルデータを自然言語で解釈できます。この能力により、OceanGPTは複雑な海洋データを処理する際にも優れた性能を発揮します。このモデルはさらに採用されています。

Hengbot社は最新のシリウスロボット犬を正式に発表しました。このロボット犬は機敏な運動能力に加え、OpenAIの大規模言語モデルを搭載し、音声での対話が可能で、ダンスやサッカーも行うことができ、本当に多才なペットです!Hengbotによると、シリウスロボット犬は「高速移動」の能力を持ち、音楽のリズムに合わせてダンスできたり、オーナーと「握手」ができたりします。脚部と頭部には14個の運動軸が内蔵されています。

AI音楽企業のSunoは今週木曜日にWavToolを買収したことを発表しました。WavToolはブラウザベースのAIデジタルオーディオワークステーション(DAW)です。この買収により、Sunoは曲の作成および制作における編集能力を強化する予定です。WavToolは2023年にリリースされ、音声分離、AI音声生成、AI音楽アシスタントなど多様な機能を提供しています。これにより、Sunoが新たにリリースした編集インターフェースと統合される見込みです。今回の買収に関する具体的な条件はまだ公開されていませんが、会社のスポークスパーソンはコメントしています。

AIbase【AIニュース】へようこそ!毎日3分で当日のAIの大事件をチェックして、AI業界のトレンドや革新製品の応用を理解しましょう。より多くのAI情報は:https://www.aibase.com/zh1、テンセントが軽量な混元-A13Bモデルをリリースしました。中程度以下のGPU1枚で導入可能。テンセントが発表した混元大モデルシリーズの新メンバーである混元-A13Bモデルは、エキスパート混合(MoE)アーキテクチャを採用しており、総パラメータ数は800億で、アクティブパラメータは130億です。

騰訊は新しい「混元」大規模モデルのメンバーとなる「混元-A13Bモデル」を正式リリースし、オープンソース化しました。このモデルはエキスパート混合(MoE)アーキテクチャに基づいており、総パラメータ数は800億、アクティブパラメータは130億です。トップクラスのオープンソースモデルの性能を維持しつつ、推論遅延と計算コストを大幅に削減し、個人開発者や中小企業にとってよりコスパの良いAIソリューションを提供します。

OpenAIは、次回の開発者カンファレンス(DevDay)の日時と場所を正式に発表しました。2025年10月6日にサンフランシスコで開催される今回のカンファレンスには、1500人以上の開発者が参加する見込みです。これはこれまでで最大規模の開発者イベントとなる予定です。今回のDevDayでは、豊富なプログラムが用意されています。会場でのライブ配信による基調講演もあり、OpenAIが人工知能分野で進める最新の取り組みや今後のビジョンが紹介される予定です。また、参加者は

グーグルは今週木曜日、アメリカのiOSおよびAndroidプラットフォームに、AI技術を使ってユーザーが自分に似た服を着た姿を直感的に見ることができる実験的な新アプリ「Doppl」をリリースしました。このアプリはAIを利用して、ユーザーが服を着たバーチャルイメージを作成し、静的な画像を動画に変換することさえ可能で、ユーザーに没入型の試着体験を提供します。Dopplのコア機能は、ユーザーが自分の全身の写真をアップロードし、その上で服の写真やスクリーンショットをインポートして、自分のデジタルバージョンに適用できるようにすることです。