El 4 de julio de 2025, KuaLun WanWei aprovechó la oportunidad para continuar con el lanzamiento de su segunda generación de modelos de recompensa, la serie Skywork-Reward-V2. Esta serie incluye 8 modelos de recompensa basados en diferentes modelos base, con tamaños de parámetros que van desde 600 millones hasta 8000 millones. Al salir al mercado, logró una victoria completa en los siete principales rankings de evaluación de modelos de recompensa, convirtiéndose en el centro de atención en el campo de los modelos de recompensa de código abierto.

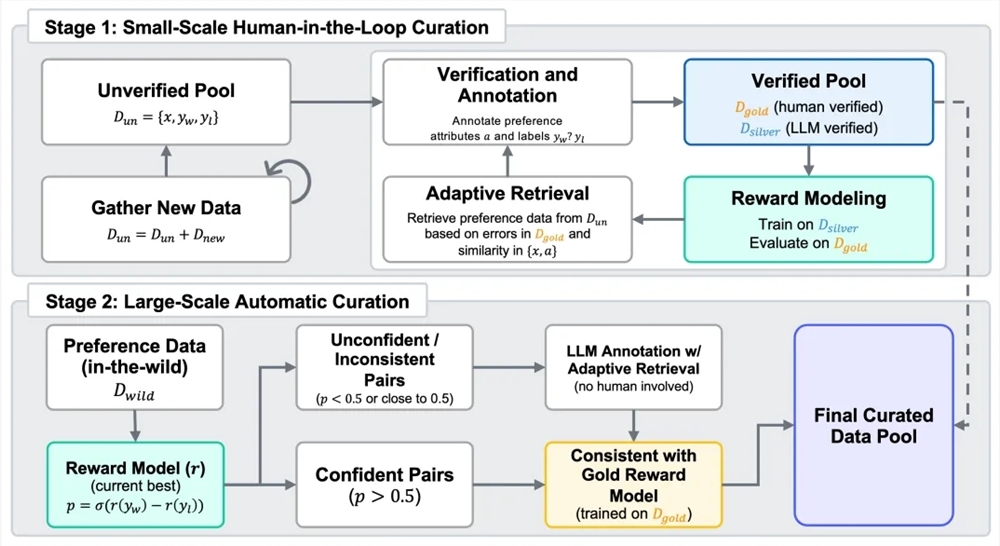

Los modelos de recompensa desempeñan un papel clave en el proceso de aprendizaje por refuerzo con retroalimentación humana (RLHF). Para crear una nueva generación de modelos de recompensa, KuaLun WanWei construyó un conjunto de datos híbrido llamado Skywork-SynPref-40M, que contiene 40 millones de pares de preferencias contrastantes. En el procesamiento de datos, el equipo utilizó un flujo de trabajo en dos etapas con colaboración humano-máquina, combinando la alta calidad de las etiquetas humanas con la capacidad de procesamiento a gran escala de los modelos. En la primera etapa, se construyó primero un depósito inicial no verificado de preferencias, y luego se usó un modelo de lenguaje grande para generar atributos auxiliares. Los anotadores humanos revisaron cuidadosamente parte de los datos según protocolos estrictos y herramientas externas y modelos de lenguaje grande, creando así un pequeño conjunto de datos de "estándar dorado" de alta calidad. Luego, usando las etiquetas de preferencia del conjunto de datos "estándar dorado" como guía, se combinó la generación masiva de alta calidad de "estándar plateado" mediante modelos de lenguaje grande, optimizando repetidamente en múltiples rondas. En la segunda etapa, se cambió hacia la expansión automática a gran escala de datos, utilizando el modelo de recompensa entrenado para realizar una filtración de consistencia, reduciendo la carga de anotación humana al mismo tiempo que equilibraba el tamaño y la calidad de los datos de preferencia.

La serie Skywork-Reward-V2, desarrollada con un conjunto de datos de preferencias híbrido de alta calidad, muestra una amplia aplicabilidad y capacidades destacadas. Cubre múltiples dimensiones, como el alineamiento general con las preferencias humanas, la corrección objetiva, la seguridad, la resistencia al sesgo de estilo y la capacidad de extensión best-of-N. En siete bases de evaluación estándar para modelos de recompensa principales, como Reward Bench v1/v2, PPE Preference & Correctness, RMB, RM-Bench, JudgeBench, alcanzó completamente los niveles más avanzados (SOTA) actuales. Incluso con el modelo más pequeño, Skywork-Reward-V2-Qwen3-0.6B, el rendimiento general casi alcanzó el nivel promedio del modelo más fuerte de la generación anterior. Skywork-Reward-V2-Qwen3-1.7B superó incluso el SOTA actual de los modelos de recompensa de código abierto. El modelo de mayor tamaño, Skywork-Reward-V2-Llama-3.1-8B, superó completamente a todos los estándares principales en pruebas, convirtiéndose en el modelo de recompensa de código abierto con el mejor rendimiento general actual.

Esta serie de modelos también posee la capacidad de cubrir ampliamente múltiples preferencias humanas. En benchmarks de evaluación de preferencias generales, supera a varios modelos con mayores parámetros y a modelos recientes de recompensa generativa; en evaluaciones de corrección objetiva, destaca en tareas intensivas en conocimiento; en varias evaluaciones de habilidades avanzadas, incluidas tareas best-of-N, pruebas de resistencia al sesgo, comprensión de instrucciones complejas y juicios de autenticidad, obtuvo resultados líderes, demostrando una excelente capacidad de generalización y utilidad.

Además, la alta escalabilidad del proceso de selección de datos mejoró significativamente el rendimiento de los modelos de recompensa. Los datos de preferencia seleccionados y filtrados con precisión pueden mejorar continuamente el rendimiento general del modelo en múltiples iteraciones de entrenamiento, especialmente en la expansión automática a gran escala de datos en la segunda etapa. Los experimentos con versiones anteriores mostraron que solo con el 1,8% de datos de alta calidad para entrenar un modelo de 8B, el rendimiento superó al modelo de recompensa SOTA actual de 70B, lo que confirma las ventajas del conjunto de datos Skywork-SynPref en términos de tamaño y calidad.

Dirección de HuggingFace:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

Dirección de GitHub:

https://github.com/SkyworkAI/Skywork-Reward-V2