El equipo de Tencent Hunyuan anunció el lanzamiento de cuatro modelos de pequeño tamaño de código abierto, con parámetros de 0.5B, 1.8B, 4B y 7B. Estos modelos están diseñados específicamente para tarjetas gráficas de nivel de consumo, y son adecuados para escenarios de baja potencia como portátiles, teléfonos móviles, salones inteligentes y hogares inteligentes, y admiten la fine-tuning de bajo costo en dominios verticales. Esta iniciativa enriquece aún más el sistema de modelos de código abierto de Hunyuan, brindando a desarrolladores y empresas más opciones de tamaños de modelos.

El lanzamiento de estos cuatro modelos forma parte de la continuación del esfuerzo de código abierto de los grandes modelos de Tencent Hunyuan, con el objetivo de ofrecer a desarrolladores y empresas más opciones para satisfacer las necesidades de diferentes escenarios. Actualmente, estos modelos ya están disponibles en comunidades de código abierto como GitHub y HuggingFace, y han recibido el apoyo de múltiples plataformas de chips para terminales de nivel de consumo, como Arm, Qualcomm, Intel y MediaTek.

Los cuatro nuevos modelos de código abierto pertenecen a los modelos de razonamiento integrado, destacando por su rápida velocidad de razonamiento y alto rendimiento económico. Los usuarios pueden elegir flexiblemente el modo de pensamiento del modelo según el escenario de uso: el modo de pensamiento rápido ofrece salidas concisas y eficientes, adecuadas para tareas simples; el modo de pensamiento lento se enfoca en resolver problemas complejos, con pasos de razonamiento más completos. En términos de efectividad, estos modelos muestran un buen desempeño en áreas como comprensión del lenguaje, matemáticas y razonamiento, alcanzando niveles líderes en varios conjuntos de pruebas públicos.

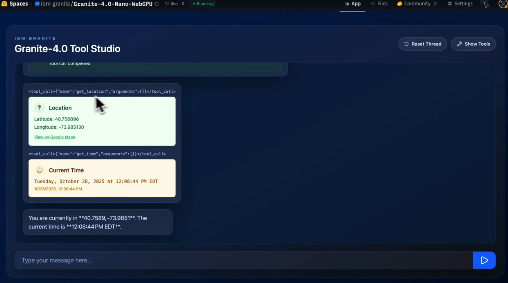

Las características destacadas de estos cuatro modelos son sus capacidades de agente y su capacidad para procesar textos largos. Gracias a una construcción de datos cuidadosa y un diseño de señales de recompensa de aprendizaje reforzado, estos modelos demuestran un buen desempeño en habilidades de agente como planificación de tareas, llamada de herramientas y toma de decisiones complejas, así como en reflexiones. Pueden manejar fácilmente tareas como búsqueda profunda, operaciones de Excel y planificación de guías de viaje. Además, la ventana de contexto original del modelo alcanza los 256k, lo que significa que puede recordar y procesar contenido extremadamente largo equivalente a 400.000 caracteres chinos o 500.000 palabras en inglés, lo que equivale a leer tres novelas de Harry Potter de una vez, recordando todas las relaciones entre los personajes y los detalles de la trama, y pudiendo discutir el desarrollo posterior de la historia basándose en estos contenidos.

En cuanto a la implementación, estos cuatro modelos pueden ser implementados con una sola tarjeta gráfica, y algunos dispositivos como PCs, teléfonos móviles y tablets pueden conectarse directamente. El modelo tiene una fuerte apertura, y marcos de razonamiento principales (por ejemplo, SGLang, vLLM y TensorRT-LLM) y diversos formatos de cuantificación son compatibles con él.

En el ámbito de aplicaciones, estos cuatro modelos de pequeño tamaño pueden satisfacer diversas necesidades, desde dispositivos locales hasta la nube, desde general a especializado, y ya se han aplicado en varios negocios de Tencent, demostrando su utilidad y practicidad mediante la prueba de la práctica. Por ejemplo, gracias a la capacidad original del modelo de contexto prolongado, el asistente de IA de Tencent Meeting y el asistente de preguntas de lectura de WeChat Books lograron entender y procesar completamente el contenido de una reunión y un libro entero de una sola vez. En aplicaciones locales, el管家 de seguridad de Tencent utiliza modelos de pequeño tamaño para mejorar la precisión de la identificación de mensajes de spam, logrando la intercepción en milisegundos y sin subir datos confidenciales; el asistente de inteligencia de la sala de vehículos de Tencent resolvió los puntos problemáticos del entorno de los vehículos mediante una arquitectura de colaboración de dos modelos, aprovechando plenamente las características del modelo de bajo consumo y razonamiento eficiente.

Dirección de experiencia en el sitio web: https://hunyuan.tencent.com/modelSquare/home/list

[GitHub]

Hunyuan-0.5B: GitHub - Tencent-Hunyuan/Hunyuan-0.5B

Hunyuan-1.8B: https://github.com/Tencent-Hunyuan/Hunyuan-1.8B

Hunyuan-4B: https://github.com/Tencent-Hunyuan/Hunyuan-4B

Hunyuan-7B: https://github.com/Tencent-Hunyuan/Hunyuan-7B

[HuggingFace]

Hunyuan-0.5B: https://huggingface.co/tencent/Hunyuan-0.5B-Instruct

Hunyuan-1.8B: https://huggingface.co/tencent/Hunyuan-1.8B-Instruct

Hunyuan-4B: https://huggingface.co/tencent/Hunyuan-4B-Instruct

Hunyuan-7B: https://huggingface.co/tencent/Hunyuan-7B-Instruct