この度、VLM-R1プロジェクトの成功により、この分野に新たな光明がもたらされました。このプロジェクトは、DeepSeekチームによるR1手法を視覚言語モデルへ成功裏に移植したもので、AIによる視覚コンテンツの理解が新たな段階に入ることを意味します。

VLM-R1は、DeepSeekが昨年オープンソース化したR1手法に着想を得ています。この手法は、GRPO(Generative Reward Processing Optimization)強化学習技術を活用し、純粋なテキスト処理において優れた成果を上げていました。今回、VLM-R1チームはこの手法を視覚言語モデルに成功裏に適用し、マルチモーダルAI研究の新たな地平を開拓しました。

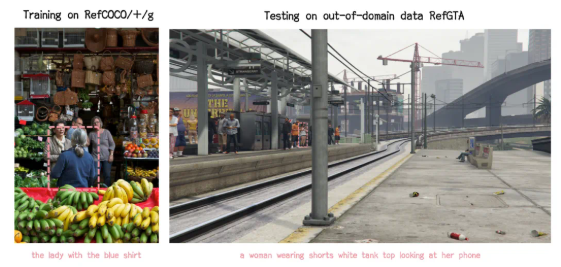

プロジェクトの検証結果では、VLM-R1の性能は驚くべきものでした。まず、R1手法は複雑な状況下でも非常に高い安定性を示し、これは実用化において非常に重要です。次に、このモデルは汎化能力において優れた性能を示しました。比較実験では、従来のSFT(Supervised Fine-Tuning)モデルは、領域外のテストデータにおいて、訓練ステップの増加に伴い性能が低下するのに対し、R1モデルは訓練中に性能を向上させ続けました。これは、R1手法によってモデルが単なる記憶ではなく、視覚コンテンツを真に理解する能力を習得したことを示しています。

さらに、VLM-R1プロジェクトは非常に使いやすく、チームは開発者向けに完全な訓練と評価プロセスを提供しており、開発者は迅速に使い始めることができます。ある実例では、モデルに豪華な食事の写真からタンパク質含有量が一番高い食べ物を探し出すよう指示したところ、正確に答えを返し、さらにタンパク質含有量が一番高い卵焼きを画像内で正確に特定しました。これは、その優れた視覚理解力と推論能力を示しています。

VLM-R1の成功は、R1手法の汎用性を証明しただけでなく、マルチモーダルモデルの訓練に新たな視点を提供し、新たな視覚言語モデル訓練の潮流の到来を予感させます。さらに素晴らしいことに、このプロジェクトは完全にオープンソース化されており、興味のある開発者はGitHubで関連資料を見つけることができます。

総じて、VLM-R1の登場は視覚言語モデル研究に新たな活力を吹き込みました。より多くの開発者が参加し、マルチモーダルAI技術の進歩を促進することを期待しています。