Im Bereich der Verarbeitung natürlicher Sprache (NLP) entwickeln sich große Sprachmodelle (LLMs) rasant und haben in vielen Bereichen bemerkenswerte Fortschritte erzielt. Mit zunehmender Komplexität der Modelle wird die genaue Bewertung ihrer Ausgabe jedoch immer wichtiger. Traditionell verlassen wir uns auf menschliche Bewertungen, doch diese Methode ist zeitaufwendig, schwer zu skalieren und kann mit dem rasanten Fortschritt der Modelle nicht Schritt halten.

Um diese Situation zu verbessern, hat das Salesforce AI-Forschungsteam SFR-Judge vorgestellt, eine Familie von drei großen Sprachmodellen zur Bewertung. Diese Modelle verfügen über 8 Milliarden, 12 Milliarden und 70 Milliarden Parameter und basieren auf Meta Llama3 und Mistral NeMO. SFR-Judge kann verschiedene Bewertungsaufgaben durchführen, darunter paarweise Vergleiche, Einzelbewertungen und binäre Klassifikationen, um Forschungsteams bei der schnellen und effizienten Bewertung neuer Modelle zu unterstützen.

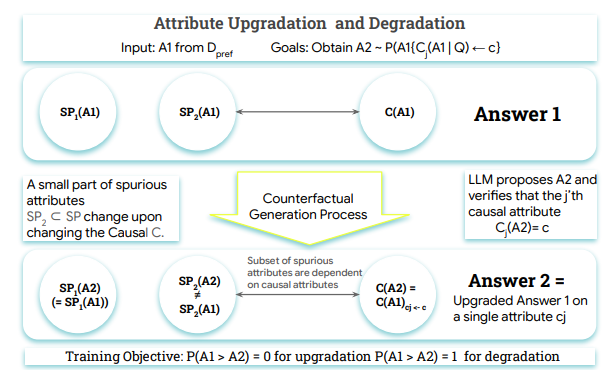

Traditionelle LLM-Bewertungsmodelle weisen oft Verzerrungen auf, wie z. B. Positions- und Längenverzerrungen, die ihre Beurteilung beeinflussen. Um diese Probleme zu überwinden, verwendet SFR-Judge die Direct Preference Optimization (DPO)-Trainingsmethode, bei der das Modell aus positiven und negativen Beispielen lernt, um sein Verständnis von Bewertungsaufträgen zu verbessern, Verzerrungen zu reduzieren und die Konsistenz der Beurteilung zu gewährleisten.

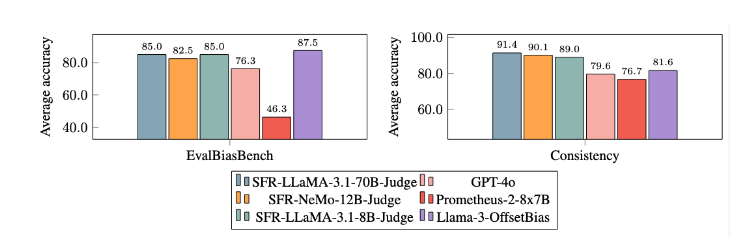

In Tests zeigte SFR-Judge in 13 Benchmark-Tests hervorragende Ergebnisse und übertraf viele bestehende Bewertungsmodelle, darunter auch einige proprietäre Modelle. Besonders in der RewardBench-Rangliste erreichte SFR-Judge eine Genauigkeit von 92,7 %, was die erste und zweite Überschreitung der 90%-Marke für generative Bewertungsmodelle darstellt und seine herausragende Leistung bei der Modellbewertung unterstreicht.

Die Trainingsmethode von SFR-Judge umfasst drei verschiedene Datenformate. Erstens „Chain-of-Thought-Kritik“, die dem Modell hilft, eine strukturierte Analyse der Bewertungsantwort zu erstellen. Zweitens „Standardbewertung“, die den Bewertungsprozess vereinfacht und direkt Feedback gibt, ob die Antwort den Standards entspricht. Drittens „Antwort-Ableitung“, die dem Modell hilft, die Merkmale hochwertiger Antworten zu verstehen und seine Beurteilungsfähigkeit zu stärken. Die Kombination dieser drei Datenformate hat die Bewertungsfähigkeit von SFR-Judge erheblich verbessert.

In zahlreichen Experimenten zeigte sich, dass die SFR-Judge-Modelle bei der Reduzierung von Verzerrungen deutlich besser abschnitten als andere Modelle. Im EvalBiasBench-Benchmark zeigten sie eine hohe paarweise Konsistenz, was bedeutet, dass die Beurteilung des Modells auch bei veränderter Reihenfolge der Antworten stabil bleibt. Dies macht SFR-Judge zu einer zuverlässigen automatisierten Bewertungslösung, die die Abhängigkeit von manuellen Annotationen reduziert und eine skalierbarere Option für die Modellbewertung bietet.

论文入口:https://arxiv.org/abs/2409.14664

Highlights:

📊 Hohe Genauigkeit: SFR-Judge erzielte in 13 Benchmark-Tests 10 beste Ergebnisse, insbesondere in der RewardBench mit einer hohen Genauigkeit von 92,7 %.

🛡️ Verzerrungsreduktion: Das Modell zeigt im Vergleich zu anderen Bewertungsmodellen geringere Verzerrungen, insbesondere bei Längen- und Positionsverzerrungen.

🔧 Vielseitige Anwendung: SFR-Judge unterstützt paarweise Vergleiche, Einzelbewertungen und binäre Klassifikationen und kann an verschiedene Bewertungsszenarien angepasst werden.