Qwen3-4B-Serie wird von Qwen angekündigt. Mit ihrer kompakten Größe und leistungsstarken Leistung bietet dieses neue Modell neue Möglichkeiten für die Edge-Deployment in der Künstlichen Intelligenz.

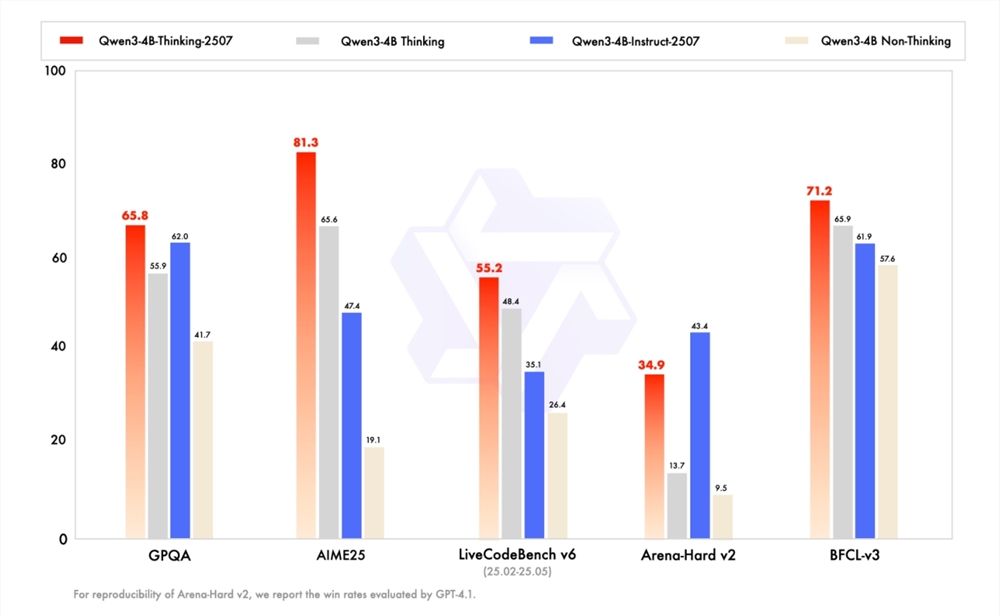

Nachdem im letzten Wochenende die Instruct/Thinking-Version «2507» von Qwen3-235B-A22B und Qwen3-30B-A3B aktualisiert wurden, hat das Entwicklerteam erneut kräftig zugelegt und die kleineren Modelle Qwen3-4B-Instruct-2507 und Qwen3-4B-Thinking-2507 vorgestellt. Diese neuen Modelle haben eine bemerkenswerte Leistungssteigerung erzielt, insbesondere im nicht-rechnerischen Bereich übertrifft Qwen3-4B-Instruct-2507 deutlich das geschlossene GPT4.1-Nano, während Qwen3-4B-Thinking-2507 in der Rechenfähigkeit beeindruckend ist und seine Rechenkapazität mit dem mittelgroßen Qwen3-30B-A3B (thinking) vergleichbar ist.

Das Entwicklerteam ist überzeugt, dass kleine Sprachmodelle (SLM) eine äußerst wichtige Rolle bei der Entwicklung von Agenten-KI (Agentic AI) spielen. Die neu veröffentlichte «2507»-Version von Qwen3-4B ist nicht nur klein, sondern auch leistungsstark und sehr geeignet für die Installation auf Endgeräten wie Handys. Derzeit ist das neue Modell in der ModelScope-Community und Hugging Face offiziell Open Source und hat bereits großes Interesse und Erfahrung von Entwicklern geweckt.

Die allgemeinen Fähigkeiten von Qwen3-4B-Instruct-2507 wurden erheblich verbessert und übertreffen die von kommerziellen, geschlossenen kleinen Modellen wie GPT-4.1-nano, sogar in der Leistung sind sie nahe an Qwen3-30B-A3B (non-thinking) herangekommen. Darüber hinaus deckt dieses Modell mehr sprachliche Längsknowledge ab und verbessert die menschliche Präferenzabstimmung in subjektiven und offenen Aufgaben, wodurch es Antworten liefern kann, die besser den Bedürfnissen der Menschen entsprechen. Überraschenderweise wurde die Kontextverständnisfähigkeit auf 256K ausgedehnt, sodass selbst kleine Modelle lange Texte problemlos verarbeiten können.

Gleichzeitig wurde die Reasoning-Fähigkeit von Qwen3-4B-Thinking-2507 stark verbessert. Bei der AIME25-Bewertung, die sich auf mathematische Fähigkeiten konzentriert, erreichte dieses Modell mit 4B Parametern einen beeindruckenden Score von 81,3 Punkten, was ausreicht, um mit dem mittelgroßen Qwen3-30B-Thinking zu konkurrieren. Darüber hinaus wurde auch seine allgemeine Leistung deutlich gesteigert, wobei der Agent-Score sogar das größere Qwen3-30B-Thinking-Modell übertraf. Mit der gleichen Kontextverarbeitungsfähigkeit von 256K Tokens unterstützt es komplexere Dokumentenanalyse, langfristige Inhaltsgenerierung und interparagrafische Schlussfolgerungen.

Mit der Veröffentlichung der Qwen3-4B-Seriemodell wird die Zukunft der Anwendung von Künstlicher Intelligenz am Edge vielversprechender. Es ist zu erwarten, dass wir in naher Zukunft viele innovative Anwendungen basierend auf diesem Modell sehen werden, die das Leben und die Arbeit der Menschen noch weiter vereinfachen.