Hace poco, el laboratorio Youtu de Tencent anunció oficialmente el lanzamiento de un modelo de representación de texto llamado Youtu-Embedding, con el objetivo de mejorar la eficiencia en áreas como el servicio de atención al cliente inteligente para empresas y la gestión de bases de conocimiento. Este modelo extrae información con precisión, evitando problemas de generación engañosa en modelos grandes en ciertos campos. Este problema suele ocurrir en aplicaciones empresariales, especialmente cuando los usuarios preguntan preguntas específicas, y el modelo puede generar respuestas no relacionadas basándose en material general.

Youtu-Embedding puede abordar efectivamente la mala performance del modelo en diferentes campos. Aunque el modelo se entrena bien en material general, su rendimiento puede disminuir significativamente en campos especializados como derecho o medicina. Tencent abordó este problema desde cero al entrenar este modelo, utilizando una cantidad de 3 billones de Tokens de material en chino e inglés, lo que proporcionó una base sólida para la comprensión del lenguaje del modelo. Además, Tencent también proporcionó datos etiquetados manualmente abundantes, asegurando así la aplicabilidad del modelo en escenarios reales de negocio.

Para que el modelo entienda mejor las intenciones reales de los usuarios, Tencent introdujo un entrenamiento a gran escala con supervisión débil. Con este método de entrenamiento, Youtu-Embedding puede identificar oraciones con expresiones diferentes pero con intenciones similares, estableciendo así relaciones de mapeo precisas en el espacio semántico. Por ejemplo, si un usuario pregunta "¿Cuánto dura la garantía de este producto?" y "¿Si se rompe se puede arreglar gratis?", aunque las formas de expresión sean diferentes, ambas preguntas están buscando información sobre la política de garantía.

En cuanto al entrenamiento multitarea, Tencent diseñó un marco innovador de ajuste fino, asegurando que el modelo pueda adaptarse a diferentes necesidades de tareas. El modelo utiliza un formato de datos uniforme y funciones de pérdida diferenciadas, lo que permite mejorar eficazmente las capacidades de similitud de texto, recuperación y clasificación. Además, mecanismos de muestreo dinámico permiten que el modelo distribuya adecuadamente sus esfuerzos durante el entrenamiento, logrando así un desarrollo equilibrado en diversos tipos de tareas.

Youtu-Embedding ya ha obtenido una alta calificación de 77,46 en el estándar de evaluación semántica china CMTEB, convirtiéndose en uno de los modelos de lenguaje chino con mejor rendimiento. Este modelo es aplicable en múltiples escenarios, incluyendo preguntas y respuestas inteligentes, recomendación de contenido y gestión del conocimiento, mostrando un gran potencial especialmente en la construcción de sistemas de generación mejorada por recuperación (RAG).

El laboratorio Youtu de Tencent continúa dedicándose al desarrollo de tecnologías de código abierto. Además de Youtu-Embedding, también lanzó proyectos como Youtu-Agent y Youtu-GraphRAG, brindando a los desarrolladores más herramientas y recursos para promover el rápido desarrollo de aplicaciones de IA.

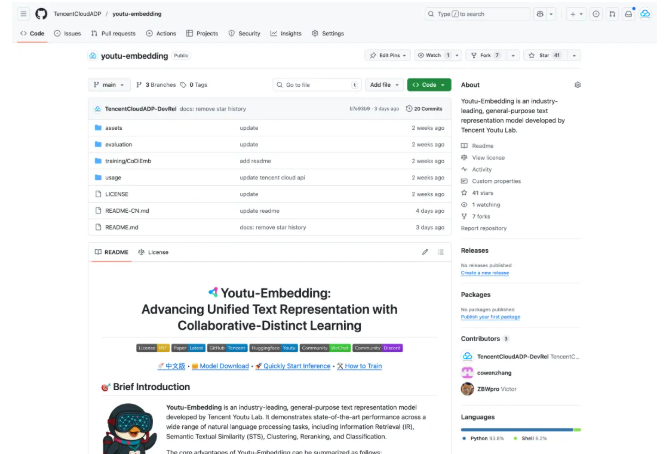

Proyecto: https://github.com/TencentCloudADP/youtu-embedding

Resumen:

🌟 Youtu-Embedding es un modelo de representación de texto de código abierto de Tencent, diseñado para mejorar la eficiencia del servicio de atención al cliente inteligente y la gestión de bases de conocimiento en empresas.

🔍 Este modelo mejora la comprensión de las intenciones de los usuarios mediante un entrenamiento a gran escala con supervisión débil y una evolución colaborativa en múltiples tareas.

📈 En el estándar de evaluación semántica china CMTEB, Youtu-Embedding obtuvo una calificación muy alta de 77,46, demostrando su fuerte rendimiento y potencial de aplicación.