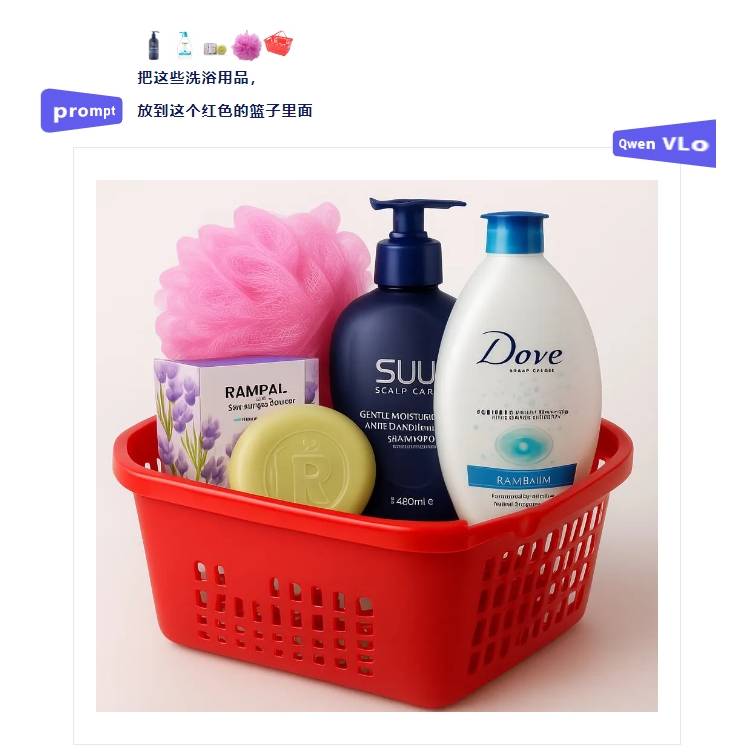

Los investigadores han presentado un nuevo método de indicaciones visuales llamado SoM, que mejora el rendimiento de GPT-4V, el modelo multimodal de OpenAI, en tareas visuales de grano fino. SoM utiliza un modelo de segmentación interactiva para dividir la imagen en diferentes regiones y añadir etiquetas a cada una. De esta manera, GPT-4V puede comprender mejor los objetos y las relaciones espaciales dentro de la imagen, superando en varias tareas visuales a modelos especializados y otros modelos multimodales de código abierto. Este estudio demuestra el potencial de GPT-4V en tareas visuales de grano fino.

Nuevo método de indicaciones visuales SoM para mejorar la precisión y el detalle de GPT-4V

站长之家

Este artículo proviene de AIbase Daily

¡Bienvenido a la columna [AI Diario]! Aquí está tu guía diaria para explorar el mundo de la inteligencia artificial. Todos los días te presentamos el contenido más destacado en el campo de la IA, centrándonos en los desarrolladores para ayudarte a comprender las tendencias tecnológicas y conocer las aplicaciones innovadoras de productos de IA.

![¡Llegó un nuevo poder abierto! FLUX.1 Kontext [dev] desafía a GPT-4o, entrando en una nueva era de edición de imágenes](https://upload.chinaz.com/2025/0627/6388661110722937329608910.png)