À l'ère de la concurrence des grands modèles d'IA, l'inférence efficace et le traitement des longs contextes sont devenus des points critiques pour les développeurs. Récemment, l'équipe du modèle Bailing de l'entreprise Ant a officiellement ouvert le code de Ring-flash-linear-2.0-128K, un modèle innovant conçu spécifiquement pour le codage de textes extrêmement longs. Ce modèle repose sur une mécanique d'attention linéaire hybride et une architecture MoE (Mixture of Experts) sparse, atteignant des performances SOTA (state-of-the-art) dans des domaines tels que la génération de code et les agents intelligents avec seulement 6,1 milliards de paramètres, ce qui est comparable à un modèle dense de 40 milliards de paramètres. AIbase a analysé en exclusivité ses caractéristiques révolutionnaires à partir des publications officielles de Hugging Face et des rapports techniques, afin d'aider les développeurs à embrasser une nouvelle ère de programmation IA efficace.

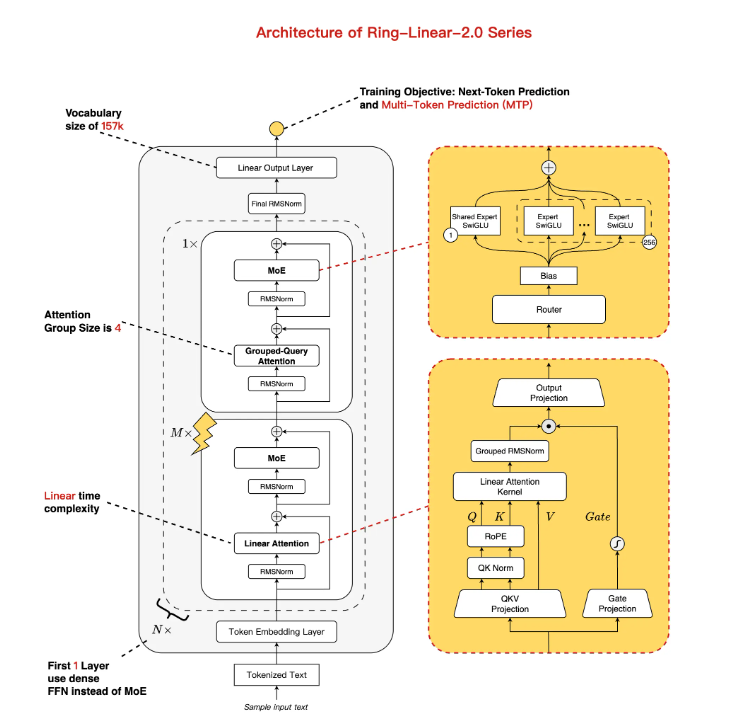

Architecture innovante : mélange d'attention linéaire et standard, optimisation MoE pour équilibrer performance et efficacité

Ring-flash-linear-2.0-128K est basé sur Ling-flash-base-2.0 et a été amélioré, avec un volume total de paramètres de 104 milliards. Grâce à un taux d'activation de 1/32 des experts et à des couches de traitement multivariées (MTP), seuls 6,1 milliards de paramètres sont activés (4,8 milliards hors embeddings), permettant une complexité quasi-linéaire en temps et constante en espace. Le point fort réside dans le mécanisme d'attention hybride : la structure principale utilise un module d'attention linéaire développé en interne, complété par un petit nombre d'attentions standards, spécialement conçu pour accélérer les calculs sur des séquences longues. Par rapport aux modèles traditionnels, cette architecture permet une vitesse de génération supérieure à 200 tokens/s sur du matériel H20, même avec un contexte de 128K, triplant la vitesse habituelle, et s'adapte parfaitement aux scénarios limités en ressources.

Amélioration de l'entraînement : micro-réglage supplémentaire sur 1T de tokens + RL stable, capacité de raisonnement complexe passant au niveau supérieur

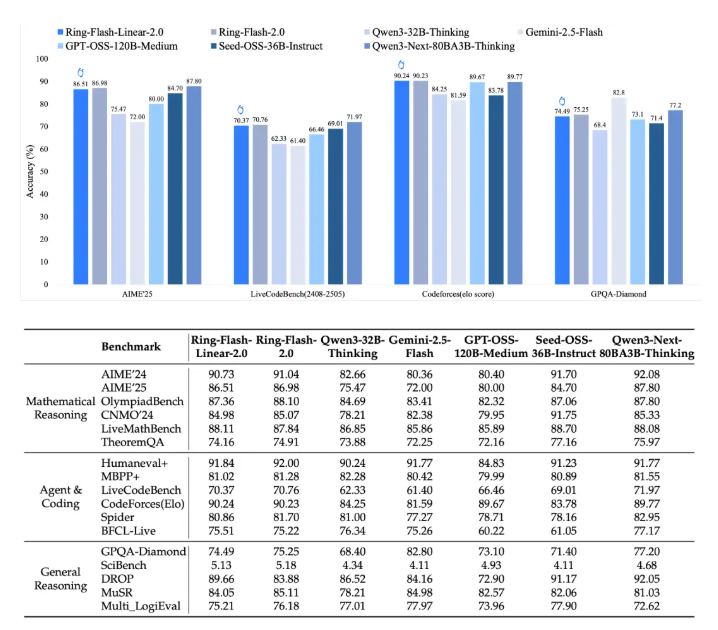

Le modèle provient de Ling-flash-base-2.0, et a été entraîné sur un ensemble de données supplémentaires de qualité de 1T de tokens, combiné à un micro-réglage supervisé stable (SFT) et à un apprentissage par renforcement en plusieurs étapes (RL), résolvant ainsi le problème de stabilité lors de l'entraînement des raisonnements longs avec MoE. Grâce à l'algorithme « icepop » développé par Ant, le modèle montre une excellente stabilité sur des tâches difficiles : il obtient un score élevé de 86,98 au concours mathématique AIME2025, un Elo de CodeForces de 90,23, et dépasse les modèles denses inférieurs à 40 milliards de paramètres (comme Qwen3-32B) dans les tâches logiques et la rédaction créative. Les tests de base montrent qu'il rivalise avec les modèles d'attention standard (comme Ring-flash-2.0) et remporte la course contre plusieurs modèles MoE/Dense open source.

Technologie avancée pour les longs contextes : prise en charge native de 128K + extension YaRN jusqu'à 512K, aucun blocage pour les entrées/sorties longues

Pour répondre aux problèmes liés au codage, Ring-flash-linear-2.0-128K prend nativement en charge une fenêtre de contexte de 128K, permettant aux développeurs d'étendre facilement jusqu'à 512K grâce à la technologie YaRN. Dans les scénarios de saisie/sortie longue, le débit pendant la phase de pré-remplissage (Prefill) est presque cinq fois plus rapide que celui de Qwen3-32B, et la phase de décodage (Decode) est accélérée de dix fois. Des tests ont montré que, dans les tâches de codage avec un contexte de 32K+, le modèle maintient une haute précision sans problèmes de "décalage" ou de flottaison, et est particulièrement adapté aux scénarios complexes tels que le développement frontend, la génération de code structuré et la simulation d'agents.

Ouverture immédiate d'accès : déploiement sur les deux plateformes Hugging Face et ModelScope, guide d'utilisation sans barrières

Pour accélérer l'implémentation communautaire, l'équipe Bailing a synchronisé les poids du modèle sur Hugging Face et ModelScope, prenant en charge les formats BF16/FP8. Après l'installation des dépendances, il suffit d'utiliser les cadres Transformers, SGLang ou vLLM pour charger le modèle en quelques clics :

- Exemple Hugging Face : pip install flash-linear-attention==0.3.2 transformers==4.56.1, puis utiliser generate pour générer directement des codes longs.

- Inférence en ligne avec vLLM : avec un tensor-parallel-size de 4, l'utilisation GPU atteint 90 %, et l'API est supportée.

Le rapport technique est disponible sur arXiv (https://arxiv.org/abs/2510.19338), les développeurs peuvent télécharger et tester immédiatement.

L'ère de l'attention linéaire MoE arrive, Bailing d'Ant mène le mouvement de l'IA de programmation efficace

Cette ouverture marque un nouveau progrès pour Bailing d'Ant sur la voie « MoE + longues chaînes de pensée + RL », passant de la série Ling2.0 à Ring-linear, avec une amélioration de l'efficacité de plus de sept fois. AIbase pense que, dans l'onde de raisonnement long avec un coût réduit de 1/10, ce modèle va transformer l'écosystème des développeurs : les débutants peuvent générer instantanément des scripts complexes, les systèmes d'agents deviennent plus intelligents, et les applications d'entreprise peuvent être déployées sans barrière. À l'avenir, avec l'arrivée du modèle Ring-1T de 1 trillion, les modèles MoE nationaux pourraient dominer le marché mondial de l'IA efficace.

Conclusion

Ring-flash-linear-2.0-128K incarne un nouveau paradigme d'ouverture d'IA avec « petite activation, grande performance », offrant un moteur puissant pour le codage à très longue portée. Développeurs, essayez-le dès maintenant sur Hugging Face/ModelScope ! AIbase suivra les évolutions de la communauté.