「深呼吸」让大模型表现更佳!谷歌DeepMind利用大语言模型生成Prompt,还是AI更懂AI

新智元

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

【AI日报热点速览】1.美图RoboNeo上线全能AI影像处理工具,支持自然语言修图、品牌设计和网页制作;2.Unsloth AI发布1.8bit量化Kimi K2模型,体积缩小80%性能不变;3.谷歌Gemini嵌入模型登顶MTEB排行榜;4.Amazon推出AI代码编辑器Kiro,支持Claude 4等模型;5.Claude新增工具目录功能提升AI工作流效率;6.MiniMax完成3亿美元融资,估值超40亿美元;7.UTCP协议发布,实现AI代理直接调用工具;8.Grok推出动漫AI伴侣功能;9.Grok网页版上线语音模式;10.Kimi K2在OpenRouter市场份额超越xAI。

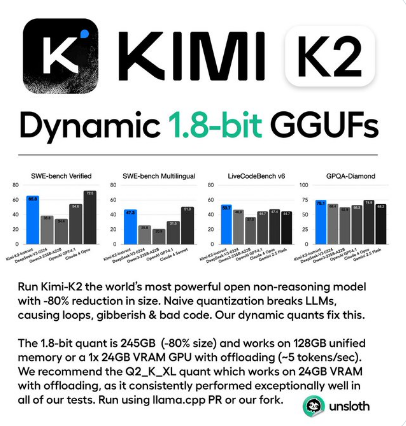

Unsloth AI成功将Moonshot AI的Kimi K2模型量化为1.8bit版本,模型体积从1.1TB压缩至245GB,降幅达80%,同时保持全部性能。这款1万亿参数的开源大模型采用MoE架构,擅长代码生成和推理任务。量化后的版本可在512GB内存的M3Ultra设备上运行,大幅降低部署成本。该技术突破使Kimi K2成为GPT-4.1等商业模型的有力竞争者,为中小企业提供高性能AI解决方案。尽管商业化需遵守开源标注要求,但这一进展显著推动了开源AI生态发展,有望在教育、医疗等领域实现更广泛应用。

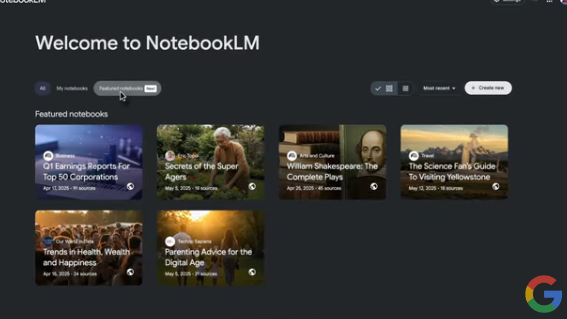

谷歌推出NotebookLM"特色"笔记本功能,提供预装研究内容并与AI工具深度交互。该功能由谷歌与知名作家、出版物合作打造,涵盖长寿科学、育儿建议等8个主题。用户可获取AI总结、提问及收听AI播客式讨论。过去4周已有14万用户分享公开笔记本,未来将持续扩展内容库。

Meta或将放弃开源AI战略转向闭源模式。据报其超级智能实验室正讨论停用开源模型"Behemoth",该模型因测试不佳已推迟发布。虽然发言人强调仍将保持开源立场,但这一转变若成真,将颠覆扎克伯格此前推崇的开源理念。Meta面临巨大AI研发成本压力,在商业化方面落后于OpenAI等竞争对手。此举可能影响整个AI行业格局,削弱开源生态,使权力重回大公司手中,并冲击依赖开源模型的中小企业。中国等国家积极拥抱开源AI的战略也可能因此受到影响。

Meta被曝可能放弃开源AI战略,转向闭源模式。据《纽约时报》报道,其已完成训练的下一代开源模型Behemoth因性能不佳被搁置,新成立的超级智能实验室正讨论转向闭源。Meta发言人虽坚称开源立场未变,但承认未来将混合开发开放和封闭模型。若CEO扎克伯格批准这一转变,将标志着Meta核心AI战略的重大调整。此举可能重塑全球AI格局,减缓开源势头,影响初创企业生态,并在地缘竞争中让中国在开源领域获得更大优势。Meta面临商业化压力,闭源或能提供更清晰的盈利路径。

国内AI公司MiniMax完成近3亿美元融资,投后估值超40亿美元。本轮引入上海国资等新股东,历时半年完成,使其成为国内仅有的两家估值达300亿元的大模型公司之一。公司由前商汤高管创立,此前获阿里、腾讯等知名机构投资。据传已在筹备赴港上市。公司未对融资消息置评。

OpenAI收购Windsurf计划失败,谷歌成功挖角其CEO及核心团队加入DeepMind。Windsurf前身Codeium曾获2亿美元融资,估值达12.5亿美元。谷歌获得其部分技术非独家许可,但未收购公司。近期代码生成初创企业热度下降,面临Anthropic、谷歌等大模型竞争。Windsurf将由原高管接管,继续保持独立运营。

谷歌发布首个Gemini嵌入模型,在MTEB基准测试中以68.37分超越OpenAI,成为当前最强嵌入模型。该模型基于双向Transformer架构,采用多阶段训练策略,支持多语言任务,成本仅0.15美元/百万token。其出色表现将推动搜索、推荐等AI应用发展。

硅基流动平台上线月之暗面开源的MoE模型Kimi K2,该模型总参数1T,激活参数32B,支持128K上下文长度,在编码和智能体任务中表现优异。定价为输入4元/百万Tokens、输出16元/百万Tokens。新用户注册可获14元试用金。模型具备三大技术优势:15.5T Tokens大规模训练、MuonClip优化器稳定扩展、专为智能体任务设计。测试显示其在编程、数学推理等方面表现突出,用户评价积极。平台同时上线编程大模型Kimi-Dev-72B,国内外用户均可体验。

【AI日报速览】1.月之暗面开源万亿参数Kimi K2大模型,采用混合专家架构,具备工具调用和代码执行能力。2.智源发布RoboBrain2.0和RoboOS2.0,提升机器人时空认知与多智能体协作能力。3.通义千问推出桌面客户端,新增图像生成等功能。4.IndexTTS2实现本地化语音克隆与情绪控制,革新配音技术。5.HuggingFace开源机器人Reachy Mini热销。6.Meta StreamDiT实现单GPU实时视频生成。7.PixVerse新增多关键帧生成功能。8.特斯拉Grok AI助手仅支持AMD处理器车型。9.OpenAI推迟开源模型发布以加强安全测试。10.Liquid AI开源边缘AI模型LFM2,性能显著提升。11.AI"时间穿越"挑战在社交媒体走红。