文章指出,随着AI成为投资热点,很多投资人表面热情看AI项目,实则频繁换口,技术能力有限,融资意愿不强,存在“假装看AI”的现象。部分投资人还利用交流之名获取创业者商业机密,损害创业者对投资行业的信任。作者认为,假装看AI的行为可能危害整个投资行业的诚信体系,投资人应该保持专业态度,与创业者进行真诚交流。

文章指出,随着AI成为投资热点,很多投资人表面热情看AI项目,实则频繁换口,技术能力有限,融资意愿不强,存在“假装看AI”的现象。部分投资人还利用交流之名获取创业者商业机密,损害创业者对投资行业的信任。作者认为,假装看AI的行为可能危害整个投资行业的诚信体系,投资人应该保持专业态度,与创业者进行真诚交流。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

2026年央视春晚将全面应用8K超高清技术,并采用全国产化设备,提升画面质量和沉浸感。同时,央视听媒体大模型2.0将首次亮相,为节目制作和互动体验带来创新。

蚂蚁阿福App升级推出“长辈模式”,界面字体图标更大,默认语音交互,支持直接电话咨询健康问题。同时保留多方言提问功能,并新增三种数字人形象自定义选项,未来将提供更多选择。

Anthropic推出面向企业法务的AI工具,引发全球法律信息服务行业股价震荡。市场认为AI已实质性威胁传统信息服务模式,欧美相关板块受挫,法律出版巨头RELX股价一度大跌约14%。

Fitbit创始人詹姆斯·帕克与埃里克·弗里德曼再创业,成立AI公司Luffu。新公司聚焦家庭健康,旨在通过人工智能整合碎片化的家庭成员健康信息,构建智能家庭护理系统,以应对美国约6300万家庭照护者的需求,实现从个人健康监测到家庭健康联结的转变。

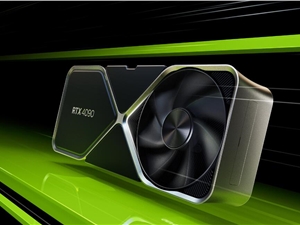

英伟达CEO黄仁勋重申,对OpenAI的千亿美元投资计划正稳步推进,否认双方关系紧张传闻。去年9月双方宣布该投资,旨在支持OpenAI构建人工智能。

北京人形机器人创新中心近日完成超7亿元首轮融资,获北京市人工智能产业投资基金、亦庄国投等多家顶级机构及百度等产业方战略投资,标志着这一国家级平台获资本市场高度认可。

凌云光调整股票回购计划,拟注销348万股用于员工持股计划的股票,以提升公司长期投资价值和每股收益,增强投资者信心。此举需经股东大会审议生效,并顺应国家推动人形机器人产业发展的政策利好。

AI社交平台Moltbook因配置错误导致数据库公开,近15万个AI智能体的电子邮件、登录令牌及API密钥面临泄露风险。该平台旨在构建AI自主交流社区,此次安全漏洞引发严重信任危机。

特斯拉宣布第三代Optimus人形机器人即将量产,目标年产量达百万台,标志着AI机器人进入大规模商业化阶段。该机器人核心突破在于具备“观察学习”能力,底层逻辑全新设计。

印尼政府有条件解除了对xAI聊天机器人Grok的封锁。此前因内容违规被限制,X平台提交改进措施后获准恢复。