Forscher von Meta und der Universität Waterloo haben kürzlich gemeinsam ein neues KI-System namens MoCha vorgestellt, das aus einfachen Textbeschreibungen vollständige Animationsfiguren mit synchronisierter Sprache und natürlichen Bewegungen generieren kann.

Diese innovative Technologie verspricht, die Effizienz und Ausdruckskraft der Inhaltserstellung erheblich zu steigern und in verschiedenen Bereichen ein enormes Anwendungspotenzial zu bieten.

Traditionelle Methoden überholt: Ganzkörperanimation und präzise Lippensynchronisation

Im Gegensatz zu bisherigen KI-Modellen, die sich auf Gesichtsausdrücke konzentrierten, zeichnet sich MoCha durch die Fähigkeit aus, natürliche Ganzkörperbewegungen zu rendern. Ob aus der Nähe oder aus halber Distanz aufgenommen, generiert das System anhand des Textinhalts detaillierte Bewegungen, einschließlich Lippensynchronisation, Gestik und Interaktionen zwischen mehreren Charakteren. Frühe Demos konzentrierten sich hauptsächlich auf den Oberkörper und zeigten, wie das System die Lippenbewegungen der Figur präzise auf den Dialog abstimmt und die Körpersprache natürlich mit der Bedeutung des Textes übereinstimmt.

Um eine präzisere Lippensynchronisation zu erreichen, führte das Forschungsteam einen neuartigen „Audio-Video-Fenster-Aufmerksamkeits“-Mechanismus ein. Dieser Mechanismus löst effektiv zwei langjährige Herausforderungen bei der KI-Videogenerierung: die Informationskompression während der Videoverarbeitung bei gleichzeitiger Aufrechterhaltung der vollständigen Audioauflösung und die bei der parallelen Videogenerierung leicht auftretenden Lippenbewegungsfehler. Das Kernprinzip besteht darin, jede Einzelbild nur auf einen bestimmten Bereich der Audiodaten zugreifen zu lassen. Diese Methode ahmt die Funktionsweise der menschlichen Sprache nach – die Mundbewegungen hängen vom unmittelbaren Klang ab, während die Körpersprache dem breiteren Textmuster folgt. Durch das Hinzufügen von Markierungen vor und nach jedem Audio-Frame erzeugt MoCha flüssigere Übergänge und eine genauere Lippensynchronisation.

Einfache Verwaltung mehrerer Charaktere, effizientes und übersichtliches Prompt-System

Bei der Bearbeitung von Szenen mit mehreren Charakteren hat das MoCha-Team ein einfaches und effizientes Prompt-System entwickelt. Benutzer müssen die Charakterinformationen nur einmal definieren und können diese Charaktere dann über einfache Tags (z. B. „Person1“, „Person2“) in verschiedenen Szenen wiederverwenden. Dies vermeidet den mühsamen Prozess der wiederholten Beschreibung von Charakteren und vereinfacht die Erstellung von Animationen mit mehreren Charakteren erheblich.

Überragende Leistung, übertrifft vergleichbare Systeme

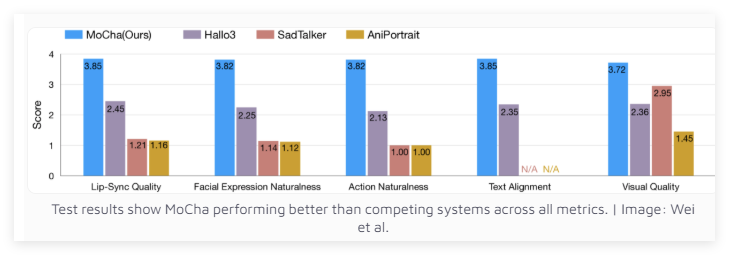

In Tests mit 150 verschiedenen Szenarien übertraf MoCha vergleichbare Systeme sowohl in Bezug auf die Lippensynchronisation als auch auf die Qualität der natürlichen Bewegungen. Unabhängige Gutachter lobten die Realitätsnähe der von MoCha generierten Videos. Die Testergebnisse zeigen, dass MoCha in allen Kennzahlen seine Konkurrenz übertrifft.

Das Meta-Forschungsteam sieht für MoCha ein enormes Anwendungspotenzial in Bereichen wie digitale Assistenten, virtuelle Avatare, Werbung und Bildungsinhalte. Ob das System Open Source sein wird oder als Forschungsprototyp verbleibt, wurde von Meta jedoch noch nicht bekannt gegeben. Es ist erwähnenswert, dass die Entwicklung von MoCha in eine Zeit fällt, in der große Social-Media-Unternehmen um die Entwicklung von KI-gestützter Videotechnologie wetteifern.

Zuvor hatte Meta bereits MovieGen vorgestellt, und die Muttergesellschaft von TikTok, ByteDance, entwickelt aktiv eigene KI-Animationssysteme, darunter INFP, OmniHuman-1 und Goku. Dieser Wettlauf um KI-Videotechnologie wird zweifellos die Weiterentwicklung und Verbreitung der entsprechenden Technologien beschleunigen.

Projektseite: https://top.aibase.com/tool/mocha