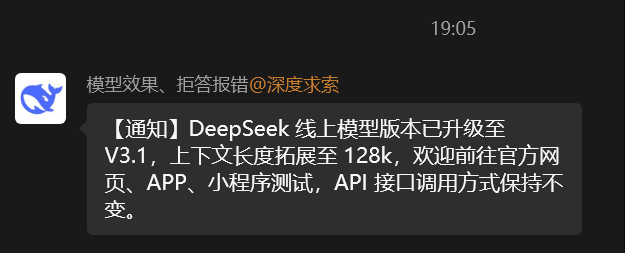

Beijing, 19. August 2025 — DeepSeek hat heute offiziell die neueste Version seines Flaggschiff-Modells für große Sprachmodelle, DeepSeek-V3.1, veröffentlicht. Dieser neue Standort erhöht die Kapazität des Kontextfensters von 64k Tokens auf 128k Tokens, wobei die vollständige API-Kompatibilität gewahrt bleibt. Dies markiert einen weiteren wichtigen Meilenstein in der Entwicklung von Open-Source-KI-Technologien bei der Firma.

Technische Verbesserungen und Marktpositionierung

Die Veröffentlichung von DeepSeek-V3.1 erfolgte nur fünf Monate nach dem Release von DeepSeek-V3-0324. Die V3-0324-Version wurde im März dieses Jahres veröffentlicht und brachte erhebliche Verbesserungen in den Kernleistungsindikatoren wie Schlussfolgerungsfähigkeit, Programmierleistung und mathematischer Berechnung mit sich. Sie legte somit eine solide Grundlage für die weitere Optimierung der V3.1-Version.

Inmitten der zunehmenden globalen Konkurrenz im Bereich KI-Technologie zeigt DeepSeeks schnelle Produktiterationstakt seine technologischen Innovationsfähigkeiten und Marktreaktionsgeschwindigkeit. Obwohl sie durch internationale Sanktionen auf den Zugang zu Hochleistungsrechenressourcen beschränkt sind, hat DeepSeek durch innovative effiziente Trainingsmethoden und Optimierungsstrategien in der Open-Source-Bereich weiterhin einen starken Wettbewerbsvorteil bewahrt.

Kerntechnische Merkmale

Erweiterte Kontextverarbeitungsfähigkeit: Das zentrale Upgrade der V3.1-Version besteht darin, dass das Kontextfenster verdoppelt wurde. Dadurch kann das Modell längere Dialogsequenzen und komplexe Anfragen verarbeiten und bietet den Benutzern ein kohärenteres und tieferes Interaktionserlebnis.

Optimierte Ausgabestruktur: Aufgrund früherer Nutzerfeedbacks wurden die sprachlichen Ausdrucksweisen der V3.1 erheblich optimiert. Das Modell generiert nun häufiger strukturierte Ausgabedaten, einschließlich Tabellen und Listen, was die Lesbarkeit und Praxistauglichkeit der Informationen verbessert.

Verbesserte physikalische Verständnisfähigkeit: Das neue Modell zeigt deutliche Verbesserungen bei der Simulation physikalischer Phänomene und der Verständnis relevanter Konzepte, was für wissenschaftliche Berechnungen und Ingenieursanwendungen stärkere Unterstützung bietet.

Architekturbeibehaltung und Optimierung: Die V3.1 verwendet weiterhin die bewährte Experten-Mischarchitektur (MoE, Mixture of Experts), die speziell für normale Inferenzaufgaben optimiert wurde. In diesen Anwendungsszenarien ist es nicht erforderlich, den „DeepThink“-Tiefenmodus zu aktivieren. So wird sowohl die Bearbeitungseffizienz als auch die Qualität der Ausgabe gewährleistet.

Bereitstellung und Kompatibilität

DeepSeek-V3.1 ist bereits auf mehreren Plattformen verfügbar, darunter die DeepSeek-Website, die mobile Anwendung sowie WeChat Mini-Programme. Die Firma betonte besonders die vollständige rückwärtskompatible API-Schnittstelle, um sicherzustellen, dass bestehende Benutzer und Entwickler problemlos auf die neue Version wechseln können, ohne vorhandene integrierte Codes oder Aufrufmethoden zu ändern.

Open-Source-Zusage und Zukunftsvision

Obwohl bis zum Zeitpunkt der Veröffentlichung noch keine Modellgewichte der V3.1-Version auf der Hugging Face-Plattform zum Download bereitgestellt wurden, betonte DeepSeek erneut sein langfristiges Engagement gegenüber der Open-Source-Gemeinschaft und versprach, weiterhin den Open-Source-Veröffentlichungsstrategie zu folgen, um der globalen KI-Forschergemeinde und Entwicklern technische Unterstützung zu bieten.

Die Veröffentlichung von DeepSeek-V3.1 festigt die führende Position der Firma in der Innovation im Bereich KI-China und trägt auch zu bedeutenden technischen Fortschritten im Bereich der Open-Source-Großsprachmodelle bei. Mit der signifikanten Erhöhung der Kontextverarbeitungskapazität und der Umsetzung mehrerer Leistungsverbesserungen wird V3.1 voraussichtlich in unternehmensrelevanten Anwendungen, akademischen Forschungen und persönlichen Nutzungsszenarien größere Werte liefern.