El 27 de marzo, el equipo de Qwen de Alibaba Cloud anunció el lanzamiento de Qwen2.5-Omni, el nuevo modelo insignia multimodal de extremo a extremo de la familia de modelos Qwen. Este nuevo modelo está diseñado para la percepción multimodal completa y puede procesar sin problemas múltiples formas de entrada, como texto, imágenes, audio y video, generando simultáneamente texto y salida de síntesis de voz natural a través de una respuesta en tiempo real.

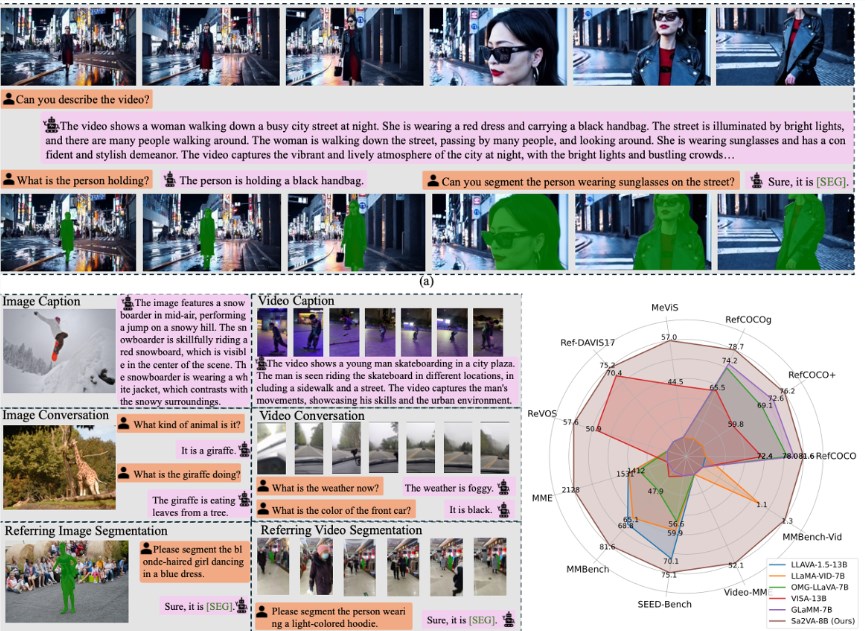

Qwen2.5-Omni utiliza la innovadora arquitectura Thinker-Talker, un modelo multimodal de extremo a extremo diseñado para admitir la comprensión intermodal de texto, imágenes, audio y video, y generar respuestas de texto y voz natural de forma continua. El módulo Thinker, como el cerebro, procesa la entrada multimodal y genera representaciones semánticas de alto nivel y el contenido de texto correspondiente; el módulo Talker, similar al órgano vocal, recibe de forma continua las representaciones semánticas y el texto generados por Thinker en tiempo real, sintetizando unidades de voz discretas de forma fluida. Además, este modelo propone una nueva técnica de codificación posicional, TMRoPE (Time-aligned Multimodal RoPE), que logra la sincronización precisa de la entrada de video y audio mediante la alineación del eje temporal.

El modelo muestra un excelente rendimiento en la interacción en tiempo real de audio y video, admite la entrada por bloques y la salida inmediata, y puede lograr una interacción completamente en tiempo real. En cuanto a la naturalidad y estabilidad de la generación de voz, Qwen2.5-Omni supera a muchas soluciones alternativas de flujo y no flujo existentes. En términos de rendimiento multimodal completo, Qwen2.5-Omni muestra un rendimiento excepcional cuando se realizan pruebas de referencia con modelos unimodales de igual tamaño; su capacidad de audio es superior a la de Qwen2-Audio de tamaño similar y mantiene el mismo nivel que Qwen2.5-VL-7B. Además, Qwen2.5-Omni muestra un rendimiento comparable al procesamiento de entrada de texto en el seguimiento de instrucciones de voz de extremo a extremo, y presenta un rendimiento excelente en pruebas de referencia como la comprensión de conocimientos generales MMLU y el razonamiento matemático GSM8K.

Qwen2.5-Omni supera a los modelos unimodales y modelos de código cerrado de tamaño similar en varias modalidades, incluyendo imágenes, audio y audio-video, como Qwen2.5-VL-7B, Qwen2-Audio y Gemini-1.5-pro. En la tarea multimodal OmniBench, Qwen2.5-Omni logró el mejor rendimiento (SOTA). En las tareas unimodales, Qwen2.5-Omni mostró un rendimiento excelente en varios campos, incluyendo reconocimiento de voz (Common Voice), traducción (CoVoST2), comprensión de audio (MMAU), razonamiento de imágenes (MMMU, MMStar), comprensión de video (MVBench) y generación de voz (Seed-tts-eval y percepción subjetiva de naturalidad).

Actualmente, Qwen2.5-Omni está disponible de forma abierta y de código abierto en Hugging Face, ModelScope, DashScope y GitHub. Los usuarios pueden experimentar las funciones interactivas a través de una demostración o iniciar chats de voz o video directamente a través de Qwen Chat para experimentar de forma inmersiva el potente rendimiento del nuevo modelo Qwen2.5-Omni.

Qwen Chat:https://chat.qwenlm.ai

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

Experiencia Demo:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo