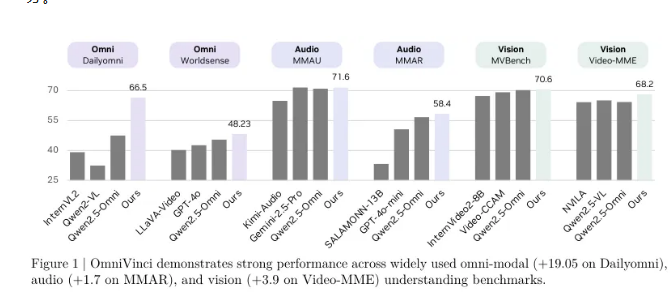

El equipo de investigación de NVIDIA ha lanzado hoy un modelo de comprensión multimodal llamado OmniVinci, que ha obtenido resultados sorprendentes en benchmarks clave de comprensión multimodal, superando a los modelos de vanguardia existentes en 19.05 puntos. Más aún, OmniVinci utilizó solo 1/6 de los datos de entrenamiento, demostrando una eficiencia y rendimiento excepcionales.

El objetivo de OmniVinci es crear un sistema de IA versátil capaz de comprender visual, auditivo y textual, permitiendo que las máquinas perciban y comprendan el mundo complejo como lo hacen los humanos a través de varios sentidos. Para lograr este objetivo, el equipo de NVIDIA adoptó diseños innovadores de arquitectura y estrategias de gestión de datos, fusionando la información de diferentes sentidos en un espacio potencial multimodal uniforme, logrando así comprensión y razonamiento cruzamodal.

En el benchmark Dailyomni, el rendimiento de OmniVinci superó a Qwen2.5-Omni, obteniendo 1.7 puntos más en la prueba MMAR de comprensión auditiva y 3.9 puntos más en la prueba Video-MME de comprensión visual. El número de tokens de entrenamiento utilizado fue de 0.2 billones, mientras que Qwen2.5-Omni utilizó 1.2 billones, mostrando que la eficiencia de entrenamiento de OmniVinci es seis veces mayor.

La innovación central del modelo es el mecanismo de alineación multimodal, que incluye tres tecnologías: el módulo OmniAlignNet, el agrupamiento de entradas temporales (TEG) y la entrada temporal girada con restricciones (CRTE). OmniAlignNet utiliza la complementariedad entre señales visuales y auditivas para fortalecer su aprendizaje y alineación. Mientras tanto, TEG codifica eficazmente las relaciones temporales agrupando la información visual y auditiva por tiempo. CRTE resuelve aún más el problema de alineación temporal, asegurando que el modelo pueda comprender la información de tiempo absoluto de los eventos.

El equipo de investigación utilizó un método de entrenamiento en dos etapas, primero entrenando de forma específica por modalidad y luego realizando un entrenamiento conjunto multimodal para mejorar gradualmente la capacidad del modelo para comprender múltiples modalidades. En cuanto al aprendizaje implícito multimodal, los investigadores mejoraron aún más la capacidad del modelo para comprender conjuntamente audio y video mediante conjuntos de datos de preguntas y respuestas de videos existentes.