Le groupe de recherche d'Apple a récemment proposé une méthode innovante de formation appelée « Reinforcement Learning basé sur des listes de vérification » (RLCF), qui remplace le mécanisme traditionnel de notation humaine par un ensemble spécifique de tâches, améliorant ainsi considérablement la capacité des modèles de langage à exécuter des instructions complexes.

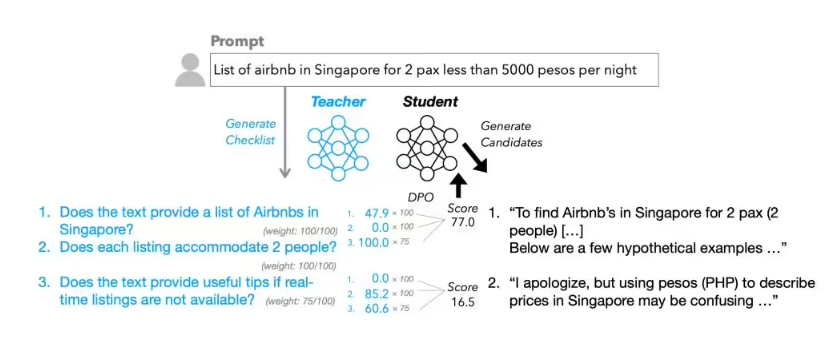

On apprend que RLCF signifie « Reinforcement Learning from Checklist Feedback », ce qui constitue une alternative nette aux méthodes largement utilisées comme le « Reinforcement Learning avec feedback humain » (RLHF). Les méthodes RLHF traditionnelles reposent principalement sur des évaluations simples de type « j'aime » ou « je n'aime pas » fournies par les humains. En revanche, RLCF génère pour chaque instruction utilisateur une liste détaillée de vérification et évalue chaque élément selon une échelle allant de 0 à 100 points, servant ainsi de référence pour l'optimisation du modèle.

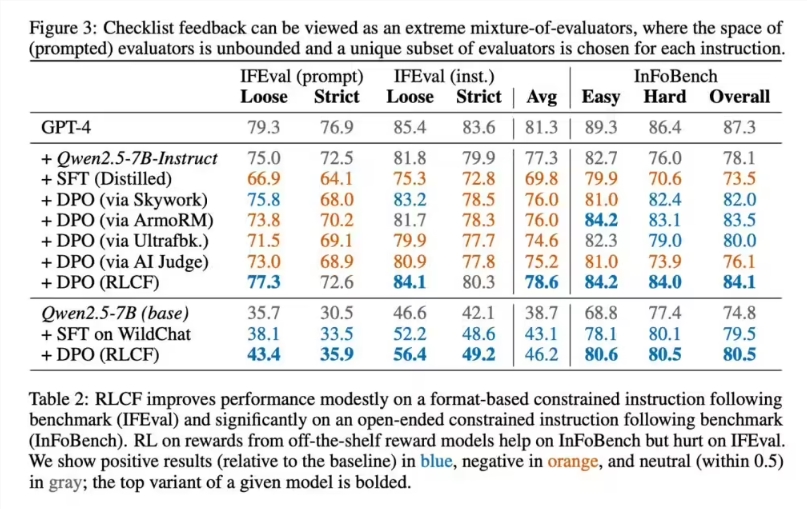

Le groupe de recherche d'Apple a choisi le modèle Qwen2.5-7B-Instruct, connu pour sa capacité à suivre des instructions, comme objet d'essai et a effectué une validation complète sur cinq benchmarks courants. Les résultats montrent que RLCF est la seule méthode qui a amélioré les performances dans tous les tests.

Les données spécifiques indiquent qu’avec FollowBench, le taux de satisfaction rigoureuse a augmenté de 4 points. Le score InFoBench a augmenté de 6 points, et le taux de victoire Arena-Hard a augmenté de 3 points. Dans certaines tâches spécifiques, l'amélioration de la performance a atteint jusqu'à 8,2 %. Ces données montrent que la méthode de feedback sous forme de liste se distingue particulièrement lorsqu'il s'agit de traiter des tâches complexes en plusieurs étapes.

En termes de réalisation technique, le processus de génération de listes du groupe Apple est très innovant. Ils ont utilisé un modèle plus vaste, Qwen2.5-72B-Instruct, combiné à des méthodes existantes, pour créer un jeu de données spécial nommé « WildChecklists » comprenant 130 000 instructions. Le contenu des listes est constitué d'éléments de jugement binaire clairs, comme « est-ce traduit en espagnol ? ». Ensuite, le grand modèle évalue chaque réponse candidate point par point, puis produit un signal de récompense pour la formation en combinant pondéré.

Cependant, les chercheurs d'Apple ont également reconnu honnêtement les limites de cette méthode. Premièrement, RLCF nécessite un modèle plus puissant comme critère d'évaluation, ce qui peut poser des difficultés d'implémentation dans des scénarios où les ressources informatiques sont limitées. Deuxièmement, cette méthode est conçue spécifiquement pour améliorer la capacité d'exécution d'instructions complexes et non pour la sécurité alignée, donc elle ne peut pas remplacer les mécanismes actuels d'évaluation et d'optimisation de la sécurité. L'applicabilité de cette méthode pour d'autres types de tâches AI doit encore être validée par des expériences supplémentaires.

Les experts du secteur estiment que la méthode RLCF proposée par Apple offre une nouvelle perspective pour l'entraînement des modèles d'IA, notamment un avantage net dans la gestion de tâches complexes en plusieurs étapes. Avec l'amélioration continue de la technologie, cette méthode devrait jouer un rôle plus important dans les applications pratiques.