एंथ्रोपिक कंपनी अपने बड़े भाषा मॉडल (LLM) के सुरक्षा जाल में विशाल संभावनाओं के बारे में अपने प्रयासों को आगे बढ़ा रही है और वास्तविक स्थिति के डेटा के साथ AI के सॉफ्टवेयर दोषों की खोज में तेजी से उन्नति के बारे में साबित कर रही है। कंपनी ने CyberGym रैंकिंग के परिणामों को उद्धृत किया, जो बताता है कि उसके नए मॉडल ने नेटवर्क सुरक्षा की दक्षता में महत्वपूर्ण कदम उठाया है।

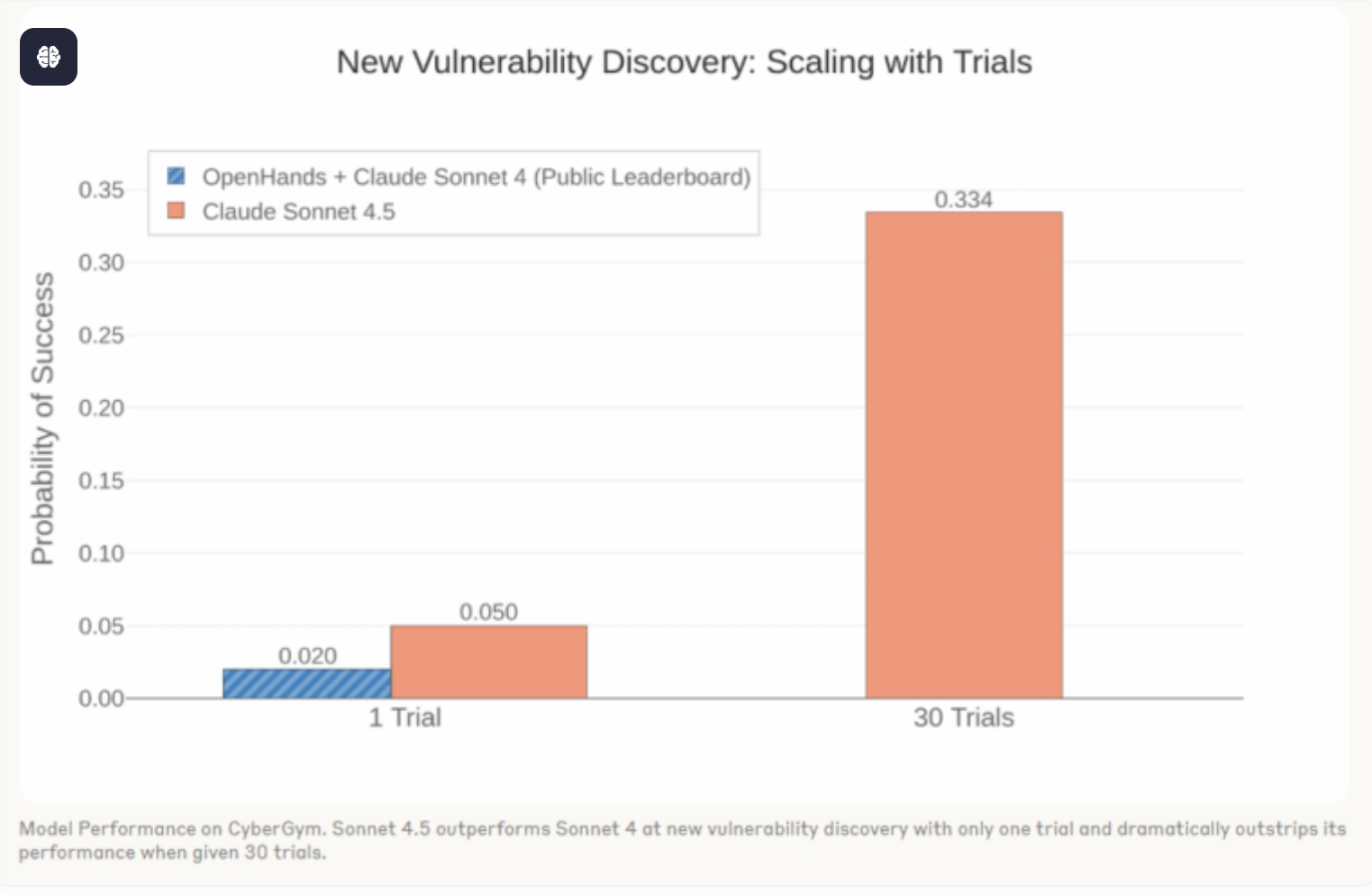

मुख्य आंकड़ों के अनुसार, Claude Sonnet4 के नए सॉफ्टवेयर दोषों की खोज की संभावना लगभग 2% है, जबकि इसके सुधारित संस्करण Sonnet4.5 के लिए यह संभावना तेजी से बढ़कर 5% हो गई है। अधिक ध्यान आकर्षित करने वाली बात यह है कि बार-बार परीक्षण में, Sonnet4.5 ने एक तिहाई से अधिक परियोजनाओं में नए दोषों की खोज की, जो इसके एक "दोष खोज इंजन" के रूप में मजबूत क्षमता को दर्शाता है।

एंथ्रोपिक का मानना है कि यह प्रदर्शन में उछाल "कृत्रिम बुद्धिमत्ता के सुरक्षा जाल पर प्रभाव के महत्वपूर्ण बिंदु" को चिह्नित करता है।

कंपनी आगे बताती है कि हाल के DARPA कृत्रिम बुद्धिमत्ता नेटवर्क चैलेंज में, प्रतियोगी टीमें Claude जैसे LLM का उपयोग करके उन्नत "नेटवर्क अनुमान प्रणाली" बना रही हैं। इन प्रणालियों में सैकड़ों हजार पंक्तियों के कोड की दक्षता से जांच करके ऐसे महत्वपूर्ण दोषों की खोज और स्थान निर्धारण करना संभव हो रहा है।

एंथ्रोपिक के आंकड़े और निरीक्षण दर्शाते हैं कि LLM अब केवल सामग्री जनरेटर टूल नहीं हैं, बल्कि वे सुरक्षा जाल के क्षेत्र में अपरिहार्य विश्लेषण और रक्षा शक्ति बन रहे हैं, जो सॉफ्टवेयर दोषों की खोज और सुधार प्रक्रिया को बुनियादी रूप से बदल सकते हैं।