Alibaba hat kürzlich die Veröffentlichung seines neuesten Video-Generierungsmodells Wan2.1-FLF2V-14B bekannt gegeben, das Open Source ist und die Generierung von 5 Sekunden langen 720p-HD-Videos unterstützt. Dieses Modell hat mit seiner innovativen Technologie zur Steuerung des ersten und letzten Bildes große Aufmerksamkeit erregt und neue Möglichkeiten im Bereich der KI-Videogenerierung geschaffen. Laut AIbase wurde das Modell im Februar 2025 auf GitHub und Hugging Face veröffentlicht und steht Entwicklern, Forschern und Unternehmen weltweit zur kostenlosen Nutzung zur Verfügung. Dies markiert einen weiteren wichtigen Meilenstein für Alibaba im Aufbau eines Open-Source-KI-Ökosystems.

Kernfunktionen: Erstes und letztes Bild steuern, flüssige HD-Videos generieren

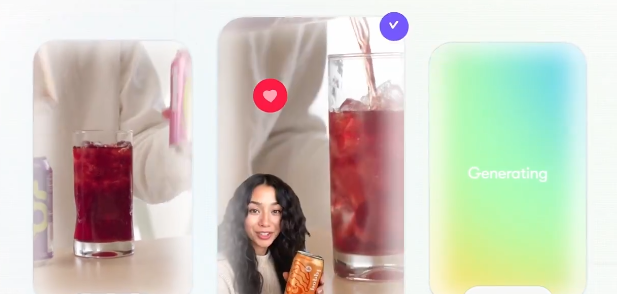

Wan2.1-FLF2V-14B verwendet das erste und letzte Bild als Steuerungsbedingung. Der Benutzer muss lediglich zwei Bilder bereitstellen, und das Modell generiert automatisch ein 5 Sekunden langes Video mit einer Auflösung von 720p. AIbase hat beobachtet, dass das generierte Video eine hervorragende Bewegungsflüssigkeit und einen nahtlosen Übergang zwischen dem ersten und letzten Bild aufweist. Die Bilddetails sind sehr gut an die Referenzbilder angepasst, und die gesamte Inhaltskonsistenz ist deutlich verbessert. Im Vergleich zu herkömmlichen Videogenerierungsmodellen löst dieses Modell durch präzise Steuerung die bei der Generierung langer Videosequenzen häufig auftretenden Probleme wie Bildruckeln und Inhaltsverschiebung und bietet eine effiziente Lösung für die Erstellung hochwertiger Videos.

Technische Highlights: CLIP und DiT-Fusion zur Verbesserung der Stabilität der Generierung

Laut AIbase-Analyse verwendet Wan2.1-FLF2V-14B eine fortschrittliche Technologie zur Steuerung der ersten und letzten Bilder. Der Kern liegt in folgenden Innovationen:

CLIP-Semantikextraktion: Das CLIP-Modell extrahiert semantische Informationen aus dem ersten und letzten Bild, um sicherzustellen, dass der visuelle Inhalt des generierten Videos mit den Eingabebildern übereinstimmt.

Cross-Attention-Mechanismus: Die Merkmale des ersten und letzten Bildes werden in den Generierungsprozess des Diffusion Transformer (DiT) integriert, um die Bildstabilität und die Kohärenz der Zeitreihe zu verbessern.

Datengesteuertes Training: Das Modell wurde auf einem riesigen Datensatz von 150 Millionen Videos und 1 Milliarde Bildern trainiert und kann dynamische Inhalte generieren, die den realen physikalischen Gesetzen entsprechen.

Diese Kombination aus Technologien ermöglicht es Wan2.1-FLF2V-14B, komplexe Bewegungsszenen hervorragend zu generieren, insbesondere für kreative Anwendungen, die einen hochpräzisen Übergang erfordern.

Breiter Einsatz: Unterstützung der Inhaltserstellung und Forschung

Die Veröffentlichung von Wan2.1-FLF2V-14B als Open Source bietet vielversprechende Anwendungsmöglichkeiten in verschiedenen Bereichen. AIbase hat die wichtigsten Anwendungsszenarien zusammengestellt:

Film und Werbung: Schnelle Generierung hochwertiger Übergangsvideos, um die Kosten der Nachbearbeitung zu senken.

Spielentwicklung: Generierung dynamischer Zwischensequenzen für Spielszenen, um die Entwicklungseffizienz zu steigern.

Bildung und Forschung: Unterstützung von Forschern bei der Erforschung von Videogenerierungstechnologien und der Entwicklung neuer KI-Anwendungen.

Personalisierte Kreation: Normale Benutzer können durch einfache Eingabe personalisierte Kurzvideos erstellen und soziale Medien-Inhalte bereichern.

Es ist erwähnenswert, dass das Modell die Generierung von Prompts in chinesischer Sprache unterstützt und insbesondere bei der Bearbeitung chinesischer Szenen eine bessere Leistung zeigt. Dies verdeutlicht seine Anpassungsfähigkeit an mehrsprachige Umgebungen.

Einfacher Einstieg: Kompatibel mit Konsumer-Hardware

Wan2.1-FLF2V-14B zeigt eine hohe Kompatibilität in Bezug auf die Hardwareanforderungen. AIbase hat erfahren, dass das Modell trotz seiner Größe von 1,4 Milliarden Parametern durch Optimierung auf Geräten mit Consumer-GPUs wie RTX4090 ausgeführt werden kann. Der benötigte Videospeicher beträgt nur 8,19 GB. Die Generierung eines 5 Sekunden langen 480p-Videos dauert nur etwa 4 Minuten, und die Generierungszeit für 720p-Videos bleibt im angemessenen Bereich. Darüber hinaus bietet das Modell eine detaillierte Bereitstellungsanleitung, mit der Benutzer das Modell schnell mit folgendem Befehl starten können:

python

python generate.py --task flf2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-FLF2V-14B --first_frame examples/first.jpg --last_frame examples/last.jpg --prompt "Ein sanfter Übergang von einem sonnigen Strand zu einer sternenklaren Nacht"

Die Open-Source-Community bietet auch eine Gradio-basierte Web-Benutzeroberfläche, um die Nutzung für Nicht-Techniker weiter zu vereinfachen.

Community-Feedback und Zukunftsaussichten

Seit seiner Veröffentlichung hat Wan2.1-FLF2V-14B in der Open-Source-Community für großes Aufsehen gesorgt. Entwickler loben die Qualität der Generierung, die Hardware-Kompatibilität und die Open-Source-Strategie. AIbase hat festgestellt, dass die Community bereits mit der Weiterentwicklung des Modells begonnen hat und komplexere Videobearbeitungsfunktionen wie die Generierung dynamischer Untertitel und mehrsprachige Synchronisation erforscht. Zukünftig plant Alibaba, das Modell weiter zu optimieren, um die Unterstützung für höhere Auflösungen (z. B. 8K) und längere Videos zu ermöglichen und gleichzeitig die Anwendungen in Bereichen wie Video-zu-Audio (V2A) zu erweitern.

Projekt-Adresse: https://github.com/Wan-Video/Wan2.1

![Black Forest begeistert mit Open-Source-FLUX.1 Kontext [dev]: Bildbearbeitung im Gleichschritt mit GPT-4o](https://upload.chinaz.com/2025/0627/6388661124441853705469566.png)