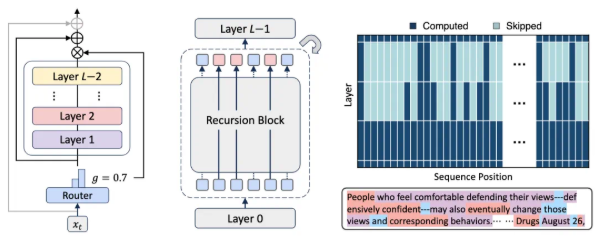

最近の研究で、OpenAI、Meta、Google、Anthropicなどの企業が開発した言語モデルが、匿名テキストの分析を通じて、ユーザーの個人情報(人種、職業、居住地など)を85~95%の精度で推測できることが判明しました。

研究者らは、これらの言語モデルが悪用されるリスクがあり、匿名ユーザーのプライバシー侵害につながる可能性があると警告しています。

専門家は、関連企業に対し、より広範なプライバシー保護対策を講じるよう推奨しています。具体的には、言語モデルの推論能力を制限し、ユーザーの情報セキュリティ意識を高めることで、チャットボット利用時の個人情報漏洩を防ぐ必要があります。