La inteligencia artificial está revolucionando diversas industrias a un ritmo asombroso, y el sector de la producción de video no es una excepción. Recientemente, la aparición de modelos de generación de video con IA ha generado un gran interés, e incluso algunos afirman que cambiará radicalmente el futuro de Hollywood.

Sin embargo, ¿cuál es la capacidad real de esta tecnología? Investigadores de la Universidad China de Hong Kong y Tencent, a través del proyecto "VideoGen-Eval", realizaron una evaluación exhaustiva de los modelos de generación de video con IA más populares, revelando el nivel real de esta tecnología emergente.

El equipo de investigación probó los modelos de generación de video con IA desde múltiples perspectivas, incluyendo la coherencia entre texto y video, la composición de la imagen, las transiciones de escena, la creatividad, la estilización, la estabilidad y la diversidad de movimientos. Los resultados mostraron que, aunque la IA ha logrado avances significativos en algunos aspectos, aún queda un largo camino por recorrer para alcanzar la perfección.

Comparativa general de los principales modelos de video:

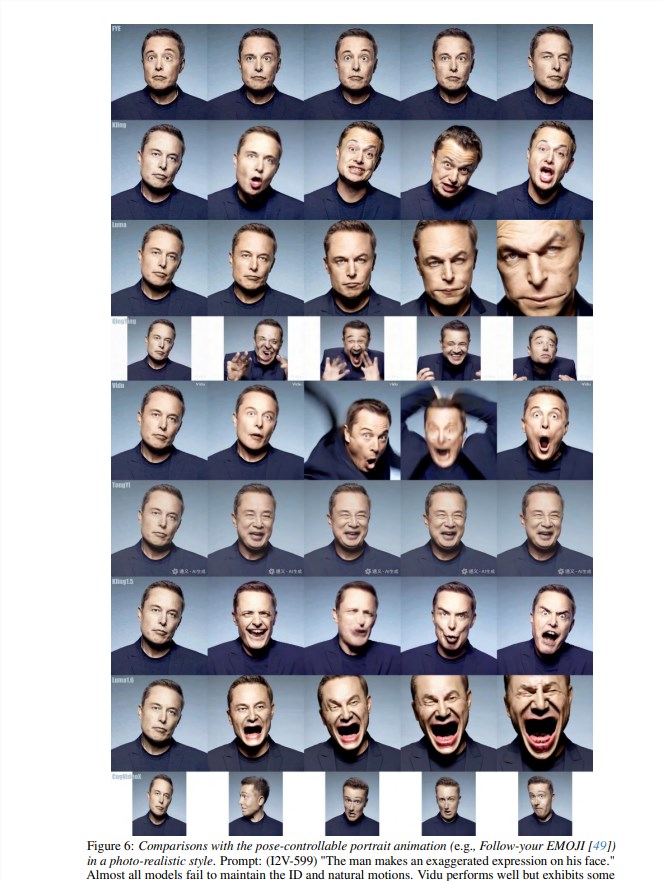

En la generación de video a partir de texto (T2V), Gen-3, Kling v1.5 y Minimax destacaron, siendo Minimax especialmente sobresaliente en el control del texto, particularmente en la expresión facial de los personajes, la cinematografía, la generación de múltiples tomas y la dinámica del sujeto principal.

Gen-3 sobresalió en el control de la iluminación, la textura y las técnicas cinematográficas, mientras que Kling v1.5 logró un buen equilibrio entre efectos visuales, controlabilidad y capacidad de movimiento.

Pika1.5 destacó en la generación de efectos de video específicos, como la expansión, fusión y explosión.

Comparación de videos:

Indicación: Cámara estática, una bola de cristal rueda sobre una mesa lisa

Indicación: Toma aérea FPV, el sol brilla sobre las montañas nevadas, ambiente tranquilo

Indicación: Acercamiento ultrarrápido a una rosa roja mostrando los detalles de sus pétalos

Actualmente, existen dos tipos principales de modelos de generación de video con IA en el mercado: de código cerrado y de código abierto. Los modelos de código cerrado son como los secretos mejor guardados de las empresas de alta tecnología, como Gen-3 de Runway y Dream Machine de LumaLabs. Estos modelos suelen generar videos de mayor calidad y con funciones más potentes, pero requieren un pago para su uso.

Los modelos de código abierto, por otro lado, son como las artes marciales en el mundo de las artes marciales, accesibles para todos. Ejemplos de ello son Open-Sora y EasyAnimate. Aunque su rendimiento puede ser inferior al de los modelos de código cerrado, su ventaja radica en ser gratuitos y de código abierto, permitiendo la participación de todos.

El proyecto "VideoGen-Eval" probó varios modelos de generación de video con IA, incluyendo tres aspectos: generación de video a partir de texto (T2V), generación de video a partir de imagen (I2V) y generación de video a partir de video (V2V). Los resultados revelaron que, aunque estos modelos han logrado grandes avances en algunos aspectos, como la calidad de imagen, la naturalidad del movimiento y la correspondencia con la descripción del texto, aún están lejos de la perfección que imaginamos.

Empezando por las ventajas, la IA actual ya puede generar videos simples. Por ejemplo, si introduces "un oso de peluche caminando en un supermercado, la cámara gira en sentido antihorario", la IA puede generar un video de un oso de peluche con una cámara rotatoria. ¿No suena mágico? Sin embargo, si intentas que la IA genere escenas complejas, como "una persona nadando en una piscina, salpicando agua" o "tres monos saltando en un bosque, dos loros volando entre los árboles", la IA comienza a fallar.

La razón principal es que la IA aún no comprende bien las leyes de la física, las relaciones espaciales y las propiedades de los objetos. Por ejemplo, si le pides a la IA que genere un video de "una bola de cristal rodando sobre una mesa", la IA puede no saber cómo debe rodar la bola para cumplir con las leyes de la física, y el video resultante será extraño.

Además, la IA tiene grandes problemas para manejar movimientos rápidos, expresiones faciales e interacciones entre múltiples personajes. Por ejemplo, si quieres que la IA genere un video de un partido de béisbol, la imagen generada por la IA puede ser muy extraña, con movimientos de personajes completamente descoordinados, e incluso la pelota puede volar hasta el cielo.

Ni hablar de las escenas que requieren imaginación y creatividad por parte de la IA. Por ejemplo, si quieres que la IA genere un video de "una persona rodeada de humo multicolor", la IA probablemente solo generará un montón de colores desordenados, sin que se pueda discernir qué es. En resumen, ninguno de los modelos actuales puede lograr la perfección, y todavía existen grandes desafíos en el manejo de movimientos complejos, interacciones entre múltiples objetos, simulación física, comprensión semántica y control preciso.

Para ver el video de evaluación completo, haga clic aquí: https://ailab-cvc.github.io/VideoGen-Eval/#text-to-video