DeepSeek ha lanzado silenciosamente su nuevo modelo de lenguaje grande, DeepSeek-V3-0324, causando un gran revuelo en la industria de la inteligencia artificial. Este modelo, con una capacidad de 641 GB, apareció inesperadamente en la biblioteca de modelos de IA Hugging Face, casi sin publicidad previa, manteniendo el estilo de lanzamiento discreto pero altamente impactante de la compañía.

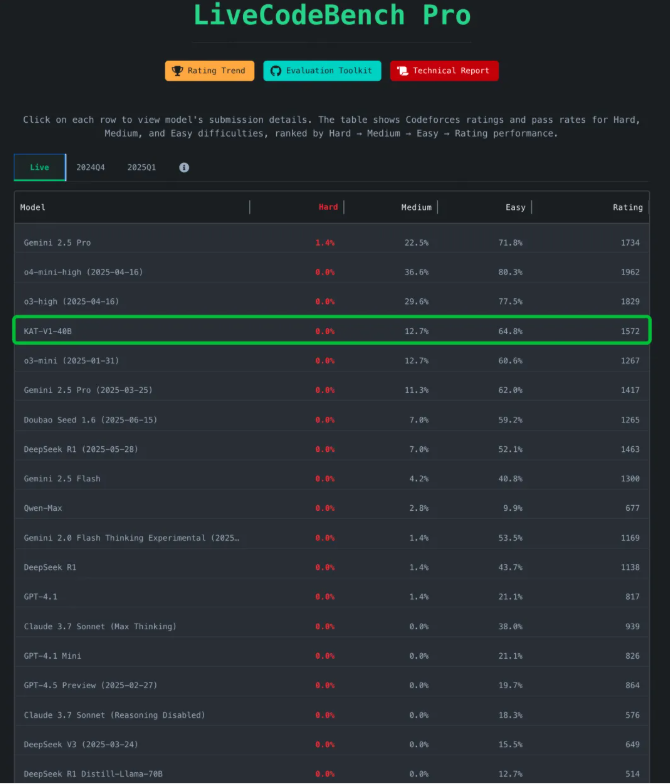

Un salto en el rendimiento, comparable a Claude Sonnet3.5

El lanzamiento de DeepSeek-V3 es notable no solo por sus potentes funciones, sino también por su método de implementación y su licencia. Los probadores iniciales informan de mejoras significativas en todos los indicadores.

El investigador de IA Xeophon declaró en la plataforma X que DeepSeek V3 en sus pruebas internas "mostró un salto enorme en todos los indicadores de todas las pruebas", afirmando que ahora es el "mejor modelo sin inferencia, superando a Sonnet3.5". Si esta afirmación se verifica ampliamente, el nuevo modelo de DeepSeek superaría a Claude Sonnet3.5, el respetado sistema de IA comercial de Anthropic.

Código abierto y comercial, para el beneficio de todos: rompiendo las barreras de pago

A diferencia de Sonnet, que requiere suscripción, los pesos del modelo DeepSeek-V3-0324 son completamente gratuitos y cualquiera puede descargarlos y usarlos.

Más importante aún, el modelo utiliza la licencia MIT, lo que significa que se puede utilizar libremente con fines comerciales. Esta postura abierta contrasta con la práctica habitual de las empresas de IA occidentales de colocar sus modelos tras un muro de pago.

Arquitectura MoE y dos grandes avances

La innovadora arquitectura de DeepSeek V3-0324 ha logrado una eficiencia incomparable. El modelo emplea una arquitectura de experto mixto (MoE), cambiando radicalmente la forma en que funcionan los modelos de lenguaje grandes. A diferencia de los modelos tradicionales que activan todos los parámetros en cada tarea, el enfoque de DeepSeek activa solo alrededor de 37 mil millones de sus 685 mil millones de parámetros en tareas específicas. Esta activación selectiva representa un cambio enorme en la eficiencia del modelo, logrando un rendimiento comparable a modelos más grandes completamente activados, mientras reduce significativamente las necesidades de cálculo.

Además, el modelo incorpora dos tecnologías innovadoras adicionales: atención potencial de múltiples cabezas (MLA) y predicción de múltiples tokens (MTP). MLA mejora la capacidad del modelo para mantener el contexto en textos largos, mientras que MTP puede generar múltiples tokens por paso, en lugar del habitual uno por paso. Estas innovaciones juntas aumentaron la velocidad de salida en casi un 80%.

Amigable con el hardware, ejecución local: también se puede manejar en dispositivos de consumo

El creador de herramientas para desarrolladores Simon Willison señaló en una entrada de blog que una versión cuantificada de 4 bits reduce el espacio de almacenamiento a 352 GB, lo que permite su ejecución en hardware de consumo de gama alta (como una Mac Studio con chip M3 Ultra).

El investigador de IA Awni Hannun escribió en las redes sociales: "¡El nuevo DeepSeek-V3-0324 se ejecuta a >20 tokens/segundo en una M3 Ultra de 512 GB con mlx-lm!". Aunque una Mac Studio de 9499 dólares puede estar más allá de la definición de "hardware de consumo", ejecutar un modelo tan grande localmente contrasta con la IA más reciente que suele requerir infraestructura de IA a nivel de centro de datos.

El consumo de energía de la Mac Studio durante el proceso de inferencia es inferior a 200 vatios, mientras que la infraestructura de IA tradicional suele depender de varios GPU Nvidia que consumen miles de vatios.

Cambio de estilo, más centrado en la tecnología

Los usuarios iniciales informan de un cambio notable en el estilo de comunicación del nuevo modelo. Los modelos DeepSeek anteriores fueron elogiados por su tono conversacional y similar al humano, mientras que "V3-0324" presenta un estilo más formal y técnico.

Algunos usuarios en Reddit expresaron este cambio, opinando que la nueva versión suena "menos humana", perdiendo el "tono humano" de las versiones anteriores. Este cambio puede reflejar una decisión de diseño consciente de los ingenieros de DeepSeek, destinada a reposicionar el modelo para aplicaciones más profesionales y técnicas.

La estrategia de lanzamiento de DeepSeek refleja las diferencias fundamentales en las ideas comerciales de IA entre las empresas chinas y occidentales. Los líderes estadounidenses como OpenAI y Anthropic colocan sus modelos tras un muro de pago, mientras que las empresas de IA chinas se inclinan cada vez más por licencias de código abierto más permisivas.

Esta apertura está cambiando rápidamente el ecosistema de IA de China, permitiendo a las startups, investigadores y desarrolladores innovar sobre la base de tecnología de IA avanzada sin grandes gastos de capital. Los gigantes tecnológicos chinos, incluidos Baidu, Alibaba y Tencent, también están lanzando o planean lanzar modelos de IA de código abierto. Con la limitación en el acceso a los chips Nvidia de vanguardia, las empresas chinas dan más importancia a la eficiencia y la optimización, lo que se convierte en una ventaja competitiva potencial.

El lanzamiento de DeepSeek-V3-0324 también se considera la base de su modelo de inferencia de próxima generación, DeepSeek-R2.

Teniendo en cuenta que el CEO de Nvidia, Jensen Huang, señaló recientemente que el modelo R1 de DeepSeek "consume 100 veces más capacidad de cálculo que la IA sin inferencia", el logro de DeepSeek en cuanto a rendimiento en condiciones de recursos limitados es notable.

Si DeepSeek-R2 sigue la trayectoria del R1, podría representar un desafío directo al rumoreado GPT-5 de OpenAI. Esta estrategia abierta y eficiente en recursos de DeepSeek, en comparación con la estrategia cerrada y con abundante capital de OpenAI, representa dos visiones competitivas del futuro de la inteligencia artificial.

Actualmente, los usuarios pueden descargar los pesos completos del modelo a través de Hugging Face, o experimentar la interfaz API de DeepSeek-V3-0324 a través de plataformas como OpenRouter. Su propia interfaz de chat también puede haberse actualizado a la nueva versión. La estrategia abierta de DeepSeek está redefiniendo el panorama mundial de la IA, presagiando una era de innovación en IA más abierta y accesible.

https://huggingface.co/deepseek-ai/DeepSeek-V3-0324