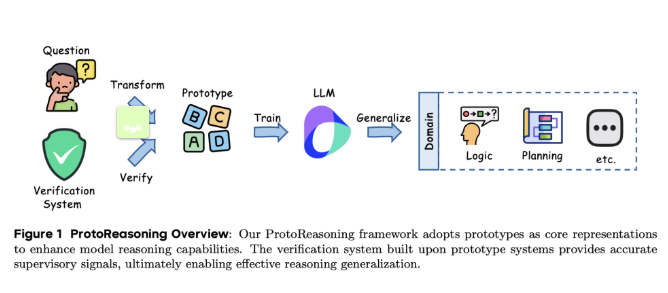

Recentemente, a equipe de pesquisa da ByteDance e a Universidade de Ciência e Tecnologia de Xangai apresentou um novo framework chamado ProtoReasoning, que visa melhorar a capacidade de raciocínio de modelos de linguagem grandes (LLMs) por meio de protótipos lógicos. Esse framework utiliza representações estruturadas de protótipos, como Prolog e PDDL, promovendo avanços no raciocínio transversal.

Nos últimos anos, os modelos de linguagem grandes obtiveram avanços significativos no raciocínio transversal, especialmente com a aplicação de tecnologias de raciocínio em cadeia longa. Estudos mostraram que esses modelos demonstraram habilidades excepcionais em tarefas como matemática e programação, bem como em áreas aparentemente não relacionadas, como problemas lógicos e escrita criativa. No entanto, as razões por trás dessa flexibilidade ainda não estão totalmente claras. Uma possível explicação é que esses modelos aprendem padrões de raciocínio fundamentais, ou seja, protótipos de raciocínio abstrato transversal, que podem ajudar os modelos a lidar melhor com diferentes tipos de problemas.

O framework ProtoReasoning melhora a capacidade de raciocínio do modelo utilizando representações estruturadas de protótipos, incluindo dois módulos principais: o construtor de protótipos e o sistema de validação. O construtor de protótipos converte perguntas em linguagem natural em representações formalizadas, enquanto o sistema de validação verifica a correção das soluções. Na aplicação do Prolog, os pesquisadores desenvolveram um pipeline de quatro etapas, gerando uma variedade de problemas lógicos e validando-os com SWI-Prolog. Para tarefas de planejamento, a equipe de pesquisa utilizou o PDDL para construir tarefas de geração, conclusão e reorganização de planos, e realizou verificações de corretude com o validador VAL.

A avaliação do framework ProtoReasoning utilizou um modelo especialista com 150 bilhões de parâmetros (sendo 15 bilhões ativos), treinado em amostras de alta qualidade de Prolog e PDDL cuidadosamente selecionadas. Os resultados mostraram melhorias significativas no raciocínio lógico, planejamento e em várias métricas de benchmark. Em particular, experimentos comparativos com a versão em linguagem natural mostraram que o treinamento com base em Prolog teve desempenho próximo ao da versão em linguagem natural no raciocínio lógico, reforçando a eficácia do treinamento com protótipos estruturados.

O framework ProtoReasoning demonstrou o papel importante dos protótipos de raciocínio abstrato na transferência de conhecimento transversal em modelos de linguagem grandes. Embora os resultados dos experimentos sejam promissores, ainda há necessidade de investigações teóricas mais profundas sobre as propriedades específicas dos protótipos de raciocínio. Pesquisas futuras se concentrarão em formalizar matematicamente esses conceitos e validar os resultados experimentais usando modelos e conjuntos de dados open source.

Artigo: https://arxiv.org/abs/2506.15211

Destaque:

🌟 O framework ProtoReasoning utiliza Prolog e PDDL para melhorar a capacidade de raciocínio lógico dos modelos de linguagem grandes.

🧠 Por meio de representações estruturadas de protótipos, o modelo obteve melhorias significativas em tarefas de raciocínio lógico, planejamento e resolução geral de problemas.

🔍 As pesquisas futuras explorarão a base teórica dos protótipos de raciocínio e validarão a eficácia dos resultados experimentais.