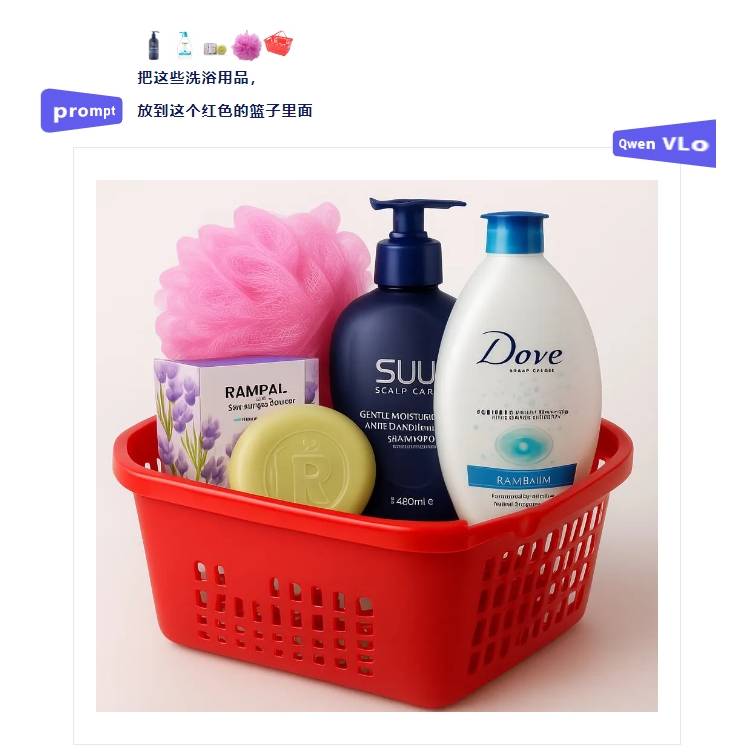

Pesquisadores apresentaram um novo método de prompt visual chamado SoM, que aprimora o desempenho do modelo multimodal GPT-4V da OpenAI em tarefas visuais de grão fino. O SoM utiliza um modelo de segmentação interativo para dividir a imagem em diferentes regiões e adicionar marcadores a cada uma delas. Dessa forma, o GPT-4V consegue entender melhor os objetos e as relações espaciais na imagem, superando o desempenho de modelos especializados e outros modelos multimodais de código aberto em diversas tarefas visuais. Esta pesquisa demonstra o potencial do GPT-4V em tarefas visuais de grão fino.

Novo método de prompt visual SoM aprimora a precisão e o detalhamento do GPT-4V

站长之家

Este artigo é do AIbase Daily

Bem-vindo à coluna [AI Daily]! Este é o seu guia para explorar o mundo da inteligência artificial todos os dias. Todos os dias apresentamos os destaques da área de IA, com foco nos desenvolvedores, para o ajudar a obter insights sobre as tendências tecnológicas e a compreender as aplicações inovadoras de produtos de IA.

![FLUX.1 Kontext [dev] da Black Forest impressiona com código aberto: edição de imagem comparável ao GPT-4o](https://upload.chinaz.com/2025/0627/6388661124441853705469566.png)

![O recurso de código aberto chegou! FLUX.1 Kontext [dev] desafia o GPT-4o e entra em uma nova era de edição de imagens](https://upload.chinaz.com/2025/0627/6388661110722937329608910.png)