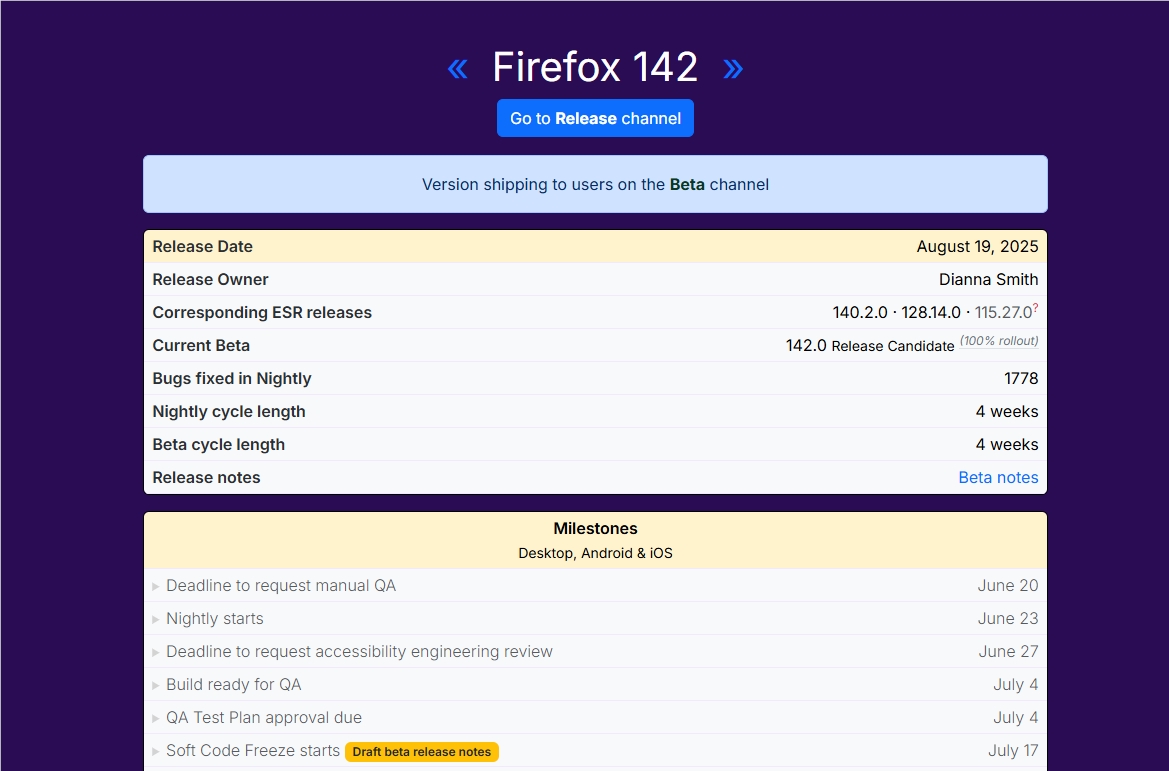

Im Bereich der Künstlichen Intelligenz (KI) entsteht gerade eine bahnbrechende Technologie. Inception Labs hat kürzlich die Mercury-Serie von Diffusions-Large-Language-Models (dLLMs) vorgestellt, eine neue Generation von Sprachmodellen, die darauf ausgelegt sind, schnell und effizient hochwertige Texte zu generieren. Im Vergleich zu traditionellen autoregressiven Large-Language-Models ist Mercury bis zu 10-mal schneller und erreicht auf einer NVIDIA H100-Grafikkarte eine Geschwindigkeit von über 1000 Token pro Sekunde – eine Geschwindigkeit, die bisher nur mit kundenspezifischen Chips erreichbar war.

Das erste Produkt der Mercury-Serie, Mercury Coder, ist bereits in der öffentlichen Testphase. Dieses Modell konzentriert sich auf die Codegenerierung und zeigt eine herausragende Leistung. In mehreren Programmier-Benchmark-Tests übertraf es viele bestehende, auf Geschwindigkeit optimierte Modelle wie GPT-4o Mini und Claude3.5Haiku und war dabei fast 10-mal schneller. Entwicklerfeedback zeigt, dass die Code-Vervollständigungen von Mercury besser ankommen. Im Copilot Arena Test erreichte Mercury Coder Mini einen Spitzenplatz und zählt zu den schnellsten Modellen.

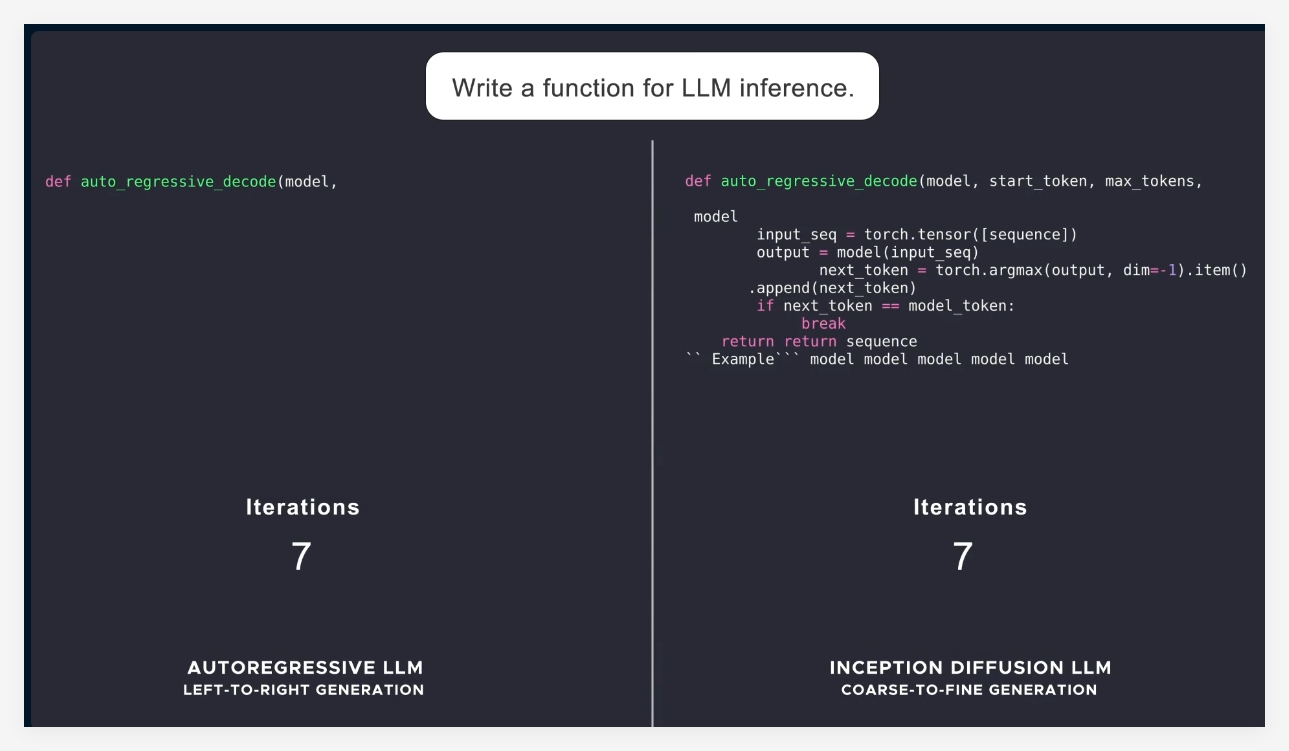

Die meisten aktuellen Sprachmodelle verwenden eine autoregressive Methode, d.h. sie generieren Token von links nach rechts nacheinander. Dies führt zwangsläufig zu einem sequentiellen Prozess mit hoher Latenz und hohen Rechenkosten. Mercury hingegen verwendet einen „grob zu fein“-Ansatz. Es beginnt mit reinem Rauschen und verfeinert die Ausgabe schrittweise durch mehrere „Entrauschungs“-Schritte. Dadurch kann das Mercury-Modell bei der Generierung eine parallele Verarbeitung mehrerer Token durchführen, was zu einer besseren Inferenz und strukturierten Antworten führt.

Mit der Einführung der Mercury-Serie zeigt Inception Labs das enorme Potenzial von Diffusionsmodellen im Bereich der Text- und Codegenerierung. Als nächstes plant das Unternehmen die Einführung von Sprachmodellen für Chat-Anwendungen, um die Anwendungsszenarien von Diffusions-Sprachmodellen weiter zu erweitern. Diese neuen Modelle werden über stärkere intelligente Agentenfähigkeiten verfügen und komplexe Planungen und langfristige Generierungen ermöglichen. Ihre Effizienz ermöglicht zudem den Betrieb auf ressourcenbeschränkten Geräten wie Smartphones und Laptops.

Zusammenfassend lässt sich sagen, dass die Einführung von Mercury einen wichtigen Fortschritt in der KI-Technologie darstellt, der nicht nur Geschwindigkeit und Effizienz deutlich verbessert, sondern der Branche auch qualitativ hochwertigere Lösungen bietet.

Offizielle Informationen: https://www.inceptionlabs.ai/news

Online-Demo: https://chat.inceptionlabs.ai/

Wichtigste Punkte:

🌟 Einführung der Mercury-Serie von Diffusions-Large-Language-Models (dLLMs) mit einer Generierungsgeschwindigkeit von über 1000 Token pro Sekunde.

🚀 Mercury Coder konzentriert sich auf die Codegenerierung und liefert in Benchmark-Tests herausragende Ergebnisse, die viele bestehende Modelle übertreffen.

💡 Die innovative Methode der Diffusionsmodelle ermöglicht eine effizientere und präzisere Textgenerierung und eröffnet neue Möglichkeiten für intelligente Agentenanwendungen.