Das Seed-Team von ByteDance kündigte kürzlich die Einführung des 3D-Generativ-Modells Seed3D 1.0 an. Das Modell kann hochwertige Simulationsebenen 3D-Modelle aus einer einzelnen Bildaufnahme end-to-end generieren, einschließlich detaillierter Geometrie, realistischer Textur und physikbasiertem Rendering (PBR)-Material. Dieses innovative Ergebnis könnte eine starke Unterstützung für die Entwicklung von Embodied Intelligence bieten und Probleme bei der physischen Interaktivität und der Inhaltsvielfalt in der aktuellen Technologie lösen.

Während der Entwicklungsphase sammelte und verarbeitete das Seed-Team umfangreiche hochwertige 3D-Daten und baute eine vollständige dreistufige Datenverarbeitungslinie auf, um große Mengen heterogener Rohdaten in ein hochwertiges Trainingsdataset zu verwandeln. Seed3D 1.0 verwendet ein Modell basierend auf der Diffusion Transformer-Architektur und ermöglicht durch eine end-to-end-Technik die schnelle Generierung von Simulationsebenen 3D-Modellen aus einem einzelnen Bild. Das Modell zeigt hervorragende Leistung bei der geometrischen Generierung, kann strukturelle Details präzise konstruieren und die physikalische Integrität gewährleisten; bei der Generierung von Texturen und Texturkarten ermöglicht die mehrmodale Diffusion Transformer-Architektur die Konsistenz zwischen verschiedenen Blickwinkeln; bei der Generierung von PBR-Materialien wird ein Schätzungsrahmen verwendet, um die Genauigkeit der Materialschätzung zu verbessern.

Die Generierungsfähigkeiten von Seed3D 1.0 zeigten sich in verschiedenen Vergleichsbewertungen deutlich überlegen. Bei der geometrischen Generierung übertraf das Seed3D 1.0 mit 1,5 Milliarden Parametern Modelle der Branche mit 3 Milliarden Parametern und konnte komplexe Objekte genauer reproduzieren. Bei der Generierung von Textur- und Materialien zeigte sich Seed3D 1.0 gut in Bezug auf die Erhaltung der Referenzbilder, insbesondere bei der Generierung feiner Texte und Personen. Die Ergebnisse der menschlichen Bewertung zeigten, dass Seed3D 1.0 in mehreren Dimensionen wie der geometrischen Qualität, den Materialien, der visuellen Klarheit und der Detailreichhaltigkeit gute Bewertungen erhielt.

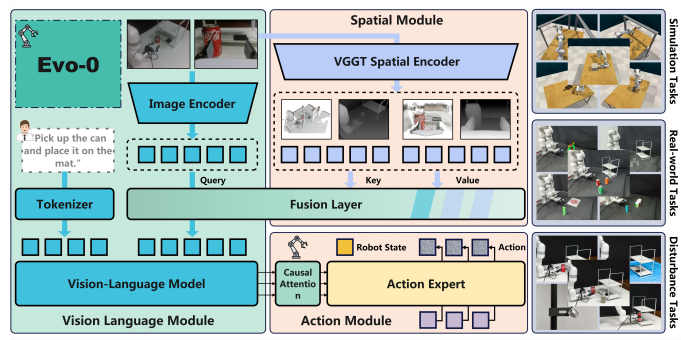

Seed3D 1.0 kann nicht nur 3D-Modelle einzelner Objekte generieren, sondern auch durch strategische Schritt-für-Schritt-Generierung vollständige 3D-Szenen erstellen. Die generierten 3D-Modelle können nahtlos in Simulationsengine-Systeme wie Isaac Sim importiert werden und benötigen nur geringfügige Anpassungen, um die Ausbildung großer Modelle für Embodied Intelligence zu unterstützen. Diese Fähigkeit bietet für Robotik-Training vielfältige Szenarien für Operationen, ermöglicht interaktives Lernen und etabliert eine umfassende Bewertungsgrundlage für visuelle- Sprach- und Handlungsmodelle.

Obwohl Seed3D 1.0 bei der Generierung von 3D-Modellen und -Szenen gute Leistungen zeigte, erkannte das Seed-Team auch, dass es noch Herausforderungen bei der Aufstellung eines Weltmodells auf Basis von 3D-Generativ-Modellen gibt, darunter die Notwendigkeit, die Generierungsgenauigkeit und die Verallgemeinerung weiter zu verbessern. In Zukunft wird das Team versuchen, Multimodal-Größensprachmodelle (MLLM) einzuführen, um die Qualität und Robustheit der 3D-Generierung zu verbessern, und die großflächige Anwendung von 3D-Generationsmodellen in Welt-Simulatoren voranzutreiben.

Projektseite:

https://seed.bytedance.com/seed3d

Eingangspunkt zum Testen:

https://console.volcengine.com/ark/region:ark+cn-beijing/experience/vision?modelId=doubao-seed3d-1-0-250928&tab=Gen3D