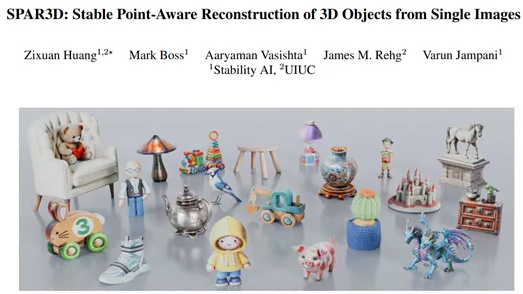

Das Non-Profit-Forschungslabor des KI-Startups Cohere hat diese Woche ein multimodales „offenes“ KI-Modell namens Aya Vision veröffentlicht. Das Labor behauptet, dass das Modell branchenführend ist.

Aya Vision kann verschiedene Aufgaben ausführen, darunter das Erstellen von Bildunterschriften, das Beantworten von Fragen zu Fotos, das Übersetzen von Texten und das Erstellen von Zusammenfassungen in 23 wichtigen Sprachen. Cohere gibt an, Aya Vision über WhatsApp kostenlos zur Verfügung zu stellen, um Forschern weltweit einen einfacheren Zugang zu technologischen Durchbrüchen zu ermöglichen.

Cohere weist in seinem Blog darauf hin, dass es trotz der bemerkenswerten Fortschritte in der KI immer noch große Unterschiede in der Leistung von Modellen zwischen verschiedenen Sprachen gibt, insbesondere bei multimodalen Aufgaben, die Text und Bilder betreffen. „Das Ziel von Aya Vision ist es, diese Lücke zu schließen.“

Aya Vision gibt es in zwei Versionen: Aya Vision 32B und Aya Vision 8B. Die fortschrittlichere Version, Aya Vision 32B, wird als „neue Grenze“ bezeichnet und übertrifft in einigen Benchmarks zum visuellen Verständnis sogar Modelle, die doppelt so groß sind, darunter Metas Llama-3.290B Vision. Gleichzeitig übertrifft Aya Vision 8B in einigen Bewertungen auch Modelle, die zehnmal größer sind.

Beide Modelle werden auf der KI-Entwicklungsplattform Hugging Face unter der Creative Commons 4.0-Lizenz bereitgestellt. Die Nutzer müssen sich an den Anhang zu den akzeptablen Nutzungsbedingungen von Cohere halten und dürfen die Modelle nicht für kommerzielle Zwecke verwenden.

Cohere erklärt, dass Aya Vision mit einem „vielfältigen“ englischen Datensatz trainiert wurde, der übersetzt und mit synthetischen Annotationen trainiert wurde. Synthetische Annotationen sind von der KI generierte Annotationen, die dem Modell helfen, Daten während des Trainings zu verstehen und zu interpretieren. Obwohl synthetische Daten potenzielle Nachteile haben, verwenden immer mehr Wettbewerber wie OpenAI synthetische Daten zum Trainieren von Modellen.

Cohere betont, dass das Training von Aya Vision mit synthetischen Annotationen es ermöglicht hat, Ressourcen zu sparen und gleichzeitig wettbewerbsfähige Ergebnisse zu erzielen. „Dies zeigt unser Engagement für Effizienz, indem wir mit weniger Rechenressourcen mehr erreichen.“

Um die Forschung weiter zu unterstützen, hat Cohere auch ein neues Benchmark-Tool namens AyaVisionBench veröffentlicht, das die Fähigkeiten des Modells bei Aufgaben zur Kombination von visuellen und sprachlichen Informationen bewertet, z. B. das Erkennen von Unterschieden zwischen zwei Bildern und das Umwandeln von Screenshots in Code.

Derzeit steht die KI-Branche vor einer sogenannten „Bewertungskrise“, die hauptsächlich auf die weit verbreitete Verwendung beliebter Benchmarks zurückzuführen ist, deren Gesamtpunktzahl nur wenig mit den Fähigkeiten bei den meisten Aufgaben korreliert, die für KI-Nutzer relevant sind. Cohere behauptet, dass AyaVisionBench einen „umfassenden und anspruchsvollen“ Rahmen für die Bewertung des mehrsprachigen und multimodalen Verständnisses von Modellen bietet.

Offizieller Blog: https://cohere.com/blog/aya-vision

Highlights:

🌟 Aya Vision wird von Cohere als branchenführendes Modell bezeichnet und kann verschiedene sprachliche und visuelle Aufgaben ausführen.

💡 Aya Vision gibt es in zwei Versionen, 32B und 8B, die größere Konkurrenzmodelle übertreffen.

🔍 Cohere hat auch das neue Benchmark-Tool AyaVisionBench veröffentlicht, um die Probleme bei der Bewertung von KI-Modellen zu verbessern.