En el campo de la inteligencia artificial, los modelos de recompensa son un componente clave para alinear los grandes modelos de lenguaje (LLMs) con las retroalimentaciones humanas, pero los modelos actuales enfrentan el problema de "hackers de recompensa".

Estos modelos suelen enfocarse en características superficiales, como la longitud o el formato de las respuestas, en lugar de identificar métricas reales de calidad, como la precisión factual y la relevancia. La raíz del problema radica en que los objetivos estándar de entrenamiento no pueden distinguir entre asociaciones falsas presentes en los datos de entrenamiento y factores causales reales. Este fracaso lleva a modelos de recompensa frágiles (RMs), lo que genera estrategias desalineadas. Para resolver este problema, se necesita un nuevo método que utilice el entendimiento causal para entrenar los RMs, de manera que sean sensibles a las propiedades de calidad causal y resistentes a diversas pistas falsas.

Los métodos actuales de modelos de recompensa intentan resolver el problema de "hackers de recompensa" en los sistemas estándar RLHF que dependen de los métodos de Bradley-Terry o de clasificación por pares, incluyendo modificaciones en la arquitectura, ajustes a nivel de estrategia y métodos centrados en datos que involucran conjuntos o verificaciones de coherencia. Los métodos recientes inspirados en la causalidad utilizan regularización MMD para abordar factores falsos predefinidos, o corrigiendo la estimación de efectos causales mediante reescrituras. Sin embargo, estos métodos solo se enfocan en factores falsos predefinidos y no capturan asociaciones desconocidas. Aunque las estrategias mejoradas aún son bastante groseras y los métodos centrados en la evaluación no proporcionan un mecanismo de entrenamiento robusto para los modelos de recompensa frente a variaciones falsas diversas.

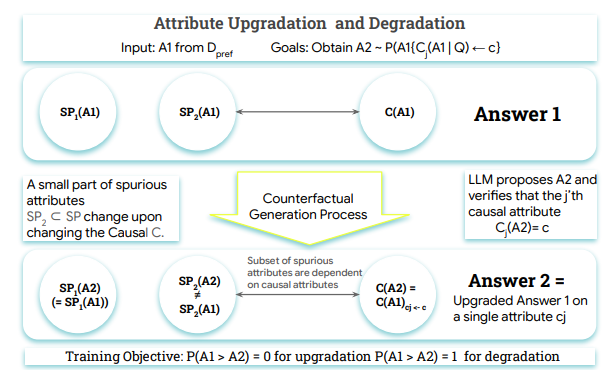

Para enfrentar estos desafíos, investigadores de Google DeepMind, la Universidad McGill y MILA - Instituto de Inteligencia Artificial de Quebec han propuesto Crome (Modelado de Recompensas Robusto por Causalidad). El marco Crome se basa en un modelo causal explícito para la generación de respuestas, entrenando los RMs mediante un conjunto de datos de preferencias que incluyen ejemplos contracuálicos generados por modelos de lenguaje grandes, con el fin de diferenciar los factores reales de calidad de las señales superficiales. Además, Crome crea dos tipos de pares de entrenamiento sintéticos: aumentos causales (Causal Augmentations) y aumentos neutrales (Neutral Augmentations), lo que mejora la robustez del modelo y maximiza la precisión de la base de recompensas.

El funcionamiento de Crome se divide en dos fases principales: generar datos contrafácticos con conciencia de atributos basados en un modelo causal y entrenar el modelo de recompensa mediante una pérdida específica sobre los datos combinados. Al evaluar el rendimiento, los investigadores utilizaron varios LLM básicos, incluyendo Gemma-2-9B-IT y Qwen2.5-7B, logrando mejoras significativas en el rendimiento.

Crome muestra un excelente desempeño en múltiples benchmarks, especialmente en seguridad y capacidad de razonamiento, logrando avances notables. Además, demostró un buen desempeño en WildGuardTest, reduciendo la tasa de éxito de ataques a preguntas dañinas, mientras mantenía una tasa de rechazo similar para preguntas benignas.

En el futuro, la investigación de Crome se enfocará en la ampliación de datos causal, impulsando la generación de datos sintéticos y ofreciendo nuevas posibilidades para el entrenamiento de modelos básicos.

Paper: https://arxiv.org/abs/2506.16507

Destacados:

🌟 El marco Crome fue propuesto por instituciones como Google DeepMind, con el objetivo de mejorar la robustez de los modelos de recompensa.

📈 Crome ha mejorado significativamente el desempeño del modelo en varias tareas mediante estrategias de aumento causal y aumento neutral.

🔒 Crome ha demostrado un excelente desempeño en pruebas de seguridad, reduciendo la tasa de éxito de ataques y mejorando la confiabilidad del modelo.