Kürzlich hat Nvidia einen neuen kleinen Sprachmodell namens Nemotron-Nano-9B-v2 vorgestellt, der in verschiedenen Benchmarks gut abschneidet und dessen Inferenzfunktion flexibel ein- und ausgeschaltet werden kann. Der Modellparameterumfang beträgt 9 Milliarden, was eine erhebliche Reduzierung gegenüber den 12 Milliarden Parametern des Vorgängers darstellt und darauf abzielt, die Anforderungen eines einzelnen Nvidia A10-GPUs zu erfüllen.

Oleksii Kuchiaev, Leiter der Nachtrainingsentwicklung von Nvidias AI-Modellen, sagte, dass dieser Modell speziell für den A10GPU optimiert wurde und eine bis zu sechsmal höhere Verarbeitungsgeschwindigkeit ermöglicht, was ihn für verschiedene Anwendungsfälle geeignet macht. Nemotron-Nano-9B-v2 unterstützt mehrere Sprachen, einschließlich Englisch, Deutsch, Spanisch, Französisch, Italienisch, Japanisch sowie erweiterte Sprachen wie Koreanisch, Portugiesisch, Russisch und Chinesisch, und ist für Befehlsfolge und Codegenerierung geeignet.

Der Modell basiert auf der Nemotron-H-Serie und kombiniert Mamba- und Transformer-Architekturen, wodurch der Speicher- und Rechenaufwand bei der Verarbeitung langer Sequenzen reduziert wird. Im Gegensatz zu traditionellen Transformer-Modellen verwendet der Nemotron-H-Modell eine ausgewählte Zustandsraummodell (SSM), das die Genauigkeit gewährleistet und gleichzeitig effizientere Verarbeitung längerer Informationssequenzen ermöglicht.

Beim Inferenzprozess kann Nemotron-Nano-9B-v2 standardmäßig eine Nachverfolgung des Inferenzprozesses generieren. Benutzer können diese Funktion auch mit einfachen Steuerungsbefehlen wie /think oder /no_think aktivieren oder deaktivieren. Darüber hinaus wurde eine „Denkbudget“-Verwaltung zur Laufzeit eingeführt, die es Entwicklern ermöglicht, die maximale Anzahl der Token beim Inferenzprozess festzulegen, um ein Gleichgewicht zwischen Genauigkeit und Antwortgeschwindigkeit zu erreichen.

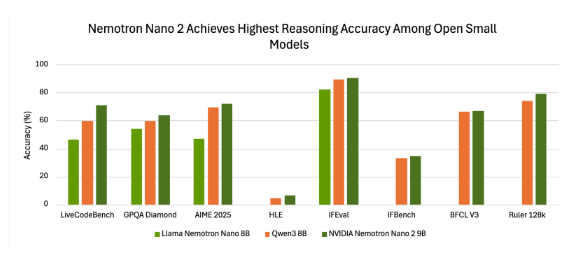

In Benchmark-Tests zeigte Nemotron-Nano-9B-v2 eine gute Genauigkeit. Zum Beispiel schnitt der Modell in verschiedenen Tests sehr gut ab, wenn er im „Inferenz aktiviert“-Modus mit dem NeMo-Skills-Kit verwendet wurde, was seine Vorteile gegenüber anderen kleineren Open-Source-Modellen zeigt.

Nvidia veröffentlichte Nemotron-Nano-9B-v2 unter einer offenen Modelllizenz, die kommerzielle Nutzung erlaubt und Entwicklern freie Erstellung und Verteilung abgeleiteter Modelle ermöglicht. Es ist erwähnenswert, dass Nvidia keine Ansprüche an die Ausgaben des Modells erhebt und die Nutzer vollständig Kontrolle über deren Nutzung haben.

Die Veröffentlichung dieses Modells zielt darauf ab, Entwicklern Werkzeuge zu bieten, um in kleineren Umgebungen die Inferenzfähigkeit und die Effizienz der Bereitstellung zu balancieren, und markiert Nvidias kontinuierliche Bemühungen, die Effizienz und die steuerbare Inferenzfähigkeit von Sprachmodellen zu verbessern.

huggingface:https://huggingface.co/nvidia/NVIDIA-Nemotron-Nano-9B-v2

Wichtige Punkte:

🌟 Nvidia hat ein neues kleines Sprachmodell namens Nemotron-Nano-9B-v2 vorgestellt, das es Benutzern ermöglicht, die Inferenzfunktion flexibel zu steuern.

⚙️ Dieses Modell basiert auf einer fortschrittlichen Hybridarchitektur und kann lange Sequenzen effizient verarbeiten, wodurch es für multilinguale Aufgaben geeignet ist.

📊 Nemotron-Nano-9B-v2 wurde unter einer offenen Modelllizenz veröffentlicht, die es Entwicklern ermöglicht, kommerzielle Nutzung und die Erstellung abgeleiteter Modelle vorzunehmen.