Am 31. August gab das Shanghai Artificial Intelligence Laboratory (Shanghai AI Lab) die Open-Source-Veröffentlichung des multimodalen Großmodells Shu Shen · Wanxiang InternVL3.5 bekannt. Das Modell erreicht eine umfassende Verbesserung der Inferenzfähigkeit, der Bereitstellungseffizienz und der Allgemeinfähigkeit durch innovative Techniken wie kaskadenförmiges Verstärkendes Lernen (Cascade RL), dynamische visuelle Auflösungsroute und dekupelte Bereitstellungsarchitektur. InternVL3.5 veröffentlichte vollständige Versionen mit Parametern von 1B bis 241B und setzte damit neue Leistungsgrenzen für Open-Source-Modelle, wobei es in verschiedenen Aufgaben führend ist.

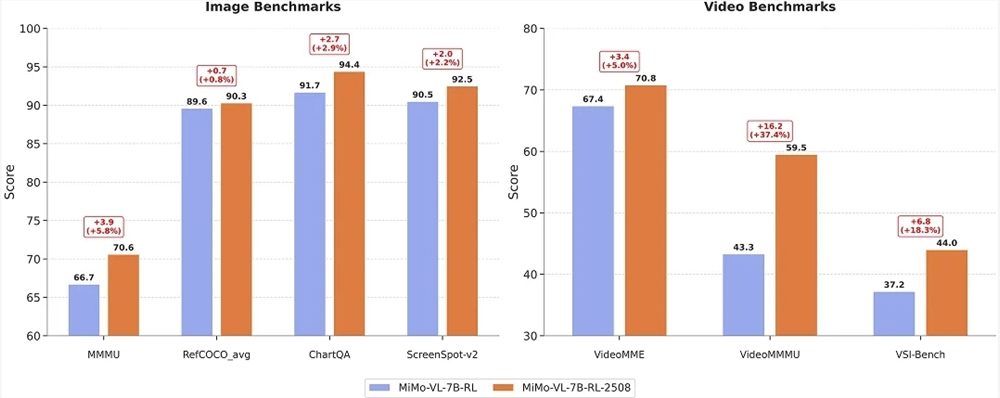

Das Flaggschiff-Modell InternVL3.5-241B-A28B erzielte bei der multidisziplinären Schlussfolgerungsbenchmarks MMMU den höchsten Punktestand unter Open-Source-Modellen mit 77,7 Punkten. Bei den multimodalen allgemeinen Wahrnehmungsbenchmarks MMStar und OCRBench erzielte es jeweils 77,9 beziehungsweise 90,7 Punkte und übertraf GPT-5 (75,7 Punkte/80,7 Punkte). Bei den Textschlussfolgerungsbenchmarks AIME25 und MMLU-Pro erreichte es 75,6 beziehungsweise 81,3 Punkte und war in allen bestehenden Open-Source-Multimodal-Modellen führend. Dank des kaskadenförmigen Verstärkenden Lernrahmens verbesserte sich die Inferenzleistung der gesamten Modellreihe im Durchschnitt um 16,0 Punkte. Insbesondere erreichte das Modell InternVL3.5-241B-A28B eine Gesamtleistung von 66,9 Punkten, was höher ist als die Leistung des vorherigen Modells von 54,6 Punkten und die von Claude-3.7-Sonnet mit 53,9 Punkten. Es zeigte sich besonders stark bei komplexen Aufgaben wie mathematischer und logischer Schlussfolgerung.

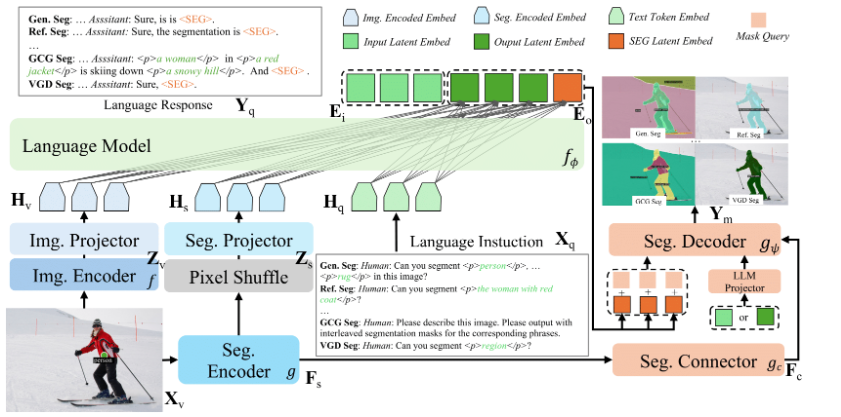

Mit innovativen Techniken wie visueller Auflösungsroute (ViR) und dekupelter Bereitstellungsarchitektur (DvD) wurde die Reaktionsgeschwindigkeit des 38B-Modells bei einer Auflösung von 896 deutlich verbessert. Die Verzögerung pro Inferenz wurde von 369 ms auf 91 ms reduziert (ein vierfacher Anstieg). Gleichzeitig kann das leichtgewichtige InternVL3.5-Flash bei einer Reduzierung der visuellen Sequenzlänge um 50 % nahezu 100 % der Leistung beibehalten.

InternVL3.5 hat auch die Kernkompetenzen der GUI-Agenten, Embodied Agents, SVG-Grafikverarbeitung und -generierung gestärkt. In Aufgaben wie ScreenSpot GUI-Positionierung (92,9 Punkte), VSI-Bench-Raumlogik (69,5 Punkte) und SGP-Bench-Vektorgrafik-Verständnis (70,6 Punkte) übertraf es die führenden Open-Source-Modelle.

InternVL3.5 bietet neun Modelle mit Parametern zwischen 1 Milliarde und 241 Milliarden und deckt unterschiedliche Ressourcenbedürfnisse ab. Es enthält dichte Modelle sowie Experten-Mischmodelle (MoE) und ist das erste Open-Source-Multimodal-Modell, das den GPT-OSS-Sprachmodell-Grundstein unterstützt. Der offizielle Code für die Ausführung von InternVL3.5-8B mit `transformers` ist verfügbar. Das Modell kann auf einer einzelnen A100-GPU bereitgestellt werden, während das 38B-Modell zwei A100-GPUs benötigt und das 235B-Modell acht A100-GPUs.

ms-swift unterstützt bereits die Trainierung der InternVL3.5-Reihe. ms-swift ist ein Framework für die Trainings- und Bereitstellung großer Modelle und multimodaler Modelle, das vom Ma Community angeboten wird. Benutzer können ihre Daten in einem bestimmten Format vorbereiten, um benutzerdefinierte Datensätze zu feintunen. Nach Abschluss des Trainings können sie entsprechende Befehle verwenden, um Inferenzen durchzuführen und das Modell auf ModelScope zu pushen.

Die Veröffentlichung von InternVL3.5 markiert einen weiteren wichtigen Fortschritt in der Technologie multimodaler Großmodelle und bietet Forschern und Entwicklern ein leistungsstarkes Werkzeug, um die Entwicklung multimodaler KI voranzutreiben.

Code-Open-Source / Modellnutzung:

https://github.com/OpenGVLab/InternVL

Modellkatalog:

https://www.modelscope.cn/collections/InternVL35-Full-3871e58bf21349

Online-Erfahrung:

https://chat.intern-ai.org.cn/