Kürzlich hat das LongCat-Team von Meituan offiziell eine intelligente Agenten-Bewertungsbenchmark namens VitaBench veröffentlicht. Ziel ist es, Multi-Interaktion-Aufgaben zu bewerten, insbesondere in komplexen Alltagsszenarien. Die Einführung von VitaBench bietet eine wichtige Infrastruktur für die Entwicklung von Agenten im realen Leben.

VitaBench konzentriert sich auf häufige echte Szenarien wie Lieferbestellungen, Restaurantbesuche und Reisen, und schafft ein interaktives Bewertungsumfeld mit 66 Werkzeugen. Die Bewertungsaufgaben umfassen komplexe Aktionen wie Ticketkauf und Restaurantreservierung und verlangen von den Agenten eine umfassende Leistung bei tiefem Denken, Werkzeugaufrufen und Benutzerinteraktion während des Aufgabenausführungsprozesses.

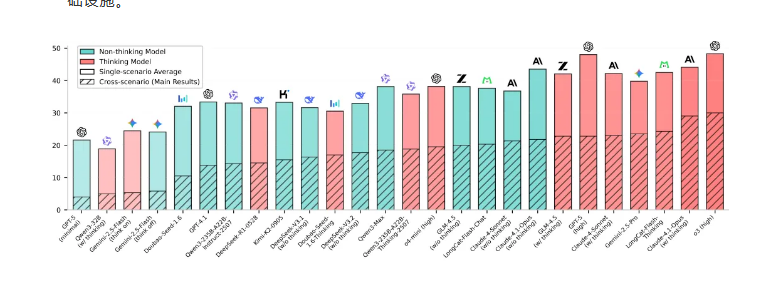

Obwohl aktuelle führende Inferenzmodelle gewisse Fortschritte erzielt haben, zeigt die Forschung des LongCat-Teams, dass die Erfolgsrate von Agenten bei komplexen Szenarien noch unter 30 % liegt, was einen deutlichen Abstand zwischen der aktuellen Technologie und den Anforderungen der praktischen Anwendung zeigt. Die Entwicklung von VitaBench zielt darauf ab, diese Lücke zu schließen und die Lücke zwischen bestehenden Bewertungsbenchmarks für Agenten und der Anwendung in realen Lebensszenarien zu überbrücken.

Die Gestaltung dieser Benchmark basiert auf einer detaillierten Analyse der drei Dimensionen der Inferenzkomplexität, Werkzeugkomplexität und Interaktionskomplexität. Das Team quantifizierte diese Dimensionen, um systematisch die Leistung der Agenten in realen Szenarien zu bewerten. Zum Beispiel wird die Inferenzkomplexität hauptsächlich anhand der Notwendigkeit zur Informationsintegration, der Größe des Beobachtungsraums und der Anzahl der erforderlichen Schlussfolgerungen bewertet; die Werkzeugkomplexität berücksichtigt die Abhängigkeiten der Werkzeuge und die Länge der Aufrufkette; die Interaktionskomplexität betrachtet die Fähigkeit des Agenten, in mehrstufigen Gesprächen zu reagieren.

Der Aufbau von VitaBench erfolgt in zwei Phasen: zunächst die Definition der Tools, dann die Erstellung von Aufgaben und die Festlegung von Bewertungskriterien. Dieser Prozess stellt die Vielfalt und Komplexität der Aufgaben sicher und vermeidet gleichzeitig die Grenzen des traditionellen Dokumentmodells, sodass Agenten in einem Umfeld ohne redundante Regeln eigenständig Schlussfolgerungen ziehen und Entscheidungen treffen können.

VitaBench ist derzeit vollständig open source. Forscher und Entwickler können über die offizielle Website und GitHub auf die entsprechenden Ressourcen zugreifen. Die Veröffentlichung von VitaBench markiert einen wichtigen Meilenstein im Bereich der Bewertung von Agenten und wird voraussichtlich die weitere Anwendung und Entwicklung der Agententechnologie in realen Lebensszenarien vorantreiben.

Projektseite: https://vitabench.github.io

Paper-Link: https://arxiv.org/abs/2509.26490

Code-Repository: https://github.com/meituan-longcat/vitabench

Datensatz: https://huggingface.co/datasets/meituan- longcat/VitaBench

Ranking: https://vitabench.github.io/#Leaderboard