L'équipe de traitement du langage naturel d'Alibaba a annoncé le lancement de WebWatcher, un agent intelligent multi-modale open source conçu pour surmonter les limites des systèmes fermés et des agents open source dans le domaine de la recherche approfondie multi-modale. Grâce à l'intégration de divers outils tels que la navigation sur le web, la recherche d'images, l'interpréteur de code et l'OCR interne, WebWatcher est capable de traiter des tâches complexes multi-modales comme un chercheur humain, démontrant ainsi une forte compréhension visuelle, une raison logique, une utilisation de connaissances, une planification d'outils et une capacité d'autovérification.

Le groupe de développement de WebWatcher souligne que bien que les systèmes fermés existants comme DeepResearch d'OpenAI soient performants dans la recherche textuelle approfondie, ils sont généralement limités à un environnement purement textuel et ont du mal à gérer les images, les graphiques et les contenus mixtes du monde réel. Les agents open source existants rencontrent également deux obstacles majeurs : certains se concentrent sur la recherche de texte, pouvant intégrer des informations mais incapables de traiter les images ; d'autres sont des agents visuels capables de reconnaître les images, mais manquant de raisonnement transmodale et de capacité de collaboration multoutils. WebWatcher a été conçu spécifiquement pour résoudre ces obstacles.

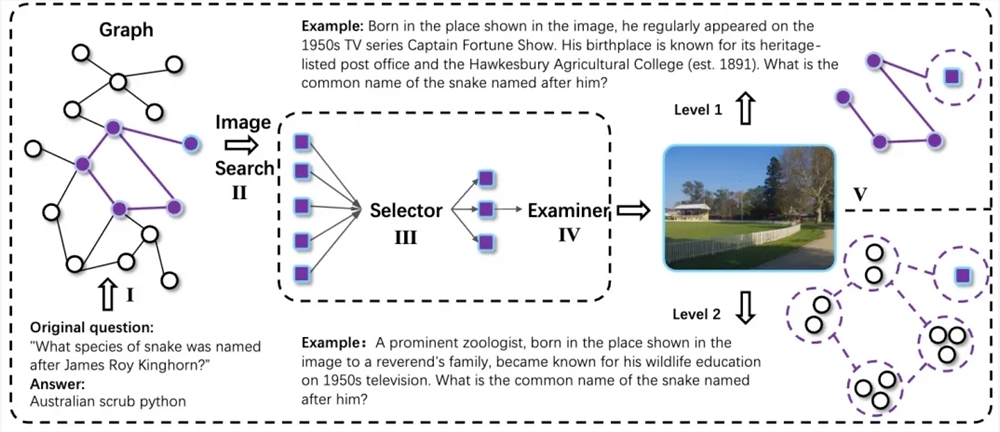

La solution technique de WebWatcher couvre l'ensemble de la chaîne de données, depuis la construction jusqu'à l'optimisation d'entraînement, avec l'objectif principal de permettre à l'agent multi-modale de disposer d'une capacité flexible de raisonnement et de coopération multoutils lors de tâches complexes de recherche multi-modale. Pour cela, l'équipe de recherche a conçu un processus automatique de génération de données multi-modales, collectant des chaînes de connaissances transmodales par un algorithme de marche aléatoire, et introduisant une technologie d'information floue pour augmenter le niveau d'incertitude et de complexité des tâches. Tous les échantillons de problèmes complexes sont étendus en version multi-modale via un module de conversion QA-to-VQA, renforçant ainsi la capacité de compréhension transmodale du modèle.

Pour la construction de trajectoires de raisonnement de haute qualité et l'entraînement postérieur, WebWatcher utilise une méthode de génération de trajectoires basée sur Action-Observation, en collectant des trajectoires d'interaction réelles avec plusieurs outils et en effectuant un ajustement fin supervisé (SFT), permettant au modèle d'apprendre rapidement les bases du raisonnement ReAct multi-modale et de l'utilisation d'outils dès le début de l'entraînement. Ensuite, le modèle entre dans une phase d'apprentissage par renforcement, améliorant davantage sa capacité de prise de décision dans des environnements complexes grâce à GRPO.

Pour vérifier complètement les capacités de WebWatcher, l'équipe de recherche a proposé BrowseComp-VL, une version élargie de BrowseComp pour les tâches visuelles-langagières, conçue pour approcher la difficulté des tâches de recherche transmodale des experts humains. Lors d'évaluations rigoureuses en plusieurs tours, WebWatcher dépasse largement les modèles multi-modaux open source et fermés actuellement dominants dans les tâches de raisonnement complexe, de recherche d'informations, d'intégration de connaissances et d'optimisation d'informations agrégées.

Plus précisément, sur le benchmark HLE-VL (Humanity’s Last Exam), qui est un test multi-étapes de raisonnement complexe, WebWatcher obtient un score Pass@1 de 13,6 %, s'imposant clairement devant des modèles représentatifs tels que GPT-4o (9,8 %), Gemini2.5-flash (9,2 %) et Qwen2.5-VL-72B (8,6 %). Sur l'évaluation MMSearch, plus proche de la recherche multi-modale réelle, WebWatcher atteint un score Pass@1 de 55,3 %, nettement supérieur à celui de Gemini2.5-flash (43,9 %) et de GPT-4o (24,1 %). Sur l'évaluation LiveVQA, WebWatcher obtient un score Pass@1 de 58,7 %, surpassant les autres modèles principaux. Sur le benchmark le plus exigeant BrowseComp-VL, WebWatcher obtient un score moyen de 27,0 % (Pass@1), dépassant largement les autres modèles.

Adresse du dépôt : https://github.com/Alibaba-NLP/WebAgent